I riassunti , gli appunti i testi contenuti nel nostro sito sono messi a disposizione gratuitamente con finalità illustrative didattiche, scientifiche, a carattere sociale, civile e culturale a tutti i possibili interessati secondo il concetto del fair use e con l' obiettivo del rispetto della direttiva europea 2001/29/CE e dell' art. 70 della legge 633/1941 sul diritto d'autore

Le informazioni di medicina e salute contenute nel sito sono di natura generale ed a scopo puramente divulgativo e per questo motivo non possono sostituire in alcun caso il consiglio di un medico (ovvero un soggetto abilitato legalmente alla professione).

Parte I - Insiemi

Prendiamo le mosse, nel nostro itinerario alla ricerca del contenuto della matematica, dai concetti generali, e sostanzialmente "primitivi", di INSIEME e di FUNZIONE, movendoci così su un terreno che potrebbe ancora dirsi aspecifico della nostra particolare disciplina, in quanto comune a ogni scienza che voglia pervenire a una sistemazione concettuale dei fenomeni di sua competenza. Tenendo conto della puntualizzazione kantiana riportata nell'Introduzione, non sarebbe errato ritenere di stare compiendo alcune investigazioni nell'ambito della logica generale.

Concretizziamo tale proposito analizzando avanti tutto la capacità dell'intelletto puramente "logica" di considerare, e quindi trattare, collettività di enti come un unico nuovo ente. Ecco la definizione cantoriana di insieme: [Georg Cantor fu il primo ad occuparsi sistematicamente, dal 1874 in poi, di teoria degli insiemi; andrebbe sottolineato con cura il dettaglio che proprio uno dei settori della matematica ultimo arrivato venga viceversa oggi comunemente accettato quale punto di partenza su cui costruire gradualmente ("fondare") l'intero complesso edificio della matematica.]

<<Per insieme si intende un raggruppamento in un tutto di oggetti ben distinti della nostra intuizione o del nostro pensiero>>.

(I-1) Nota. In quell'aggettivo <<distinti>> presumiamo avvertire echi di cartesianesimo, come pure nel termine <<nostra intuizione>>, che fa implicito riferimento a quelle che potrebbero dirsi le modalità con cui si "struttura" il pensiero umano (una prospettiva antropocentrica sgradevole a certe orecchie postdarwiniste). <<Vi sono anche delle persone che, in tutta la loro vita, non percepiscono nulla come è necessario per bene giudicarne. Poiché la conoscenza sulla quale si può stabilire un giudizio indubbio dev'essere non solo chiara, ma anche distinta. Io chiamo chiara quella che è presente e manifesta [...] ad uno spirito attento [...] E distinta, quella che è talmente precisa e differente da tutte le altre, da non comprendere in sé se non ciò che appare manifestamente a chi la considera come si deve. [...] la conoscenza può essere chiara senza essere distinta, ma non può essere distinta senza essere in pari tempo chiara>> (dai principi NN. 45 e 46, Parte I dei Principia Philosophiae di Cartesio, 1644). <<E' certo che noi non prenderemo mai il falso per vero, fino a che non giudicheremo se non di ciò che percepiamo chiaramente e distintamente>> (dal principio N. 43, Parte I dei Principia...). L'esortazione agli studenti di matematica principianti è di non accettare mai per scontato nulla che non sia chiaro e distinto, secondo la loro esperienza e coscienza.

Gli <<oggetti>> da cui è costituito un insieme si dicono i suoi elementi. Il termine "insieme" ammette diversi sinonimi, che noi cercheremo usualmente di evitare, [Sebbene non sempre, concedendo qualcosa al fenomeno linguistico della ridondanza, che può avere ricadute benefiche sia sul piano estetico, sia su quello "psicologico", a tener desta cioè l'attenzione. Si potrebbe ritenere infatti che un'esposizione troppo "coerente", cioè automatica simil "macchina", potrebbe essere controproducente da un punto di vista didattico, indurre cioè un aumento del livello di sonnolenza da parte del discente.] preferendo riservare a qualcuno di essi un significato più specifico. Essi sono: collezione, collettività, aggregato, totalità, gruppo, classe, famiglia, etc. (è preferibile evitare l'uso degli ultimi tre in particolare).

Dicevamo che quello d'insieme va inteso come un concetto sostanzialmente primitivo, perché non si sente il bisogno (né si sentì nel primo momento della sua introduzione) di dare una "definizione" del concetto di insieme che si poggi a sua volta su altri concetti ad esso preliminari. Soprattutto, non si sente il bisogno di darne una definizione formale ("assiomatica"), mediante un'elencazione delle proprietà di cui godono gli insiemi, osservazione questa che si capirà meglio nel seguito quando da definizioni formali saremo (talora giustamente) sommersi. Citiamo ancora Cartesio: <<vi sono delle nozioni di per se stesse così chiare, che le si oscura volendole definire alla maniera della scuola, e che non s'acquistano con lo studio, ma nascono con noi>> (principio N. 10, Parte I dei Principia...).

Spendiamo appena qualche parola sulla "questione di senso": come si dà un insieme? (ad altri o a noi stessi!), una risposta alla quale domanda deve considerarsi comunque già implicitamente fornita nella definizione cantoriana di insieme, e nella successiva nota (I.1). Un insieme A può considerarsi "dato" quando sia assegnato un "criterio" che permetta di individuare univocamente tutti e soli gli elementi dell'insieme, e vedremo come tale concetto si preciserà (o si estenderà) mano a mano che si acquisterà maggiore dimestichezza con i procedimenti usuali della matematica. E' opportuno però aggiungere sin da ora che si incontreranno sostanzialmente due tipi di "definizione" di un insieme, una più "comune", e una più "rara". Quella che si incontra più frequente consiste nell'individuazione di un'espressione linguistica, o proposizione (costruita mediante le regole del "linguaggio", più o meno formale, che si utilizza), la quale specifichi le proprietà caratterizzanti gli elementi dell'insieme che si vuole definire. Una simile definizione può dirsi sintetica, implicita, nominale (l'importante è comprendersi), o anche, come preferiremo, intensiva, termine che fa riferimento al concetto di "concentrato". Un esempio di definizione intensiva dell'insieme A dei numeri primi naturali non superiori a 20 (per il momento basterà ricordare che si dicono naturali i numeri {1, 2, 3,...}, e che alla loro totalità - infinita - si fa consueto riferimento con il simbolo N; sottolineiamo subito la circostanza che per definire un insieme si usano generalmente delle parentesi graffe) è quella che pone:

A = {x Î N tali che 1 < x £ 20 e x non ha divisori diversi da se stesso e dall'unità} (è usuale non considerare 1 come un numero primo). Per contro, una definizione estensiva dello stesso insieme (estensiva come contrario di intensiva, ma vanno anche bene: esplicita, palese, o, come preferiremo, ostensiva, con chiaro significato del termine - si pensi all'ostensorio nelle chiese cattoliche) è semplicemente la seguente: A = {2, 3, 5, 7, 11, 13, 17, 19}. Si noti che la precedente definizione dell'insieme infinito N era anch'essa ostensiva, e che il simbolo dei tre puntini "..." stava a significare semplicemente che l'interlocutore concepiva benissimo nel suo intelletto cosa dovesse esserci al posto dei puntini. E' ovvio che il primo tipo di definizione ci informa sul criterio con cui A deve concepirsi, ma non di renderci (almeno immediatamente) edotti su quanti e quali siano i suoi elementi. Per esempio, facendo riferimento a un celebre secolare (e tuttora irrisolto) problema di "teoria dei numeri", potremo senz'altro distintamente concepire quello che possiamo denominare l'insieme G dei "numeri di Goldbach", ovvero l'insieme di quei numeri naturali pari che non siano somma di due numeri primi dispari, ma non sapremmo dire se G contiene qualche altro elemento oltre agli ovvi 2 e 4 (sapremmo dire per esempio che G non contiene 6 = 3+3, non contiene 8 = 3+5, non contiene 10 = 5+5 = 3+7, etc.), dal momento che proprio una congettura di Goldbach ipotizza che ogni numero pari superiore a 4 sia sempre somma di due numeri primi dispari. Con il secondo tipo di definizione (che comincia ovviamente a incontrare qualche difficoltà nel caso di insiemi con infiniti elementi) sappiamo invece subito esattamente come è fatto l'insieme di cui trattasi, mentre rischia peraltro di sfuggirci la proprietà "collettivizzante" con cui esso è stato pensato. Si tenga comunque costantemente conto che stiamo parlando di enti del pensiero, e che, laddove la concezione che abbiamo di un qualche ente può (deve) essere chiara e distinta, ci troveremo spesso di fronte al fenomeno dell'inadeguatezza del linguaggio (soprattutto nel caso di enti "infiniti"): <<le language est source de malentendus>> (il linguaggio è all'origine di fraintendimenti), come si osserva in Le petit prince di Antoine de Saint-Exupéry. Però il pensato non va confuso con il parlato, ed anche se l'aspetto comunicativo-formale della matematica è quello più appariscente, è manifesto che essa, quanto a significato-contenuto, appartiene tutta al regno del pensato. Comunque, ci accontenteremo che sia chiara e distinta la procedura di costruzione dell'insieme A, o la specificazione dei suoi oggetti, o anche solo la semplice "esistenza" di A nella nostra mente, in base a certe sue proprietà che ci sembra possano essere sufficienti allo scopo (vedremo nel seguito per esempio l'uso che si fa in questo senso del cosiddetto assioma della scelta). L'idea di fondo è che esistono certi "oggetti" a loro volta primitivi in una sorta di universo (potenziale e indeterminato), e che di essi si possano considerare talune collettività di prima generazione, le quali vanno ad aumentare il numero degli oggetti dell'universo (che va quindi concepito come una "entità" in espansione), sicché insiemi di seconda generazione possono essere costituiti tanto da oggetti primitivi quanto da insiemi di prima generazione. [Per evitare alcuni noti "paradossi di fondazione", ai quali qua e là accenneremo, si eviti di considerare lo stesso universo U come un oggetto primitivo, sicché U non è elemento di se stesso. Se si vuol costruire un insieme di prima generazione che contenga tutti gli oggetti primitivi, lo si chiami pure per esempio U, ma con questa operazione l'universo deve ritenersi "cresciuto"; ovvero, abbiamo adesso un "secondo" universo, denotiamolo U2, che contiene quel "primo" universo U, che allora potrebbe essere denotato con il simbolo U1, etc..] Quale esempio, prendiamo come oggetti primitivi i simboli numerici 1, 2 e 3, e consideriamo gli insiemi di prima generazione:

I = {1, 2}, J = {1, 2, 3}. Possiamo poi senz'altro concepire l'insieme di seconda generazione: A = {1, 2, 3, I} = {1, 2, 3, {1, 2, 3}} (attenzione alle parentesi graffe ripetute!), e così via. Un importante caso particolare di tale procedura è di costruire, a partire da un qualsiasi insieme A, un nuovo insieme {A}, definito come quell'insieme il cui unico elemento sia l'insieme A (quando si è di fronte a un insieme con un unico elemento, si dice che esso è un singleton; nel caso in considerazione si parla allora del singleton di A). Per esempio, possiamo introdurre il singleton di J: {J} = {{1, 2, 3}}.

E' conveniente cominciare a introdurre presto delle scritture simboliche (semplice utile stenografia) per esprimere certe asserzioni.

a Î A si legge: l'oggetto a, di qualsiasi natura esso possa essere, è un elemento dell'insieme A (in ciò che precede si è implicitamente introdotta la convenzione di usare lettere latine maiuscole per gli insiemi, mentre lettere latine minuscole indicheranno di solito gli elementi di un insieme; poiché un insieme può a sua volta essere costituito da insiemi, tale convenzione è però destinata spesso a cadere). Il simbolo Î si dice il simbolo di Peano (dal nome del matematico torinese Giuseppe Peano), o simbolo di appartenenza. Come esempio, notiamo che la scrittura A Î {A} è allora corretta, mentre la scrittura A Î A "di solito" non lo è, per esempio se A è l'insieme {1, 2, 3, I} di cui sopra. Può in tal caso scriversi correttamente A Ï A, una barra trasversale apposta su un simbolo significando la sua negazione.

(I.2) Nota. Nelle righe precedenti si è toccata di sfuggita una questione che ha dato origine a un celebre "paradosso" della teoria degli insiemi (Bertrand Russell, 1902). A tali problematiche daremo un cenno in uno dei capitoli successivi dei presenti Elementi..., ma possiamo dire sin d'ora che, lasciandoci guidare dal criterio delle idee "chiare e distinte", è legittimo concepire un insieme A quando siano stati assegnati in precedenza certi oggetti che andranno a costituire A, il quale "nasce" quindi soltanto dopo quegli oggetti, e non può coincidere pertanto con uno di essi. Come dire che, per ogni insieme A correttamente individuato, non può essere mai A Î A (su un altro simile "rompicapo" logico spenderemo qualche parola tra poco).

Si introducono speciali notazioni simboliche pure per indicare la circostanza che un insieme A sia sottoinsieme di un altro insieme B, ovvero che tutti gli elementi di A siano anche elementi dell'insieme B: A Í B. La barra orizzontale sta a prevedere, come nel caso dei noti simboli di disuguaglianza numerica, minore o uguale £ e maggiore o uguale ³, che i due insiemi in parola possono al limite essere uguali. Si usa invece il simbolo: A Ì B quando si vuole specificare la circostanza che: A Í B e A ¹ B, e si parla in questo caso di un'inclusione propria, o "in senso stretto" (si sottolinea a parole il fatto che una certa inclusione non è, o potrebbe eventualmente non essere, propria, dicendo che essa è impropria, o "in senso lato"). Si osservi che, come è usuale per i predetti simboli di disuguaglianza, tutte le precedenti "relazioni" possono essere scritte anche in senso inverso: A ' a, B Ê A, B É A. Si osservi inoltre, per esempio, che in ordine al singleton {A}, non è vero né che sia {A} Í A (se così fosse, poiché A Î {A}, ne potremmo dedurre A Î A, che abbiamo giudicato assurda nella nota (II.2)), né che sia A Í {A}, tranne un caso particolare che andremo a illustrare (in (I.3)) dopo aver introdotto un nuovo importante concetto.

Tra i sottoinsiemi di un dato insieme A conviene considerare il cosiddetto insieme vuoto, che si designa con il simbolo Æ, e deve ritenersi come quell'unico insieme che è assolutamente privo di elementi, e che in quanto tale deve allora considerarsi come sottoinsieme di ogni insieme. Di conseguenza sono corrette le seguenti scritture: Æ Í A per ogni insieme A, anzi Æ Ì A con inclusione propria, a meno che non sia A stesso l'insieme vuoto, nel qual caso è corretto scrivere Æ Í Æ, ma non è corretto scrivere Æ Ì Æ.

Tanto per rimanere in quest'ambito di considerazioni (che possono a prima vista apparire speciose, ma sono invece assai istruttive e utili), non è corretto scrivere Æ Î Æ, mentre è corretto scrivere sia Æ Î {Æ} sia "ovviamente" Æ Í {Æ}, anzi Æ Ì {Æ}.

L'insieme di tutti i sottoinsiemi di un dato insieme A è un insieme che ricorrerà spesso nelle nostre considerazioni, e si indica con il simbolo P(A), dove la lettera P sta a ricordare che si tratta di "parti" dell'insieme A. Si può scrivere sinteticamente: P(A) = {tutti gli insiemi X ô X Í A}, osservazione che ci consente di introdurre un'altra abbreviazione, una barra verticale ô che si legge "tale (o tali) che" (al posto del simbolo "½" si può usare il simbolo ":", di cui faremo uso talvolta per evitare ripetizioni ravvicinate della barra verticale; ci sono pure altre convenzioni, che noi però ignoreremo). In P(A) sono compresi naturalmente l'insieme vuoto, l'insieme A stesso, tutti i singleton {a} dei diversi elementi di A (allorché A non sia vuoto!), sicché tutte le seguenti asserzioni sono corrette:

X Í A è la stessa cosa che X Î P(A) ; Æ Î P(A) ; A Î P(A) ; per ogni elemento di a, {a} Î P(A).

(Si noti che stiamo in qualche senso introducendo delle regole generative che permettono di asserire l'esistenza nel nostro "universo" di certi enti una volta che ne siano dati degli altri, per esempio il singleton di un insieme A o di un oggetto x una volta che siano dati A o x, l'insieme delle parti P(A) di ogni dato insieme A, etc., oltre a delle vere e proprie asserzioni contenutistiche di esistenza: nell'universo ci deve essere almeno un insieme vuoto Æ, privo cioè di elementi, che risulterà poi anche l'unico insieme privo di elementi, ci devono essere almeno i "numeri" 1, 2, 3,... etc., la scelta è piuttosto "libera".)

Aggiungiamo che risultano entrambe legittime le asserzioni Æ Î P(A) e

Æ Í P(Æ), e che mentre A Î P(A) è pure sempre corretta, invece l'asserzione

A Í P(A) non lo è in generale (vedi (I.3) e (I.7)). Inoltre, che P(A) non è mai vuoto, qualunque sia l'insieme A, compreso il caso A = Æ (l'insieme P(Æ) coincide con il singleton del vuoto, P(Æ) = {Æ}). Infine, che siamo adesso in grado di discutere completamente la possibile inclusione A Í {A}. Da essa si trae infatti: A Î P({A}) = {Æ, {A}}, e quindi abbiamo due casi mutuamente escludentisi: o A = Æ, o A = {A}. La seconda eventualità va certo scartata, perché da essa, e dalla A Î {A}, si dedurrebbe ancora una volta l'assurda

A Î A, mentre la prima eventualità, A = Æ, fornisce l'unico caso in cui risulti di fatto A Í {A}.

(I.3) Piccolo rompicapo. Abbiamo accennato al fatto che è "raro" risulti A Í P(A), una questione che è collegata al caso in cui un elemento a di un insieme A sia anche un sottoinsieme di quell'insieme, cioè si abbia simultaneamente: a Î A e a Í A. Se prendiamo per esempio i seguenti oggetti: i simboli numerici 1, 2 e 3, e l'insieme I = {1, 2}, possiamo senz'altro concepire l'insieme A = {1, 2, 3, I} = {1, 2, 3, {1, 2, 3}} di cui abbiamo già parlato, ed ecco allora che risulta manifestamente sia I Î A, sia I Í A, ovvero I Î A e I Î P(A) (ma non A Í P(A)). Più difficile è capire che esistono insiemi per cui la precedente circostanza sussiste per tutti gli elementi di A (nel caso analizzato essa valeva di fatto solo per l'elemento I, ovvero I era l'unico elemento a comune tra A e P(A)), ovvero tali che A Í P(A). Per avere un siffatto "strano" insieme, basta prendere ad esempio i seguenti oggetti: l'insieme vuoto Æ, e l'insieme K che ha come unico elemento l'insieme vuoto, vale a dire K = {Æ} (singleton del vuoto). Costruito adesso l'insieme con due elementi A = {Æ, K} = {Æ, {Æ}}, ecco che risulta: P(A) = {Æ, {Æ}, {{Æ}}, A}, ed è chiaro che in questo caso vale proprio l'inclusione A Í P(A). Si osservi, per concludere questa nota, che A non può mai essere uguale a P(A) (basta osservare che: A Î P(A), ma A Ï A), e che in quanto precede non avremmo potuto per esempio sostituire all'insieme vuoto il simbolo numerico 1, poiché l'insieme B = {1, {1}} non gode della proprietà richiesta. Infatti, risulta: P(B) = {Æ, {1}, {{1}}, B}, e tutto ciò dimostra quanto il vuoto debba ritenersi un insieme assai speciale. Il problema è che uno stesso insieme vuoto viene inteso come sottoinsieme di qualsiasi insieme (ne consegue che l'intersezione di tutti gli insiemi P(X), ciascuno dei quali è diverso dal vuoto, al variare di X, non è vuota, dovendo contenere l'insieme vuoto!), sicché il vuoto che rappresenta l'insieme dei miliardi nel conto in banca di chi scrive - e assai presumibilmente pure di chi legge - viene inteso come il medesimo vuoto che rappresenta l'insieme delle occorrenze della parola "mxyzptlk" nel prossimo capitolo di questo libro. In effetti, nel caso precedente, a partire dal "simbolo" Æ (passo 1) abbiamo costruito l'insieme A (passo 2), e lo stesso simbolo Æ (passo 3) ha designato il sottoinsieme vuoto di A.

Per affrontare meglio lo studio dei "fenomeni" di nostro interesse, conviene introdurre subito ulteriori simboli, appartenenti a quella che potrebbe dirsi la stenografia della "logica".

Prima di tutto due simboli quantificatori: " che significa "per ogni", ed $ che significa "esiste" (ad esso viene talora aggiunto un punto esclamativo, $!, per esprimere il concetto "esiste ed è unico"). Notiamo che talvolta " può essere letto come un semplice "tutto", o "tutti".

Poi due connettivi logici: Ù che indica la congiunzione "e" (latino et), e Ú che indica la disgiunzione inclusiva "o" (ossia il latino vel, non l'aut che è disgiunzione esclusiva, che si usa quando un'alternativa esclude l'altra).

Un prefisso di negazione, Ø, che collocato davanti a un certo asserto significa che esso è falso.

Esempio: come è possibile esprimere la disgiunzione esclusiva aut con i soli simboli precedenti, ovvero senza introdurne uno nuovo apposito? Dati due asserti p e q, se li si vuole escludere a vicenda, basta scrivere:

p aut q = (pÙØq)Ú(ØpÙq).

Un simbolo di implicazione: Þ . Esso significa che l'asserto che si trova alla sinistra del simbolo implica l'asserto che si trova alla destra del simbolo (c'è chi usa il simbolo ®, che noi preferiamo però riservare al caso delle funzioni, che presto discuteremo). Un modo di intendere l'implicazione p Þ q tra due asserti p e q, è quello di dire che pÙ(Øq) è impossibile.

Qualora due asserti p e q si implichino reciprocamente, si introduce un nuovo simbolo Û, che può essere interpretato come un simbolo di equivalenza logica: anziché scrivere (p Þ q)Ù(q Þ p), si scriverà più brevemente p Û q (quanto detto nella sezione precedente potrebbe allora esprimersi simbolicamente come:

(p Þ q) Û [Ø(pÙ(Øq))]. Notiamo che talvolta Þ può essere letto come un semplice "segue", "allora".

Esercizio: come si nega la congiunzione Ù? Come si nega la congiunzione Ú?

Ø(pÙq) Û [(Øp)Ú(Øq)]

(esempio: (p Þ q) Û [Ø(pÙ(Øq))] Û [(Øp)Ú(Ø(Øq))] Û [(Øp)Úq], poiché Ø(Ø(q)) Û q, due negazioni successive si elidono)

Ø(pÚq) Û [(Øp)Ù(Øq)].

Prima di abbandonare l'ambito puramente logico-descrittivo delle considerazioni precedenti, diamo un cenno a due celebri "modi" di utilizzare un'implicazione, che si dicono rispettivamente del modus ponens e del modus tollens:

(I.4) [(p Þ q)Ùp] Þ q,

(I.5) [(p Þ q)Ù(Øq)] Þ (Øp),

e riportiamo un'altra importante legge dell'inferenza logica generale, molto usata nelle dimostrazioni matematiche, soprattutto quelle "per assurdo". Essa afferma che:

(I.6) (p Þ q) Û (Øq Þ Øp)

In effetti, se ho per esempio (p Þ q), e se avessi anche p, allora per modus ponens sarei sicuro della validità di q, sicché se so pure che q non è vera, ecco allora che non può essere di conseguenza vera p; reciprocamente, se parto da (Øq Þ Øp), allora pÙ(Øq) non può che essere impossibile, perché se avessi un caso in cui p e Øq coesistono, e dal momento che Øq implica p, ecco che avrei anche un caso in cui p e Øp coesistono. La pÙ(Øp) è un'impossibilità logica, mentre la pÚ(Øp) è una tautologia, cioè un'affermazione sempre vera.

(I.7) Nota. L'introduzione dei simboli quantificatori consente di soffermarci un poco sul significato del termine "in generale", che spesso si incontra in matematica. Affermare per esempio che l'inclusione A Í P(A) non sussiste in generale, ovvero che in generale

Ø(A Í P(A)), significa che nella precedente proposizione formalizzata si intende sottintesa una quantificazione della variabile A con il simbolo $, vale a dire che la formalizzazione completa dell'asserzione in oggetto è: [$ A ½ Ø(A Í P(A))]. A parole, si può dire che l'insieme A = {Æ, K} è un esempio di validità della relazione A Í P(A) (o della A Ì P(A)), la quale quindi non è vuota, però non è neppure vera in generale, dal momento che esiste qualche insieme A (A si chiama allora un controesempio alla validità della relazione in causa; nel caso specifico, poi, sono controesempi "quasi tutti" gli insiemi!), per cui si può dire che la relazione in oggetto non sussiste tout court. Possiamo anche provare a rispiegare il tutto attraverso altri concetti, cogliendo l'occasione per effettuare un'analisi più dettagliata di alcuni importanti fenomeni logico-linguistici. Assegnati: (1) un certo insieme A; (2) un certo predicato P(x), [Ora P è iniziale di "predicato", e non di "parte"; purtroppo i simboli dell'alfabeto a nostra disposizione sono pochi, e per questa ragione si utilizzano a volte anche altri alfabeti, senza comunque riuscire a ovviare completamente alla penuria di simboli di fronte alla molteplicità di concetti] che può essere semplicemente inteso come un'asserzione "sensata" per gli elementi di A, la quale per " singolo x Î A possa dirsi inequivocabilmente o vera o falsa (qui la particella "o" funge da aut); allora noi possiamo concepire il sottoinsieme A' Í A costituito da quegli elementi x Î A tali che per essi il predicato P sia vero. In simboli, A' = {x Î A ½ P(x)}. Orbene, l'asserzione di cui trattasi si dirà vera, sottinteso senza eccezioni, in A, se A' = A, cioè se: " x Î A Þ P(x). Si dirà falsa, o non vera in generale, se A' ¹ A, ovvero se:

Ø[" x Î A Þ P(x)], il che equivale a dire: [$ x Î A Þ ØP(x)]. Ma si noti bene che la proposizione p = "P(x) non è vera in A", o anche "P(x) è falsa in A", non va confusa con la proposizione "(ØP(x)) è vera in A", la quale significa invece che [" x Î A Þ ØP(x)] (in p compare un quantificatore $ al posto del precedente quantificatore "). L'identità logica tra le due proposizioni sussisterebbe soltanto nel caso in cui A', oltre ad essere diverso da A, fosse addirittura vuoto, sicché si può concludere che "in generale" abbiamo tre possibilità: A' = A (P(x) è vera in A); A' ¹ A e A' ¹ Æ (P(x) non è vera in A, o è falsa in A, e in A ci sono sia esempi che controesempi del predicato P(x)); A' = Æ ((ØP(x)) è vera in A, ovvero P(x) è vuota in A). Perché abbiamo usato ancora una volta la specificazione "in generale"? Ma perché quanto precede vale a rigore solo se A ha almeno due elementi: infatti, nel caso di un singleton, le tre possibilità si riducono a due (e cosa può dirsi nel caso che A sia l'insieme vuoto? Vero e falso qui diventano la stessa cosa!). Allo studente non mancheranno "infiniti" casi nei quali mettere in pratica la semplice analisi logica che precede (un predicato può essere un'asserzione sull'età dei suoi conoscenti, sul luogo di provenienza dei suoi compagni di studio, etc.). Aggiungiamo piuttosto una riflessione sulla circostanza che, quando nel "linguaggio comune" si dice che una certa proprietà è valida o non è valida in generale, si intende anche specificare che è "raro", infrequente, il caso in cui così non sia, ma questa è una modalità dell'espressione assai più difficile da precisare in un senso matematico esatto. Accenniamo soltanto al fatto che in geometria la precisazione avverrebbe mediante il concetto di dimensione, e che in teoria degli insiemi si potrebbe usare il confronto tra numeri cardinali, che illustreremo nel III capitolo. In generale (un'altra volta, appunto!), è necessario avere una sorta di "misura" dell'insieme dei casi "eccezionali" rispetto a quelli "generali", ma se le eccezioni sono relativamente poche, e sono quindi elencabili, è preferibile per esempio affermare che un certo asserto è vero o non è vero tranne alcuni casi che vengono esplicitamente determinati. Per esempio, abbiamo visto che l'inclusione A Í {A} non è mai vera, per nessun insieme A, tranne nel caso in cui A sia l'insieme vuoto, un'enunciazione questa che è più esauriente della semplice: "A Í {A} non è vera in generale", la quale deve ritenersi comunque corretta.

Si osservi che in quanto precede abbiamo fatto largo uso di parentesi (se si vuole di vario tipo, secondo le convenzioni certamente a tutti note; è però preferibile evitare l'uso delle parentesi graffe, che è meglio riservare, come abbiamo visto, alle "definizioni" degli insiemi). Queste, assieme a possibilmente diversi segni di interpunzione, vengono introdotte per maggiore chiarezza, in un modo che può essere più o meno pedante, a piacere; l'importante è che anche un'esposizione "trasandata" sia capace di tramutarsi, se del caso a richiesta, in una "perfetta".

(I-8) Nota. Andrebbe forse sottolineato il fatto che stiamo considerando anche l'implicazione come un concetto sostanzialmente primitivo, nel senso che riconosciamo al nostro intelletto la facoltà incondizionata di accettare o meno la validità di un'implicazione; ovvero, che lo lasciamo libero di decidere quando un'implicazione tra due termini di un discorso possa essere concepita sussistere in modo chiaro e distinto. Per esempio, può ritenersi abbastanza comprensibile-accettabile la convenzione secondo la quale un'implicazione si considera comunque corretta se la "premessa" è vuota o falsa, qualsiasi sia la "tesi", vuota, vera o falsa. In ogni caso, ribadiamo il suggerimento, tutto va preso cum grano salis, cioè fino a nostra completa e onesta soddisfazione (che è l'unica degna mèta a cui lo spirito di uno studioso deve aspirare).

Diamo qualche esempio di applicazione di tale strumentario in casi semplicissimi.

Esprimiamo l'inclusione tra due insiemi, A Í B:

A Í B Û (" x Î A) Þ (x Î B),

mentre l'identità tra due insiemi, A = B, si esprime ovviamente come:

A = B Û (A Í B)Ù(A Ê B) Û [(" x Î A) Þ (x Î B)]Ù[(" x Î B) Þ (x Î A)].

Esercizio: come si esprime invece l'enunciato che due insiemi A e B sono diversi tra loro, ovvero che: A ¹ B? Bisognerà negare l'ultima delle stringhe precedenti (il termine sta per una sequenza di "segni" di un dato "alfabeto", e avremo occasione di precisarlo e utilizzarlo meglio nel seguito), ovvero scrivere, "semplificandola" un poco:

Ø[[(" x Î A) Þ (x Î B)]Ù[(" x Î B) Þ (x Î A)]].

In base alle regole che già conosciamo, risulterà:

Ø[[(" x Î A) Þ (x Î B)]Ù[(" x Î B) Þ (x Î A)]] Û

Û[Ø[(" x Î A) Þ (x Î B)]]Ú[Ø[(" x Î B) Þ (x Î A)]] Û

Û [($ x Î A) ½ Ø(x Î B)]Ú[($ x Î B) ½ Ø(x Î A)].

Così come l'uguaglianza tra A e B, la disuguaglianza tra A e B si esprime attraverso la congiunzione di due enunciati, diciamoli p e q, nell'ordine, ciascuno dei quali preso separatamente implica detta disuguaglianza, ma non equivale ad essa: (A ¹ B) Û pÚq ; p Þ A ¹ B (ma non: p Û (A ¹ B));

q Þ A ¹ B (ma non: q Û (A ¹ B)); (A = B) Þ Øp; (A = B) Þ Øq. Si può cogliere l'occasione per segnalare in modo esplicito l'ovvia validità generale (ovverosia, per ogni coppia di proposizioni p, q) delle: p Þ pÚq, q Þ pÚq (invero, i due asserti sono la stessa cosa, poiché: pÚq Û qÚp, allo stesso modo:

pÙq Û qÙp; Ø(pÚq) Þ Øp; (Øp)Ù(Øq) Þ Øp; la quale ultima corrisponde manifestamente alla: pÙq Þ p, etc.).

Lo studente si eserciti anche a leggere, o se si preferisce "tradurre", le seguenti asserzioni "compatte":

* (" oggetto x) Þ (x ÏÆ) ; o anche (" oggetto x) Þ Ø(x Î Æ) ;

** (" insieme A) Þ (Æ Î P(A)) ; (" insieme A) Þ (A Î P(A)) ;

*** (" insieme A) Þ (P(A) ¹ Æ) ;

**** (" insieme A) Þ [(P(A) è un singleton) Û (A = Æ)] ;

***** (" coppia di insiemi A, B) Þ [(A Í B) Û (P(A) Í P(B))] ;

****** (" terna di insiemi A, B, C) Þ [(A Í B)Ù(B Í C) Þ (A Í C)]

etc. etc., di simili asserzioni "luminosamente evidenti" ce n'è a iosa.

Quanto precede risulta estremamente comodo per definire e descrivere in modo sintetico le OPERAZIONI naturali tra insiemi.

Unione, per la quale si usa il simbolo È (corrispondente a Ú):

AÈB = {" x ½ (xÎA)Ú(xÎB)}

Intersezione, per la quale si usa il simbolo Ç (corrispondente a Ù):

AÇB = {" x ½ (xÎA)Ù(xÎB)}

Complementazione (corrispondente a Ø):

per ciascun elemento X Î P(A), ovvero per ciascun sottoinsieme X Í P(A), con il simbolo CA(X) si indica il sottoinsieme di A complementare di X (esso si dice il complementare di X in A, la specificazione "in A" venendo di solito omessa quando sia chiaro il riferimento all'ambiente), vale a dire l'insieme di tutti gli elementi a Î A tali che a Ï X. In simboli:

CA(X) = {" a Î A ½ Ø(aÎX)}.

Ovviamente, risulta sempre: A = XÈCA(X), e XÇCA(X) = Æ, la seconda relazione esprimendosi a parole con il dire che X e CA(X) sono disgiunti.

Differenza, per la quale si usa il simbolo "-", ma c'è pure chi usa il simbolo "\":

A-B (oppure A\B) = CA(AÇB) = {" a Î A ½ Ø(a Î B)}

Si noti che, per esempio: " coppia d'insiemi A, B, (A-B = Æ) Û (A Í B), e che: AÈB = (A-B)È (B-A)È(AÇB), i tre insiemi che compaiono nel RHS della precedente identità risultando a due a due disgiunti (abbiamo introdotto un'abbreviazione assai comoda, che sta per right hand side = parte destra; analogo è il significato di LHS, left hand side).

Nei primi due casi, e nel quarto, si tratta di operazioni binarie, che richiedono cioè un doppio input, che va considerato a priori sempre ordinato nel tempo, ossia un primo input a cui segue un secondo input; nel terzo caso, invece, si tratta di un'operazione che potrebbe dirsi unaria (anche se è una parola poco "elegante").

Discutiamo adesso alcune proprietà delle precedenti operazioni.

La commutatività esprime la circostanza che il risultato dell'operazione è indipendente dall'ordine in cui vengono assegnati gli input. Questo è per esempio il caso dell'unione e dell'intersezione:

(I.9) AÈB = BÈA ; AÇB = BÇA

(dove è sottintesa la quantificazione: " coppia di insiemi A e B),

ma non è il caso della differenza, dal momento che, in generale, risulta:

(I.10) A-B ¹ B-A .

(Perché solo "in generale"? Quali sono le possibili eccezioni? Vedi l'esercizio discusso tra breve).

Altre proprietà dell'unione e dell'intersezione, che scriviamo ancora in coppia (a sottolineare l'evidente dualismo che esiste tra le due operazioni).

Associatività:

(I.11) AÈ(BÈC) = (AÈB)ÈC ; AÇ(BÇC) = (AÇB)ÇC

(dove è sottintesa la quantificazione: " terna di insiemi A, B, C).

[Si constati che, al contrario, l'operazione di differenza non è associativa, ossia che non risulta, ovviamente in generale: A-(B-C) = (A-B)-C, del che ci si persuade facilmente attraverso esempi.]

Idempotenza:

(I.12) AÈA = A ; AÇA = A

(dove è sottintesa la quantificazione: " insieme A).

Distributività (dell'unione rispetto all'intersezione, e dell'intersezione rispetto all'unione):

(I.13) AÈ(BÇC) = (AÈB)Ç(AÈC) ;

AÇ(BÈC) = (AÇB)È(AÇC) .

(dove è sottintesa la quantificazione: " terna di insiemi A, B, C).

Dalla distributività, e dalle ovvie:

(I.14) A Í B Û AÈB = B Û AÇB = A,

si deducono infine le seguenti leggi di assorbimento:

(I.15) AÈ(AÇB) = A ; AÇ(AÈB) = A .

Quel dualismo tra unione e intersezione al quale si è fatto cenno, si precisa anche attraverso le seguenti proprietà della complementazione (corrispondenti evidentemente a proprietà logiche generali - negazione dell'et e del vel):

(I.16') " insieme A, e " X, Y Î P(A) Þ CA(XÈY) = CA(X)ÇCA(Y),

e "dualmente":

(I.16'') " insieme A, e " X, Y Î P(A) Þ CA(XÇY) = CA(X)ÈCA(Y) .

Le (I.16) esprimono formalmente l'ovvia circostanza di natura logica, già notata, secondo cui la negazione del quantificatore " è il quantificatore $, e inversamente che la negazione del quantificatore $ è il quantificatore ". Si può cogliere l'occasione per osservare che i sei simboli logici "essenziali" (diversi cioè da parentesi, barre, etc., che sono abbreviazioni del linguaggio ancora più semplici), vale a dire: " , $ , Ú , Ù , Ø , Þ , risultano in effetti sovrabbondanti. Oltre a quanto appena osservato, si rammenti che pure et e vel risultano tra loro collegate tramite il simbolo di negazione, e che l'implicazione p Þ q equivale logicamente alla Ø[(pÙ(Øq)], oppure, usando il vel anziché l'et: (Øp)Úq. Basterebbero quindi solo tre "segni" dei sei, per esempio " , Ú , Ø , ma si tratta di una "economia di pensiero" che ci sembra inopportuna sotto vari punti di vista: poiché l'uomo non è una macchina (per esempio, il suo intelletto "soffre" enunciazioni - e "dimostrazioni", o "comunicazioni" in genere! - troppo lunghe; il tempo di una vita è del resto un "tempo finito"), ecco che un eccesso di "riduzionismo" è quasi sempre controproducente ai fini della "chiarezza" della comprensione.

Notiamo inoltre che, mentre unione e intersezione sono operazioni che godono della proprietà che abbiamo chiamato idempotenza, la complementazione gode di quella che si chiama involutorietà. Ovvero, si tratta di un'operazione unaria che, come la negazione, ripetuta due volte su uno stesso elemento, fa tornare al punto di partenza:

(I.17) " X Î P(A) Þ CA(CA(X)) = X .

La ricerca delle naturali proprietà della differenza può essere ormai lasciata per esercizio al lettore, e comunque il nostro scopo non è di elencare subito tutte le proprietà che potrebbero tornarci utili nel seguito, riservandoci di tornare sopra uno stesso argomento quando necessario. [Pierre de la Ramée (1515-1572), noto anche con il nome latino Petrus Ramus, <<ben prima di Descartes proclamò l'impero della ragione sul principio d'autorità; in conseguenza insorse contro il feticismo per Aristotele e poi contro la cieca adorazione per Euclide. [...] Per esempio nella più celebre delle sue opere scientifiche - le Scholae mathematicae - egli osservò quanto fosse didatticamente opportuno il distribuire gli assiomi e i postulati nel corso dell'opera, invece di accatastarli nell'esordio come fece Euclide>> - da: Gino Loria, Storia delle matematiche - Dall'alba della civiltà al tramonto del secolo XIX, 3 voll., Torino, 1929-33, riediti in un unico volume da Cisaplino-Goliardica, 1982.]

Analogamente, sempre come esercizio può chiedersi di trovare la risposta alla seguente semplice domanda: quand'è che risulta A-B = B-A?

Risposta (da guardare solo dopo che ci si è un po' sforzati di provare da soli):

[(A-B) = (B-A)]Ù[(A-B)Ç(B-A) = Æ] Þ [(A-B)Ç(B-A) = (A-B) = (B-A) = Æ (per idempotenza)] Þ [(A Í B)Ù(B Í A)] Þ A = B.

Sono state così mostrate diverse applicazioni della teoria degli insiemi interne alla nostra materia, ma in conformità alle premesse "filosofiche" che abbiamo enunciato, gli infiniti esempi di sua presenza, e delle leggi della logica generale, dovrebbero in effetti essere tratti da un ambito appunto generale, e non da quello specifico della matematica, come è viceversa usuale nei testi scritti dai cultori di tale disciplina. Diamo allora un esempio di analisi testuale evangelica, mettendo due celebri affermazioni a confronto.

Nel vangelo di Luca 9,50 (il primo numero si riferisce al capitolo, il secondo al verso), troviamo scritto: <<qui enim non est adversum vos, pro vobis est>>, ovvero <<chi non è contro di voi è con voi>>. Tale affermazione si trova tale e quale in Marco 9,40, mentre ancora Luca, in un altro passo (11, 23), si esprime in modo "diverso": <<qui non est mecum contra me est>> (<<chi non è con me è contro di me >>). Tale brano è riportato tale e quale in Matteo 12, 30. Si tratta di affermazioni certamente diverse dal punto di vista letterale-testuale, ma dal punto di vista del loro significato? La psicologia ordinaria avverte in effetti una differenza: la prima appare benevola, "aperta", la seconda restrittiva, "chiusa" (in effetti da essa prende fondamento l'opinione: extra Ecclesiam nulla salus, non c'è salvezza per coloro che non fanno parte della Chiesa, salvo poi a stabilire quale sia la Chiesa "giusta").

Ma cerchiamo di vedere se le cose stanno proprio così, ovvero se le due affermazioni sono logicamente differenti. Entrambe si riferiscono ovviamente all'insieme dei cristiani, di coloro che hanno "fede" nel Cristo, diciamolo F, un insieme che deve essere concepito come un sottoinsieme dell'insieme U di tutti gli esseri umani (un insieme piuttosto "astratto"), ovvero: F Í U. Ad esso viene affiancato l'insieme di coloro che ai cristiani (o al Cristo) sono <<contrari>>, <<avversi>> (con il senno di poi, per esempio, coloro che perseguitarono i cristiani), diciamolo A (per non confondere con l'iniziale C di "complementare", un simbolo che dovremo presto introdurre in questa discussione). Ciò premesso, la prima affermazione si può formalizzare nel modo seguente:

" x Î U, x Ï A Þ x Î F,

la seconda:

" x Î U, x Ï F Þ x Î A.

Sono le due affermazioni semanticamente diverse? In virtù delle leggi della logica generale esse sono semplicemente la medesima affermazione. Infatti, scrivendo Ø(x Î A) in luogo di x Ï A, e lo stesso per x Ï F, le due affermazioni precedenti si scrivono rispettivamente come: Ø(x Î A) Þ x Î F e Ø(x Î F) Þ x Î A, sicché, in virtù della (I.4):

[Ø(x Î A) Þ x Î F] Û [Ø(x Î F) Þ Ø(Ø(x Î A))],

d'onde la conclusione (si rammenti l'involutorietà della negazione).

Può essere un utile esercizio, a un livello iniziale in cui lo studente deve prendere ancora confidenza con un linguaggio e un simbolismo che possono a prima vista apparire ostici, dimostrare che quanto appena asserito si può anche esprimere attraverso alcune semplici "equazioni" di teoria degli insiemi.

[" x Î U, x Ï A Þ x Î F] Û [CU(A) Í F],

anzi, poiché è sottinteso a priori che sia F Ç A = Æ (il che equivale a dire che sussistono le seguenti due inclusioni: [F Í CU(A)] Ù [A Í CU(F)]), ecco che abbiamo anche addirittura:

[" x Î U, x Ï A Þ x Î F ] Û [CU(A) = F].

Del tutto analogamente:

[" x Î U, x Ï F Þ x Î A] Û [CU(F) Í A],

la quale, unita all'inclusione A Í CU(F), che si è detto essere sempre valida a priori, fornisce infine:

[" x Î U, x Ï F Þ x Î A] Û [CU(F) = A].

Come esercizio, si utilizzi per esempio l'involutorietà (I.17) per dimostrare che i due asserti CU(A) = F, CU(F) = A sono identici come asserito:

CU(A) = F Þ CU(CU(A)) = CU(F) Þ A = CU(F) ;

CU(F) = A Þ CU(CU(F)) = CU(A) Þ F = CU(A)) .

Perché allora quell'indubitabile effetto psicologico, che induce a ritenere "differenti" le due dichiarazioni? A parte il fatto che sostenere in una "tesi" che qualcuno sia <<contro>> qualcosa suona "aggressivo" a orecchie le quali non gradiscono che si sottolinei l'esistenza di "conflitti" (un effetto che la "stessa" proposizione non provocherebbe qualora la tesi venisse espressa in una forma conciliante, come è senz'altro quella confortante che ci informa che qualcuno almeno <<è con noi>>; un modo diverso di esprimere il medesimo concetto, che è sovente possibile raggiungere giocando sulla (I.4)), riteniamo che si tratti qui piuttosto dell'aspettativa dell'ascoltatore. In effetti, ciò che taluni si attendono dalle parole in esame è che attraverso di esse venga stabilita una precisa bipartizione (che la mentalità "pratica" considera ovviamente essenziale) nell'insieme U degli esseri umani: "salvi" (il cui insieme indicheremo con S, S Í U) e "dannati" (un insieme D Í U); ovvero, agnelli e capri, coloro che il giorno del giudizio saranno alla destra del Padre o alla sua sinistra. Le due affermazioni che stiamo analizzando sono invero perfettamente coerenti con questo punto di vista dicotomico (che divide in due), dal momento che, così come U risulta adesso l'unione di due sottoinsiemi disgiunti,

U = SÈD, lo stesso insieme U veniva dianzi decomposto nell'unione di altri due (a priori diversi) sottoinsiemi pure disgiunti, U = FÈA, con la naturale suggestione che si trattasse della medesima bipartizione, ovvero che: F = S,

A = D. E' noto però che l'umana pietà ama poco codeste rigorose dicotomie, tanto è vero che, per esempio, ha introdotto apposta concetti quali il Purgatorio, (per attenuare la contrapposizione Paradiso-Inferno che incute timore; qualche teologo si è spinto addirittura a ipotizzare che l'infinita bontà del Dio che lui concepisce sarà poi di fatto tale da rendere l'insieme D vuoto, un insieme che sarebbe quindi da ritenersi vuoto come l'Inferno), o il Limbo (si rammentino le discussioni relative alla sorte delle persone "buone" che avevano l'unico torto di essere vissute prima dell'"incarnazione"). La persona pietosa sostituisce allora alla bipartizione {F, A} una tripartizione, introducendo (senza bisogno di chiedere lumi a nessuno, fosse anche il figlio di Dio), che l'insieme degli esseri umani va logicamente tripartito tramite l'insieme F degli "eletti", quello A di coloro che sono stati proprio e irrimediabilmente cattivi nei loro confronti (caso paradigmatico: Nerone, un personaggio forse un po' calunniato dalla storia), e un terzo insieme I (la lettera I sta per l'iniziale di "indifferenti"), nel quale vanno inclusi coloro che sospendono il giudizio sulla delicata questione, oppure hanno un giudizio negativo nei confronti di chiacchiere "celesti", ma non lo mettono in pratica con cattive azioni nei confronti dei "teomani". La presenza di queste due partizioni può indurre in effetti in qualche fraintendimento, perché quando si mette a confronto la tripartizione {F, A, I} (invero del tutto "logica") con la bipartizione fondamentale {S, D}, ecco che la prima affermazione, quella "bonaria", viene interpretata come:

" x Î U, x Ï A Þ x Î S, e quindi I Í S (in questo caso il figlio di Dio conforterebbe gli interlocutori pietosi, o quelli più tiepidi, scettici, con una prospettiva rassicurante),

mentre la seconda come:

" x Î U, x Ï F Þ x Î D, e quindi I Í D (in questo caso il figlio di Dio si comporterebbe invece come un giudice inflessibile, spedendo gli ignavi ad arrostire per l'eternità insieme a Nerone).

In un caso, quei soggetti che si trovano in I vengono salvati, nell'altro vengono dannati, ed è chiaro che almeno per loro (e per i loro amici) la differenza tra le due dichiarazioni (o minacce) sarebbe assai significativa. Ci sembra che solo in questo modo si possa spiegare perché taluni percepiscano segni di "schizofrenia", in verità del tutto inesistente, in due affermazioni che sono invece perfettamente equivalenti. Ripetiamo che la contraddizione sarebbe stata invece presente qualora una volta si fosse sostenuta l'inclusione I Í S, un'altra l'inclusione I Í D, a meno che naturalmente I non sia da ritenersi vuoto (ipotesi che è del resto corrispondente al testo evangelico), ma, a parte il fatto che una siffatta ipotesi appare inverosimile (ovviamente, secondo una mentalità che non accetta la proposta dicotomia), non si vedrebbe allora la convenienza di introdurre un terzo insieme, destinato a rimanere puramente "potenziale". La "confusione" non è quindi nelle parole della "buona novella", ma soltanto nella mente di chi cade in equivoco sovrapponendo il proprio pensiero a quello dell'interlocutore, e crede di avere fatto opera di sintesi coerente senza aver abbastanza curato la formalizzazione dei concetti, o degli enunciati su cui opera. Si tratta di quelle <<persone che, in tutta la loro vita, non percepiscono nulla come è necessario per bene giudicarne>>, e che talvolta si poggiano in malafede su simili fraintendimenti per interpretare un testo (questo o altri) come loro meglio aggrada.

Quello che abbiamo voluto a lungo analizzare è un esempio che, a prescindere dall'eventuale interesse specifico, ci suggerisce comunque di introdurre in modo "rigoroso" alcuni importanti concetti, con i quali chiudiamo questa prima parte del capitolo I. Dato un qualsiasi insieme non vuoto A, un sottoinsieme (che risulterà certamente non vuoto) P Ì P(A) si dice una partizione di A (attenzione alle due diverse iniziali che qui sono in conflitto, sebbene in maniera sopportabile: P come partizione, P come parte) quando gli elementi di P siano:

(i) tutti diversi dall'insieme vuoto;

(ii) a due a due disgiunti;

(iii) la loro unione sia l'intero A.

Si osservi che unione e intersezione si possono ovviamente estendere, dal caso di due input, a quello di una totalità qualsiasi di insiemi, e che avevamo in effetti già utilizzato tale possibilità nel parlare dell'intersezione di tutti gli insiemi delle parti P(X), al variare di X. Nel presente contesto, si tratta comunque di utilizzare la nozione per sottoinsiemi di un dato insieme A, ossia per elementi di un fissato P(A).

[Quanto precede si presta a qualche puntualizzazione. Comunque dato un certo sottoinsieme S di un fissato insieme delle parti P(A) di un fissato insieme A, possiamo introdurre i seguenti due sottoinsiemi di A:

ÈA(S) = {" x Î A ½ ($ C Î S : x Î C)}

ÇA(S) = {" x Î A ½ (" C Î S Þ x Î C)},

che si dicono rispettivamente l'unione, o l'intersezione, degli elementi di S (l'indice A è opportuno per ricordare che il risultato dell'operazione è un sottoinsieme di A; si noti bene che invece S è un sottoinsieme di P(A)). In virtù di tale definizione, risultano per esempio tutte chiaramente valide le seguenti asserzioni: ÈA(P(A)) = A; ÇA(P(A)) = Æ;

" X Í A Þ ÈA({X}) = X (si presti bene attenzione al fatto che: " X Í A Þ {X} Í P(A));

" X Í A Þ ÇA({X}) = X ; " S Î P(A) Þ CA(ÈA(S) = ÈA(CA(S));

" S Í P(A) Þ CA(ÇA(S) = ÈA(CA(S));

nell'ultima delle quali CA(S) designa l'insieme dei complementari in A degli elementi di S, e quindi costituisce ancora un sottoinsieme di P(A), che non ha nulla a che fare però con CP(A)(S). Abbiamo detto che tutto quanto precede è logicamente assai chiaro, ma qualche meditazione a parte la merita il solito caso del "vuoto"! Qui esso appare ben due volte, la prima come semplice sottoinsieme di P(A), sicché hanno senso entrambe le espressioni: ÈA(Æ) e ÇA(Æ), le quali valgono rispettivamente Æ e A. Mentre la prima appare piuttosto comprensibile, in virtù della definizione stessa di ÈA, una lunga esperienza didattica ci informa che di solito non è questo il caso della seconda (anche se pur essa si può comprendere "logicamente"). Chi ne ha bisogno, potrà forse convincersi meglio della validità della: ÇA(Æ) = A, attraverso la catena di identità: CA(ÇA(Æ)) = ÈA(CA(Æ)) = ÈA(Æ) = Æ (per comprendere chi è CA(S), bisogna pensare a tutti gli elementi di S, e farne i complementari in A; se S = Æ, ecco che pure CA(S) = Æ). Il secondo caso in cui compare l'insieme vuoto è sotto forma del singleton {Æ}, in quanto non solo Æ Í P(A) (eventualità che abbiamo già esaminato), ma anche Æ Î P(A). Si hanno adesso le seguenti identità: ÈA({Æ}) = Æ ; ÇA({Æ}) = Æ ; perfettamente coerenti con le identità generali che avevamo già stabilito poc'anzi nel caso di un sottoinsieme di P(A) che fosse un singleton.]

Se ci si limita soltanto all'ultima condizione enunciata, lasciando cadere le prime due, si dice che l'insieme P è un ricoprimento di A, nel qual caso A, o un elemento di P, possono anche essere il vuoto. Si noti allora che la specificazione restrittiva iniziale P Ì P(A) è senz'altro corretta nel caso di una partizione (P non può coincidere con l'intero P(A), perché c'è almeno l'insieme vuoto che è contenuto in P(A) ma non in P), mentre che la precedente inclusione sia propria non è richiesto (così come non è richiesto che sia A ¹ Æ) nel caso di un ricoprimento; anzi, P(A) stesso è manifestamente un ricoprimento, ancorché "banale", di A.

P si chiama anche un insieme quoziente di A (si veda il commento a tale denominazione che viene effettuato nella nota precedente la (III.55)). Osserviamo esplicitamente che esso appare sempre più piccolo di A (un concetto importante che naturalmente preciseremo nel seguito), a volte molto più piccolo di A, per esempio quando A è infinito e P è finito (per esempio, la classica bipartizione tra numeri naturali pari e dispari; oppure, la tripartizione che resta indotta in un piano da una retta in esso contenuta; l'insieme quoziente è formato nel primo caso da due soli elementi, nel secondo da tre, che sono due semipiani "aperti" con una comune "frontiera", più la retta di cui trattasi). Tra gli insiemi quoziente di A ce ne sono due "universali", e in qualche modo entrambi banali: P = {A}, che è uno di quegli insiemi che abbiamo chiamato singleton, e P = {{a}, per " a Î A}, cioè la totalità dei singleton che sono in P(A). Nel secondo caso, nel contesto di possibili raffronti tra A e P, P coincide "sostanzialmente" con A, un modo di dire su cui torneremo meglio nella seconda parte del presente capitolo (nella quale approfondiremo pure adeguatamente l'importantissimo concetto di partizione, ossia di insieme quoziente).

Si noti adesso che:

(I.18) Una partizione P' non può mai essere contenuta propriamente in un'altra partizione P, per esempio P' Ì P.

Dim. Supponiamo che C sia un elemento di P non contenuto in P'. Poiché C non è vuoto, esistono almeno un elemento x Î A tale che x Î C, e un elemento

C' Î P' tale che x Î C' (poiché P' "ricopre" A). Ecco allora che CÇC' ¹ Æ, e quindi C' = C (poiché gli elementi di P sono a due a due disgiunti, e C' Î P per ipotesi), il che è assurdo perché si è supposto che C Ï P'. ä (simbolo che useremo come "fine dimostrazione").

Nonostante (I.18), esiste un modo naturale di mettere tra loro a confronto delle partizioni. Una partizione P' si dice meno fine (propriamente oppure no) di P, e si può usare il simbolo P' Ð P (P' ÐÐ P se P' è propriamente meno fine di P), quando: " C Î P Þ $ C' Î P' ½ C Í C'. Corrispondentemente, P si dice più fine di P', e la stessa terminologia si introduce nel caso dei ricoprimenti. Il singleton {A} rappresenta naturalmente la partizione meno fine di tutte (minima), mentre P = {{a}, per " a Î A} rappresenta quella più fine di tutte (massima).

Ciò premesso, è "evidente" che (si ritorni alla Dim. (I.18)):

(I.19) Fissate le precedenti notazioni, esiste un unico C' Ê C per ogni dato C, e P' può quindi essere ottenuta da P sostituendo ad alcuni "blocchi" di P la loro unione.

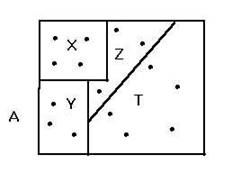

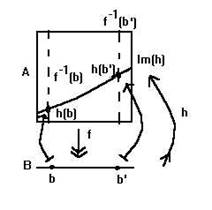

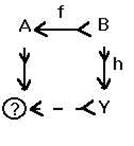

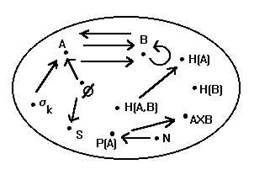

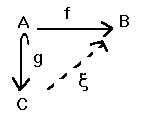

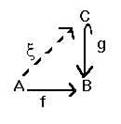

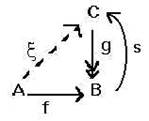

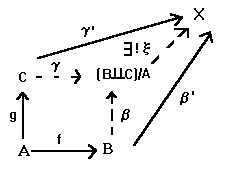

(Fig. I.20)

Nella figura compare una 4-partizione P di un insieme A con 15 elementi,

P = {X, Y, Z, T} (i sottoinsiemi X etc. sono stati disegnati volutamente "diversi" per non favorire la concezione errata che i blocchi di una partizione debbano essere sempre costituiti da uno stesso numero di elementi; qualche volta potrebbero esserlo, qualche volta no, e tanto nel caso finito quanto nel caso infinito, quando si saprà come "calcolare" il numero degli elementi di un insieme infinito), la quale dà origine per esempio a una 3-partizione P' strettamente meno fine di P: P' = {X, Y, ZÈT}, oppure alla 2-partizione

P'' = {XÈY, ZÈT}, anch'essa strettamente meno fine di P. Anzi, risulta:

P'' ÐÐ P' ÐÐ P. E' chiaro inoltre che, data una partizione P' meno fine di una data partizione P di un insieme A, P' induce una corrispondente partizione di P, definita come quella partizione P'* di P i cui elementi siano gli insiemi di quei blocchi di P che vanno a costituire un unico blocco di P'. Un esempio adeguato vale più di mille parole: fermo restando il significato dei simboli precedenti, è chiaro che: P'* = {{X}, {Y}, {Z, T}}, mentre P''* = {{X, Y}, {Z, T}}.

Diamo un esempio di tutto ciò riferendoci ancora alla discussione evangelica di poc'anzi. Abbiamo detto che il dilemma poteva riassumersi nel fatto che una bipartizione di U, P' = {S, D}, veniva messa a confronto, secondo un'opinione comune poco attenta alle parole del Cristo, con una tripartizione P = {F, A, I} dello stesso insieme U. Nel caso benevolo si aveva S = FÈI, D = A, e quindi P' poteva dirsi una partizione meno fine di P, ottenuta mediante la seguente partizione di P: P'* = {{F, I}, {A}}. Nel caso più severo (cioè: S = F, D = AÈI), P' costituiva ancora una partizione meno fine di P, ottenuta però mediante la seguente partizione di P: P'** = {{F}, {I,A}}, ed era quindi una bipartizione diversa dalla precedente P'. Tutto questo ci sembra confermare l'opinione che, sebbene si tratti di concetti "elementari", ad essi occorre prestare la necessaria attenzione, allo scopo di non fare confusione.

Qualche parola conclusiva può essere spesa sin da ora per sottolineare come le partizioni siano ovviamente da riferirsi all'operazione logica di classificare, un'esigenza naturale di ogni teoria della conoscenza, ideale o empirica. Classificare significa in qualche senso "fare ordine" all'interno di un insieme possibilmente eterogeneo, rilevando l'esistenza di particolari omogeneità tra i suoi elementi. Oggetti diversi possono essere distinti per differenze, oppure uniti per somiglianze. Tanto per dire, nell'esempio "teologico" di prima, l'individualità di un singolo essere umano diveniva secondaria rispetto alla sua appartenenza all'insieme S o all'insieme D. Si può aggiungere che il classificare non è l'unico metodo seguito per mettere in pratica il proposito di fare ordine, e cioè che esso può essere ottenuto anche mediante filtrazioni. Per il momento basterà illustrare cosa si può intendere per filtrazione finita (e propria) di un insieme non vuoto A. Si tratta di un sottoinsieme finito e non vuoto F di P(A) (un'iniziale F che adesso sta per "filtrazione", e non per "fede"!), costituito quindi da certi k elementi (k = 1, o k = 2, etc.), diciamoli F1, F2,..., Fk, che si possano "ordinare" in maniera tale che risulti:

A = F1 É F2 É ... É Fk .

Ad una siffatta filtrazione si può peraltro sempre associare una partizione, e precisamente: {F1-F2, F2-F3,..., Fk-1-Fk, Fk}, se Fk ¹ Æ, altrimenti basta finire un passo prima: {F1-F2, F2-F3,..., Fk-1-Fk (= Fk-1)} (poiché tra la seconda partizione e la prima non c'è sostanziale differenza, possiamo aggiungere senza perdere di generalità l'ipotesi che ogni elemento della filtrazione sia diverso dal vuoto, come si è già richiesto per i blocchi di una partizione).

Lo studente non dovrebbe faticare a comprendere meglio tali concetti, individuando gli esempi a lui noti di filtrazione, e immaginando la possibilità di ricorrere simultaneamente, sempre allo scopo di "fare ordine" in un dato insieme (in una data "fenomenologia"), sia a filtrazioni che a partizioni. Tutte questioni che potranno essere sempre meglio analizzate, quando cresceranno le possibilità offerte dal "linguaggio" che stiamo gradatamente presentando-costruendo. [Perché la teoria degli insiemi, o meglio la teoria degli insiemi e delle funzioni, non è altro che un modo conveniente per "parlare" di certe cose in modo "rigoroso". La difficoltà didattica di un corso preliminare come questo è di riuscire a mantenere un certo equilibrio tra la tentazione di portare avanti lo studio del linguaggio senza corrispondente opportuna fenomenologia, che del linguaggio mostri adeguatezza e utilità, e la difficoltà di discutere la fenomenologia senza ancora possedere uno strumento efficace allo scopo.]

(I.21) Nota. Questo è un corso nel quale si discuterà molto di strutture, sicché il consueto capitolo iniziale dedicato alla "teoria degli insiemi" viene detto riferirsi ai semplici insiemi "privi di struttura", anche se in alcuni di essi, data l'essenza specifica (ontologica) dei loro elementi, è impossibile non riconoscere l'emergenza di alcune strutture "spontanee" (per esempio in N); in casi assai più frequenti, delle strutture assai rudimentali, che cominciano ad apparire collegate agli elementi dell'insieme in maniera che diremo naturale. Si tratta di un fenomeno secondo noi filosoficamente rilevante, al quale ci piace qui cominciare ad accennare, notando per esempio la differenza tra quegli insiemi che ammettono una bipartizione naturale (che potrebbero chiamarsi decomponibili), e quelli che al contrario non l'ammettono (indecomponibili). Poiché ogni insieme A che non sia un singleton ammette senz'altro una bipartizione (ovviamente: A ¹Æ), ecco che tutto il significato di una siffatta distinzione si fonda allora sul significato che dev'essere attribuito a quell'aggettivo qualificativo "naturale", cui pure faremo largo ricorso. Siamo di fronte a una caratterizzazione significativa, che può essere decisa unicamente dalla logica della ragione, conformemente alla riflessione di Federigo Enriques citata in Introduzione. Siamo in effetti di fronte a un problema che riguarda l'essenza delle "cose", e il "nome" delle cose (si ricordino per esempio i nostri tre geniali comici Aldo, Giovanni e Giacomo, quando nello sketch dei "sardi" danno pedantemente un nome a ogni noce, a ogni fiocco di neve, etc.). I due casi estremi che bisogna contemplare sono l'insieme di quei numeri che abbiamo visto si dicono appunto naturali,

{1, 2, 3,...}, dove ogni numero ha un nome ed è perfettamente distinguibile da ciascun altro (ogni sottoinsieme di N che non sia un singleton è decomponibile!), e lo spazio ordinario S, dove nessun punto ha (può avere) un "nome", e gli elementi dell'insieme sono tutti sostanzialmente "uguali" a ciascun altro (ma anche i segmenti di una retta, o le semirette di una retta, "chiuse" o "aperte", sono per esempio insiemi che si presentano all'intelletto omogeneamente, seppure in modo leggermente diverso, come diremo in fine di nota). Tali esempi dimostrano che, se si volesse obiettare che la distinzione proposta è soggettiva, relativa per esempio allo stato dell'informazione del soggetto che è chiamato a decidere se un determinato insieme sia o no indecomponibile, essa assume particolare importanza nel caso di insiemi "universali", rispetto ai quali cioè lo stato della conoscenza può ritenersi "perfetto" in ogni intelletto umano. Potremmo concludere questa prima esposizione di un ambito d'idee poco frequentato, introducendo la nozione di insieme decomponibile in senso stretto, intendendo con ciò un insieme che sia decomponibile mediante una bipartizione naturale, nella quale sia inoltre possibile distinguere in modo pure naturale un primo elemento della partizione da un secondo. Tutti gli insiemi che non sono decomponibili in senso stretto potrebbero dirsi omogenei, o se si preferisce "democratici"! Una specificazione sottile, ma non di poco conto: per esempio, l'insieme delle semirette di una retta (diciamo per esempio chiuse) ammette una bipartizione naturale, che distingue quelle orientate in un certo verso da quelle orientate nell'altro, ma la natura delle due classi di semirette che così si ottengono induce a ritenere che la totalità intera di esse formi un insieme che è sì decomponibile, ma che non è decomponibile in senso stretto. Per contro, l'insieme dei segmenti appare invece proprio indecomponibile tout court (e informiamo subito che tale enunciato risulta essere addirittura equivalente al celebre V postulato di Euclide sulle parallele, ispiratore delle cosiddette geometrie non euclidee, che tanta influenza - non sempre positiva - hanno avuto e continuano ad avere anche in corsi di matematica "elementare" come il presente; si veda quanto se ne dice nello stesso sito che ospita queste dispense). Chiudiamo davvero osservando che quella che precede costituisce un esempio di classificazione (di tutti gli insiemi) effettuata prima per partizione (dicotomica), decomponibili-indecomponibili, e poi per filtrazione: {insiemi decomponibili} É {insiemi decomponibili in senso stretto}.

(I.22) Digressione. Possiamo infine tornare sulla "questione di senso" che avevamo cominciato a trattare introducendo il concetto "intuitivo" di "universo".

[in fase di completamento]

Parte II - Funzioni

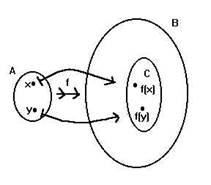

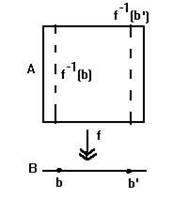

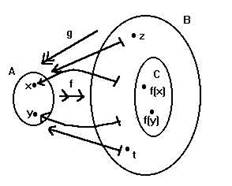

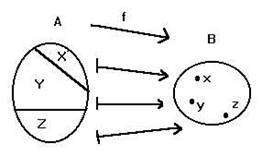

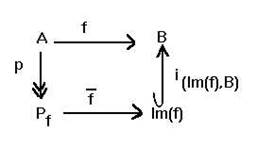

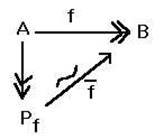

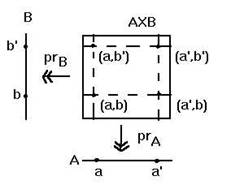

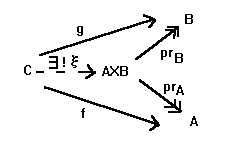

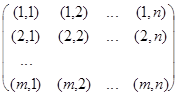

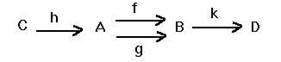

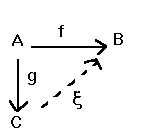

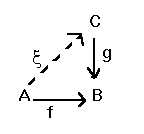

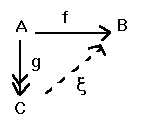

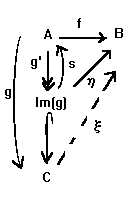

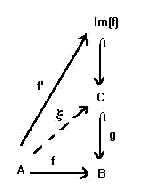

Allo stesso modo primitivo che quello di insieme consideriamo il pur più complesso concetto di funzione. Noi diremo esattamente che abbiamo una funzione, è definita una funzione, è assegnata una funzione, ci troviamo di fronte a una funzione, e chiamiamola pure f, quando ricorrono TUTTE E TRE le seguenti condizioni:

(i) è fissato un insieme di input (termine oggi usuale, potremmo dire in italiano "entrate") della funzione f, che chiameremo dominio di f, indichiamolo per esempio con la lettera A, e se si vuole scriveremo, con ovvia stenografia:

A = dom(f);

(ii) è fissato un insieme di output ("uscite") di f, che chiameremo codominio di f, indichiamolo per esempio con la lettera B, B = codom(f);

(iii) è fissata una legge, o regola, in qualche modo "chiara e distinta", la quale consente di costruire, a partire da un input assegnato in modo ARBITRARIO in A, un UNICO output ad esso corrispondente, o associato tramite f, in B.

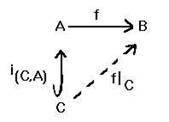

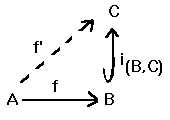

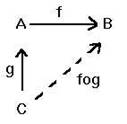

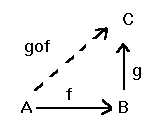

Modi di esprimere una funzione f da A a B, o da A in B, o da A verso B.

f: A ® B, oppure A ![]() B , con il "nome" della funzione che appare sopra la "freccia". La specificazione dell'output y Î B della funzione per un certo input x Î A, si esprime per esempio attraverso l'identità y = f(x); oppure, si riporta sotto al simbolo della funzione il simbolo: x

B , con il "nome" della funzione che appare sopra la "freccia". La specificazione dell'output y Î B della funzione per un certo input x Î A, si esprime per esempio attraverso l'identità y = f(x); oppure, si riporta sotto al simbolo della funzione il simbolo: x ![]() y (si noti che questa nuova particolare freccia è diversa dalla precedente; del resto, A e B sono insiemi, mentre x ed y sono soltanto elementi di insiemi; ® è un simbolo funzionale,

y (si noti che questa nuova particolare freccia è diversa dalla precedente; del resto, A e B sono insiemi, mentre x ed y sono soltanto elementi di insiemi; ® è un simbolo funzionale, ![]() non lo è). Esempio:

non lo è). Esempio:

f: A ® B

x Î A ![]() y = f(x) Î B .

y = f(x) Î B .

[E qui è opportuna una precisazione, in ordine a quel termine "regola", che potrebbe indurre in qualche equivoco. Illustriamo la situazione con un esempio. Supponiamo di avere un insieme A costituito diciamo da tre studenti, indichiamoli con le lettere x, y, z, e di voler definire una funzione da A = {x, y, z} all'insieme I dei due "concetti" Vero, Falso:

I = {Vero, Falso} (sintetizziamoli con le lettere V, F, rispettivamente), mediante la seguente "procedura": se x è biondo, associamo ad x il simbolo V, altrimenti il simbolo F. Supponiamo che y sia l'unico studente biondo tra i tre, ossia che la regola in parola permetta di individuare le seguenti "associazioni": x ![]() F, y

F, y ![]() V, z

V, z ![]() F. Bene, introduciamo adesso, mantenendo inalterati i nostri "dominio" e "codominio", un'altra regola, indubitabilmente diversa da quella precedente. Precisamente, assoceremo a un elemento di A la lettera V se egli risulta nato a Roma, e la lettera F altrimenti. Facciamo l'ipotesi che questa nuova regola individui le seguenti "associazioni": x

F. Bene, introduciamo adesso, mantenendo inalterati i nostri "dominio" e "codominio", un'altra regola, indubitabilmente diversa da quella precedente. Precisamente, assoceremo a un elemento di A la lettera V se egli risulta nato a Roma, e la lettera F altrimenti. Facciamo l'ipotesi che questa nuova regola individui le seguenti "associazioni": x ![]() F, y

F, y ![]() V, z

V, z ![]() F, vale a dire le stesse identiche di prima. L'unico studente biondo dei tre, y, è anche l'unico ad essere nato a Roma. Le regole in esame sono certamente diverse, ma la funzione f : A ® I da A ad I che ne consegue è la stessa. La funzione cioè non coincide con l'algoritmo, o il predicato verbale, con cui essa è stata costruita (cogliamo l'occasione per introdurre dei sinonimi per "regola"), ma unicamente con il suo effettivo manifestarsi: x

F, vale a dire le stesse identiche di prima. L'unico studente biondo dei tre, y, è anche l'unico ad essere nato a Roma. Le regole in esame sono certamente diverse, ma la funzione f : A ® I da A ad I che ne consegue è la stessa. La funzione cioè non coincide con l'algoritmo, o il predicato verbale, con cui essa è stata costruita (cogliamo l'occasione per introdurre dei sinonimi per "regola"), ma unicamente con il suo effettivo manifestarsi: x ![]() F, y

F, y ![]() V, z

V, z ![]() F è una funzione,

F è una funzione,

x ![]() V, y

V, y ![]() V, z

V, z ![]() F è un'altra funzione (e in tutto ne possiamo trovare solo 8 di questo "tipo"). In altre parole ancora, una funzione deve essere concepita soltanto come: 1 - il dato del dominio; 2 - il dato del codominio; 3 - un "elenco" di tutti gli elementi del dominio, a ciascuno dei quali viene "affiancato" uno ed un solo elemento del codominio, punto e basta, indipendentemente da eventuali "descrizioni" che permettono di individuare, specificare, illustrare, tale elenco, ma non sono la funzione. (Ci si occuperà più avanti in maggiore dettaglio di funzioni della natura delle precedenti, che si chiamano funzioni caratteristiche sull'insieme A, dopo che avremo però fissato "canonicamente" come codominio l'insieme

F è un'altra funzione (e in tutto ne possiamo trovare solo 8 di questo "tipo"). In altre parole ancora, una funzione deve essere concepita soltanto come: 1 - il dato del dominio; 2 - il dato del codominio; 3 - un "elenco" di tutti gli elementi del dominio, a ciascuno dei quali viene "affiancato" uno ed un solo elemento del codominio, punto e basta, indipendentemente da eventuali "descrizioni" che permettono di individuare, specificare, illustrare, tale elenco, ma non sono la funzione. (Ci si occuperà più avanti in maggiore dettaglio di funzioni della natura delle precedenti, che si chiamano funzioni caratteristiche sull'insieme A, dopo che avremo però fissato "canonicamente" come codominio l'insieme

{1, 2}, e volendo continuare a mantenere la precedente "interpretazione", convenendo per esempio che sia: 1 ![]() V, 2

V, 2 ![]() F).]

F).]

Esercizio: si esprima, con il linguaggio della logica generale, l'identità tra due funzioni f e g:

(f = g) Û [dom(f) = dom(g) = A]Ù[codom(f) = codom(g) = B]Ù[" x Î A Þ

Þ f(x) = g(x)].

Tutte le funzioni di dominio A e codominio B possono essere chiamate a costituire un unico nuovo insieme, che si indica con il simbolo H(A,B) (un'iniziale "H" della cui origine diremo in seguito).

Come ci sono i sinonimi di insieme, ci sono pure quelli di funzione, che può dirsi infatti: applicazione, corrispondenza, rappresentazione, trasformazione (utilizzato soprattutto in ambito geometrico), o, con un inglesismo, mappa (map), che rimanda concettualmente alla "rappresentazione" di una località su una carta geografica. Tra i sinonimi, particolarmente opportuno quello di morfismo, sia per motivi concettuali (una sorta di anticipazione della teoria delle categorie), sia, come ci persuaderemo presto, linguistici (permettendo le espressioni monomorfismo, epimorfismo, etc.). Particolarmente suggestivo (evocativo di un particolare contesto applicativo) è il termine famiglia, per cui si parla per esempio di una famiglia di elementi di un certo insieme A, oppure di una famiglia di parti (sottoinsiemi) di un certo insieme A. Una famiglia, di elementi o di parti di A, è dotata di un fissato insieme di indici I, ed è semplicemente una funzione, rispettivamente I ® A, oppure I ® P(A). Dato un indice i Î I, è comune indicare il corrispondente di i nella famiglia con un simbolo del tipo ai Î A, oppure, nel secondo caso, con un simbolo del tipo

Ai Î P(A). Un'evenienza pure molto comune è quella in cui I sia l'insieme N, nel qual caso si parla per esempio di una famiglia f in H(N,A) come di una successione di elementi di A, i quali si designano allora, anziché con la notazione f(1) = a1, f(2) = a2, etc., semplicemente come a1, a2, ... .

Osservazioni importanti

- Assoluto obbligo dell'ARBITRARIETÀ dell'input nel dominio: dato un qualsiasi elemento del dominio, deve essere possibile indicare chiaramente senza eccezioni chi è il (articolo determinativo) suo trasformato, o associato, tramite la funzione di cui trattasi (se x è l'input e f la funzione, si deve poter parlare dell'output y di x tramite f, ovvero di y = f(x), usando, come notato, l'articolo determinativo: lo studente principante dovrebbe fare sempre molta attenzione alla differenza tra articoli determinativi e indeterminativi).

- Assoluto obbligo dell'UNIVOCITÀ della funzione: dato un input, ci deve essere un unico output, ovvero, y = f(x) assieme a y' = f(x), con y ¹ y', non può assolutamente verificarsi.

[Per esempio, è illecito scrivere per una radice quadrata ![]() , come qualche volta s'usa, per esempio

, come qualche volta s'usa, per esempio ![]() = ±2, e pensare contemporaneamente alla

= ±2, e pensare contemporaneamente alla ![]() come a una "funzione", che vada per esempio dall'insieme dei numeri reali positivi a quello dei numeri reali tutti; se si vuol pensare alla radice quadrata come a una siffatta funzione, bisogna scrivere

come a una "funzione", che vada per esempio dall'insieme dei numeri reali positivi a quello dei numeri reali tutti; se si vuol pensare alla radice quadrata come a una siffatta funzione, bisogna scrivere ![]() = 2, e basta, mentre vedremo come si possa soddisfare, sempre utilizzando funzioni univoche, il desiderio di esprimere tutti i numeri reali tali che il loro quadrato sia uguale a 4; basterà considerare, con simbolismo autoevidente (R è un simbolo canonico che designa l'insieme dei numeri reali; citiamo adesso questi numeri anche se alla loro costruzione - indispensabile, perché NON si tratta di enti che possano legittimamente considerarsi primitivi - accenneremo appena alla fine del presente corso; ciò nonostante, ci permetteremo di trarre di tanto in tanto qualche esempio da essi desunto, o, se si vuole, dal parallelo corso di Analisi matematica), una funzione da R>0 a P(R), che potrebbe pure dirsi, anziché una funzione univoca da tali citati dominio e codominio, una funzione multivoca da R>0 a R, ma noi preferiremo sempre rispettare le convenzioni precedenti, e parlare costantemente di funzioni univoche, tra dominio e codominio che dovranno essere convenientemente precisati quando si tratti di descrivere certe determinate fenomenologie, come appunto quella della radice quadrata, ovvero della funzione immagine inversa della funzione quadrato - vedi il successivo punto (I.24).]

= 2, e basta, mentre vedremo come si possa soddisfare, sempre utilizzando funzioni univoche, il desiderio di esprimere tutti i numeri reali tali che il loro quadrato sia uguale a 4; basterà considerare, con simbolismo autoevidente (R è un simbolo canonico che designa l'insieme dei numeri reali; citiamo adesso questi numeri anche se alla loro costruzione - indispensabile, perché NON si tratta di enti che possano legittimamente considerarsi primitivi - accenneremo appena alla fine del presente corso; ciò nonostante, ci permetteremo di trarre di tanto in tanto qualche esempio da essi desunto, o, se si vuole, dal parallelo corso di Analisi matematica), una funzione da R>0 a P(R), che potrebbe pure dirsi, anziché una funzione univoca da tali citati dominio e codominio, una funzione multivoca da R>0 a R, ma noi preferiremo sempre rispettare le convenzioni precedenti, e parlare costantemente di funzioni univoche, tra dominio e codominio che dovranno essere convenientemente precisati quando si tratti di descrivere certe determinate fenomenologie, come appunto quella della radice quadrata, ovvero della funzione immagine inversa della funzione quadrato - vedi il successivo punto (I.24).]

- Imprescindibilità della specificazione di dominio e codominio. Se uno studente parla di, pensa di conoscere, etc., una certa funzione f, ma non sa rispondere alle domande: "chi è il dominio di f?", "chi è il codominio di f?", in realtà non conosce perfettamente la funzione. I precedenti interrogativi debbono infatti avere una risposta UNIVOCA, pena la non completa identificazione della funzione di cui si vorrebbe parlare.

[Qualche volta si può invero essere indotti a trascurare tale aspetto, perché la specificazione, peraltro assolutamente necessaria in linea di principio, viene in realtà sottintesa dal particolare contesto in esame. Per esempio, delle funzioni che sono oggetto di studio in Analisi matematica si assegna spesso la sola "regola" di deduzione input ® output, visto che i loro "argomenti" sono, almeno inizialmente, dei semplici numeri reali. Nei casi più elementari, si tratta proprio di un comune dominio e codominio coincidenti con la totalità dei numeri reali: A = B = R (si noti bene che nessuno ha escluso infatti nella precedente "definizione" di funzione tale possibilità, dom(f) = codom(f), e che bisognerà tenere presente che in matematica, come altrove, vigerà sempre la norma: ciò che non è proibito è permesso, fatta salva la facoltà di proibire DOPO quello che ci siamo dimenticati di proibire PRIMA!), mentre nei casi meno elementari diventa più interessante andare a ricercare quali possano essere i domini ammissibili per certe "regole", ed un eventuale dominio massimo (che si dice il campo di definizione della "funzione").]

- Analogamente, e va da sé, dato un qualsiasi input x Î dom(f), bisogna essere in grado di specificare con assoluta precisione quale sia l'unico output

f(x) Î codom(f), ovvero quale sia la regola di trasformazione input ® output, pena al solito la non completa identificazione della funzione di cui si tratta. (Nella pratica, tale prescrizione viene ad essere talvolta sfumata, qualora si introducano nel corso di un ragionamento alcune funzioni della cui esistenza si è in qualche modo "certi", ma che non si "danno" - è impossibile dare! - effettivamente; vedremo nel seguito numerosi casi in cui tale circostanza si concretizza).

- Chiudiamo con un esempio di possibile pedanteria nella specificazione tanto di dom(f), quanto di codom(f). Se si prende per esempio la ben conosciuta funzione trigonometrica coseno, simbolo cos(x), il cui argomento x può essere un qualsivoglia numero reale, bisogna specificare a rigore il dominio e il codominio di tale funzione, ed ecco che per esempio cos: R ® R è una precisazione accettabile. Del resto, sarebbe pure corretto scrivere

cos: R ® [-1,1], oppure, cos: [0,2p] ® [-1,1], dove p è il celebre numero reale che esprime il rapporto tra la lunghezza di una circonferenza e il suo diametro (si ricordi che [a,b], per due numeri reali a, b, con a < b, designa la totalità dei numeri reali x compresi tra a e b, ovvero: [a,b] = {" x Î R ½ a £ x £ b}), e in ciascuno dei casi riportati non si è "perduta" alcuna informazione sulla funzione coseno. A rigore però, dal punto di vista della teoria degli insiemi e delle funzioni, tutte queste dovrebbero essere considerate funzioni diverse, e si dovrebbero usare simboli diversi per designarle; ciò nonostante, e a ragione, è raro nella pratica spingersi fino a tanto, almeno quando, come nel caso esaminato, il contesto semantico, cioè quello di utilizzo degli enti matematici che intervengono in un certo discorso, non lasci spazio a fraintendimenti gravi. Ciò non toglie che dovremmo in ogni caso essere capaci di rendere un'argomentazione sempre più formalmente corretta, fino al limite della "perfezione", eliminando tutte le eventuali omissioni, semmai dietro richiesta (sottolineiamo ancora una volta, di altri o di noi stessi), e soprattutto capaci di comprendere il senso delle precisazioni sollecitate.