I riassunti , gli appunti i testi contenuti nel nostro sito sono messi a disposizione gratuitamente con finalità illustrative didattiche, scientifiche, a carattere sociale, civile e culturale a tutti i possibili interessati secondo il concetto del fair use e con l' obiettivo del rispetto della direttiva europea 2001/29/CE e dell' art. 70 della legge 633/1941 sul diritto d'autore

Le informazioni di medicina e salute contenute nel sito sono di natura generale ed a scopo puramente divulgativo e per questo motivo non possono sostituire in alcun caso il consiglio di un medico (ovvero un soggetto abilitato legalmente alla professione).

La statistica è uno strumento fondamentale nell’analisi e nell’interpretazione dei risultati di un esperimento. Grazie a questa tecnica, è possibile indicare il valore più rappresentativo di una misura e darne una stima ragionevole dell’intervallo di variabilità. Le leggi naturali che si trovano nei libri di testo, però, non menzionano assolutamente la statistica e gli errori. Ad esempio, la legge di Coulomb è semplice e chiara. L’esponente che compare al denominatore è esattamente 2, no 2.01±0.015 o 1.98±0.04 o qualcosa di simile. Come si risolve quest’apparente paradosso?

La soluzione è molto semplice. Quando si studia un argomento scientifico ormai ben stabilito, non ha alcun senso discutere sulle misure e la loro precisione. Tuttavia, quando si fa scienza, e si vuole comprendere il significato delle misure, diventa indispensabile l’ausilio della statistica. Tornando all’esempio della legge di Coulomb, l’esperimento originale di Cavendish del 1772, basato sulla carica di sfere metalliche concentriche, aveva indicato un esponente 2+e, dove çeç<0.02. Circa cento anni più tardi, il grande Maxwell ripeté l’esperimento fissando un limite superiore çeç<5´10-5. Al momento, l’esponente 2 è preciso entro un limite e= (2.7±3.1)´10-16 !

Inoltre, la rappresentazione dei fenomeni fisici mediante formule matematiche può indurre a pensare che una scienza esatta lo sia in senso matematico. Nulla di più sbagliato! Cerchiamo di chiarire in che senso e con quali limiti l’aggettivo esatto è usato in questo contesto con un esempio. La legge di Ohm, V=RI, permette di prevedere il valore della corrente elettrica che attraverserà un resistore da 100 W se si applica un generatore di forza elettromotrice da 10 V: I=100 mA. Se si esegue la misura con un milliamperometro è però probabile che si trovi un valore vicino a, ma non esattamente uguale a 100 mA. Naturalmente, una prima spiegazione della discrepanza si basa sul fatto che lo strumento usato non è perfetto. In parte ciò sarà vero, ma in realtà vi è qualcosa di molto più profondo alla base. Se si prova a ripetere la misura con lo stesso strumento, molto probabilmente si osserverà un valore diverso dal primo. Analogamente, rifacendo le misure con strumenti via via più sensibili, si nota che i risultati scartano tra loro in modo sempre più evidente. Le misure più raffinate vi porteranno a concludere che il modello di resistore da 100 W va modificato, ad esempio, per tener conto della dipendenza della resistenza dalla temperatura, dalla potenza dissipata durante la misura, dalla frequenza del segnale di eccitazione, ecc. Se gli scarti nelle misure sono dovuti al fatto che le condizioni sperimentali (temperatura, pressione, umidità, ecc.) non sono perfettamente controllate, potreste pensare allora di modificare l'assetto sperimentale per ottenere un maggior controllo.

In tutte queste fasi, dalla formulazione matematicadelle leggi al senso da attribuire loro, l’utilizzo degli algoritmi statistici è fondamentale. In queste dispense, si descriveranno i concetti base della statistica e della teoria degli errori con l’intento di introdurre un metodo che ogni sperimentatore deve seguire per analizzare ed interpretare i risultati in maniera scientificamente corretta. Per la loro stesura, mi sono giovato dei seguenti testi, che consiglio per l’approfondimento dei concetti qui presentati:

ed in particolare di

Una disciplina diviene una scienza esatta quando unisce la capacità descrittiva della realtà a quella predittiva, cioè quando è in grado di predire l'evoluzione di un sistema note le condizioni al contorno. La base per il passaggio da scienza descrittiva a scienza esatta è il metodo scientifico, una complessa costruzione i cui pilastri fondamentali cercheremo di illustrare nel seguito.

I fenomeni naturali osservati possono essere semplicemente descritti nella grande variabilità di condizioni in cui essi avvengono. Se viceversa si riescono ad individuare delle caratteristiche comuni che suggeriscono delle corrispondenze di causa-effetto, è possibile formulare delle relazioni generali capaci di descrivere il fenomeno nell'ambito di un'unica schematizzazione che tenga conto della grande variabilità di parametri che possono influenzarlo. Se le grandezze di cui si sospetta la correlazione vengono misurate, è possibile tradurre la relazione generale in un formalismo matematico che prende il nome di legge (naturale).

Un passaggio successivo è quello che consente di unificare un insieme di leggi, che descrivono fenomeni diversi (per esempio il moto dei corpi), in un modellodella realtà (nel caso dell'esempio fatto prima, il modello della dinamica di Galileo-Netwon). Nel modello, la realtà fisica viene spogliata dei dettagli ed è schematicamente rappresentata attribuendo precise proprietà agli oggetti e stabilendo relazioni causali tra le varie grandezze in gioco. Tornando al caso della meccanica classica, agli oggetti viene assegnata una massa, il loro moto è rappresentato mediante i vettori posizione, velocità ed accelerazione ed è regolato dai primi due principi di Newton.

Un modello può anche prevedere fenomeni mai osservati, e ciò apre la strada alla sperimentazione. Una volta formulato il modello è possibile, cioè, riprodurre artificialmentei fenomeni osservati, in condizioni semplificate per agevolarne lo studio, o anche progettare l'osservazione di fenomeni nuovi suggeriti dal modello stesso ma non ancora osservati, attraverso la predisposizione di apparati sperimentali. Questa è la fase della sperimentazione di laboratorio, che può confermare o negare le previsioni dedotte dall’analisi matematica del modello. In caso affermativo, l'impianto teorico-formale (il modello) ne esce rafforzato, altrimenti esso viene negato e ciò spinge a una revisione delle ipotesi (la schematizzazione) per trovare l'inconsistenza. In entrambi i casi ne segue un avanzamento della conoscenza!

Come esempio di questo processo valutativo, citiamo l'esperimento di Michelson e Morley realizzato per studiare l’influenza del moto di una sorgente luminosa sulla velocità della luce. Contrariamente a quanto predetto dalla composizione dei moti relativi prevista dal modello galileiano, l’esperimento mostrò che la velocità della luce risultava invariante rispetto al sistema di riferimento considerato. Questa contraddizione impose una revisione delle ipotesi su cui si fondava la meccanica classica che consentisse una rappresentazione coerente di tutti i fenomeni osservati, inclusa l'invarianza della velocità della luce. Il nuovo modello, che risponde a questo requisito, è la Relatività Speciale, formulata da Einstein e che si riduce alla meccanica galileiana solo quando le velocità in gioco sono piccole rispetto alla velocità della luce. La meccanica galileiana non è quindi un’errata rappresentazione della realtà: essa è solo una rappresentazione valida nella approssimazione v«c.

Un altro esempio viene dalla critica dell'ipotesi fondamentale della teoria della misura. Si assume che l'operazione di misura possa essere eseguita apportando variazioni trascurabili al sistema da misurare. Questa ipotesi implica che l'energia scambiata tra le sonde che usiamo per misurare e il campione sotto osservazione possa essere resa piccola a piacere. Per eseguire una misura si deve infatti stimolare il sistema osservato (eccitazione) e rilevarne la risposta (segnale). Tuttavia, se le dimensioni del sistema si riducono sempre più arrivando a livello atomico o subatomico, l'operazione di misura porterà inevitabilmente delle perturbazioni finiteal sistema studiato. Diviene così impossibile misurare con precisione qualsivoglia e contemporaneamente alcune coppie di grandezze come posizione e velocità. Da questo segue il principio di indeterminazione di Heisenberg che è alla base dello sviluppo della meccanica quantistica.

Riassumendo, il metodo scientifico si sviluppa secondo una successione di fasi distinte che potremo schematicamente suddividere in:

Questi brevi accenni mostrano come il metodo scientifico sia un intreccio indissolubile di esperimenti e di teoria (cioè di sistematizzazione razionale dei risultati sperimentali) e che voler stabilire il predominio degli uni sull'altra o viceversa significherebbe la fine della straordinaria fertilità di idee e di conoscenze che esso ha prodotto finora e che presumibilmente è in grado di produrre ulteriormente.

L'operazione di misura è uno dei passaggi più critici del metodo scientifico. Essa richiede la definizione operativa delle grandezze da misurare. Si tratta di definizioni che devono prevedere le modalità pratiche di misura, cioè di tutte le operazioni necessarie per confrontarela specifica grandezza in esame con un "campione"che sia stato arbitrariamente definito come l'unità di misura. Il risultato finale dell'operazione di misura è un numeroseguito da un simbolo:il numero rappresenta il rapporto tra la grandezza e il campione e il simbolo specifica la particolare unità di misura usata.

Per eseguire tale associazione, è necessario disporre di strumenti che permettano un rapido e accurato confronto tra la grandezza da misurare e la corrispondente unità di misura, e di regole per stabilire in maniera oggettiva la stima dell’incertezza sulla misura dal tipo di strumenti usati, dalle condizioni in cui si è svolta la misura…

2.1 L’operazione di misura

Per facilitare la comprensione di come concettualmente si opera la misura di una grandezza, facciamo un semplice esempio. La distanzatra due punti può essere definita come la lunghezza di un'asta rigida rettilinea che li congiunge. In tal caso l'operazione di misura consisterà nel porre l'estremità di un'asta (sufficientemente lunga) a coincidere in uno dei due punti, ruotare l'asta fino a che essa intercetta l'altro punto e segnare poi la corrispondente posizione sull'asta. A questo punto l'operazione finale consisterà nel trovare quante volte il campione (una seconda asticella) è contenuto nel tratto d'asta segnato. Osservate che la definizione di distanza tra due punti che abbiamo appena dato coincide con la definizione geometrica di minima distanza tra due punti (in uno spazio euclideo). Questa definizione non è l'unica possibile e soprattutto non è detto che sia operativamente applicabile. Ad esempio, per due punti posti sulla superficie di una sfera di acciaio si potrebbe definire la loro distanza come la minima distanza lungo la superficie. In tal caso l'operazione di misura consisterebbe nel collegare i due punti tendendo tra loro un sottile filo flessibile e misurando poi la sua lunghezza come nel caso precedente. Le due definizioni sono diverse e quindi porteranno in generale a due risultati diversi. Osservate però che in entrambi i casi la definizione contiene (implicitamente) le modalità operative della misura.

Spesso la definizione delle grandezze avviene attraverso la loro specificazione in funzione di altre grandezze già definite in precedenza. Si parla in tal caso di misura indiretta. Per esempio, la velocità (media) di un oggetto è definita dallo spazio percorso per unità di tempo. Questa definizione implica che:

1- le grandezze spazio e tempo siano già state definite insieme alle rispettive unità di misura;

2- la misura della velocità avvenga misurando lo spazio percorso dall'oggetto in un intervallo di tempo anch'esso misurato.

Il rapporto tra queste due misure fornisce la misura della velocità in unità pari al rapporto delle unità di misura dello spazio e del tempo.

In questa definizione è implicito che la grandezza velocità è una grandezza derivata dalle due grandezze fondamentali spazio e tempo. La distinzione tra grandezze fondamentali e derivate, in linea di principio, è del tutto arbitraria. Disponendo di un campione di velocità (unità di misura della velocità), si potrebbe misurare direttamente la velocità, secondo le modalità di confronto della velocità da misurare con il campione insite nella nuova definizione di velocità. La distanza tra due punti (lungo una traiettoria) diventerebbe quindi una grandezza derivata definita come il prodotto della velocità per il tempo impiegato a percorrerla.

2.2 I sistemi di misura

Riflettendo sul problema della definizione operativa di una grandezza e della sua unità di misura, ci si rende immediatamente conto che la scelta delle grandezze fondamentali è in realtà meno arbitraria di quanto non possa apparire. Infatti tale scelta dipenderà dai seguenti fattori:

1- la facilità con cui si può predisporre un campione della grandezza (unità di misura);

2- la facilità con cui questo campione può essere diffuso, in modo che misure compiute in luoghi diversi da diverse persone possano essere confrontabili, cioè trasmissibili ad altri;

3-la facilità dell'operazione di misura delle grandezze fondamentali.

Ad esempio, è evidente che, in base a questi fattori, è molto più semplice disporre di un campione di lunghezza piuttosto che di un campione di velocità e che in ogni caso è molto più facile misurare una lunghezza piuttosto che una velocità.

L'insieme delle grandezze fondamentali e delle relative unità di misura si chiama Sistema di Unità di Misura. Storicamente se ne sono sviluppati parecchi, ma l'esigenza di trasmissibilità dei risultati delle misure ha portato all'adozione internazionale di un solo sistema che viene quindi indicato come Sistema Standard Internazionale(in sigla SI). In questo sistema le grandezze fondamentali sono lunghezza (L), tempo (T), massa (M) e intensità di corrente elettrica (I) con le unità di misura che sono rispettivamente il metro (m), il secondo (s), il chilogrammo (Kg) e l'ampere (A). Le unità di misura delle altre grandezze sono univocamente determinate dalle relazioni algebriche che le legano alle grandezze fondamentali, ossia sono dei prodotti di potenze (positive e negative) delle unità fondamentali. Tali prodotti di potenze costituiscono anche la dimensione della grandezza derivata. Per esempio la velocità ha dimensione [L T-l ] (lunghezza diviso tempo) essendo definita come il rapporto tra una lunghezza e un tempo. Vi sono grandezze che hanno dimensione nulla essendo definite come il rapporto tra due grandezze della stessa dimensione (omogenee): per esempio l'angolo nel piano è definito come il rapporto tra l'arco e il raggio (entrambe le quantità hanno le dimensioni di una lunghezza). In questi casi è bene prestare attenzione perché l'esigenza di una coerenza con le altre unità di misura non risulta da un'analisi dimensionale. Data la definizione di angolo, la sua unità di misura corretta è il radiante, anche se all'interno di funzioni trigonometriche (per esempio) si può usare l'unità di misura che più aggrada (purché coerente con il metodo di calcolo).

Poiché le scale su cui avvengono i fenomeni naturali variano di moltissimi ordini di grandezza, è utile ricorrere a multipli e sottomultipli delle unità di misura. Anche in questo caso, per non inflazionare eccessivamente i simboli necessari, si è convenuto di usare esclusivamente multipli e sottomultipli che differiscono tra loro e dall'unità di misura (in più o in meno) di fattori 103. I prefissi all'unità di misura, la loro pronuncia e il loro significato sono i seguenti:

a (atto) = 10-18

f (femto)= 10-15

p (pico )= 10-12

n (nano)= 10-9

Il (micro) = 10-6

m (milli) = 10-3

K (chilo) = 103

M (mega)= 106

G (giga)= 109

T ( tera)= 1012

Nel SI, per esempio, il cm (10-2 m) è un'unità (sottomultiplo) "illegale"così come l'ettogrammo (10-1 Kg) o l'Angstrom (10-10 m), anche se in ambienti specifici queste unità sono tuttora correntemente usate.

L'operazione di misura, per quanto complicata possa essere, ha il pregio fondamentale di concludersi con un numero. Le relazioni tra grandezze divengono quindi relazioni tra numeri, cioè relazioni matematiche, e in definitiva la fase di sperimentazione nel metodo scientifico si conclude con la formulazione di una legge naturaleche è espressa da un'equazione matematica tra le grandezze in gioco.

2.3 Gli strumenti di misura

Lo strumento di misura è un apparato che permette il confronto tra la grandezza misurata e l’unità di misura. Esso è costituito da una parte sensibile in qualche modo alla grandezza da misurare, che si può chiamare sensore,eventualmente da un dispositivo trasduttoreche traduce le variazioni della grandezza caratteristica del rivelatore in quelle di un’altra grandezza più facilmente accessibile allo sperimentatore, e da un dispositivo che presenta il risultato della misura ai sensi, generalmente alla vista, dello sperimentatore, direttamente o con una registrazione grafica o di altro genere.

Così in un calibro, strumento per la misura di spessori, il sensore è costituito dalla ganascia mobile col cursore ad essa solidale, e che può scorrere nella guida facente corpo unico con la ganascia fissa; mentre l’elemento indicatore è costituito dalla scala graduata in millimetri tracciata sulla guida e dai segno di fede inciso sul cursore, generalmente insieme ad una scala graduata ausiliaria (nonio)per la lettura delle frazioni di millimetro. La grandezza letta sulla scala è qui direttamente la grandezza stessa. In un termometro a liquido, l’elemento sensibile alla temperatura è il liquido contenuto nel bulbo; esso funge almeno in parte anche da trasduttore, perché la proprietà termometrica che si osserva è il volume del rivelatore stesso. Il tubo capillare a sezione costante traduce le variazioni di volume del rivelatore in variazioni di lunghezza della colonna di liquido ivi contenuta. Il menisco che separa il liquido dal suo vapore nel capillare funge da indicatore, assieme con la scala tracciata sulla superficie esterna del tubo o sopra un regolo ad essa solidale. La grandezza letta sulla scala è la distanza del menisco da un segno di riferimento che può essere messa in corrispondenza con la temperatura per mezzo di una tabella di conversione o, come spesso accade, le temperature corrispondenti sono scritte accanto alle tacche della scala.

Le caratteristiche più importanti di uno strumento sono le seguenti:

Per sfruttare a pieno le possibilità di uno strumento di misura, è opportuno che la sensibilità non sia inferiore alla precisione; gli strumenti di uso corrente sono costruiti con una sensibilità circa eguale alla precisione in condizioni normali d’uso.

2.4 Errori di misura

Come accennato in relazione alla precisione di uno strumento, se si esegue una misura di una. qualsiasi grandezza fisica si commettono inevitabilmente errori; conseguentemente il valore ottenuto per la grandezza misurata non è mai esattamente eguale ai suo vero valore, che non sarà perciò mai noto con precisione arbitrariamente grande (diversamente da quanto accade con una costante matematica, come ad esempio p). Prima di proseguire facciamo subito chiarezza sul significato del termine errore. In questo contesto l'errore è l'intervallo di confidenza (o la sua stima) della misura. La maggior abilità di uno sperimentatore e la miglior qualità degli strumenti e degli apparati sperimentali potranno ridurre questo intervallo di confidenza, ma non potranno mai ridurlo ad un punto. Questo non ha nulla a che vedere con la normale accezione di errore come sbaglio, strafalcione, ecc. Che, ovviamente, non possono trovare spazio in una scienza.

Quando si ripete la misura della stessa grandezza col medesimo strumento, nelle medesime condizioni e seguendo la medesima procedura, la presenza di varie cause di errore che andremo ad esaminare produce delle differenze tra il valore misurato ed il valore vero; differenze variabili da una misura all’altra in modo imprevedibile. In conseguenza di ciò, i risultati di queste misure ripetute (se lo strumento è abbastanza sensibile) fluttueranno apprezzabilmente in maniera casuale in un certo intervallo, la cui ampiezza definisce la precisione delle misure stesse. Gli errori di questo tipo si dicono errori casuali, e la loro esistenza è facilmente accertabile con l’uso di un qualsiasi strumento sensibile. Possono essere ridotti migliorando le caratteristiche dello strumento, controllando più strettamente le condizioni in cui si esegue la misura… ma non possono mai essere eliminati. Posseggono tuttavia certe regolarità statistiche, che verranno presentate nei capitoli successivi, e possono pertanto essere accuratamente stimati.

Tuttavia certe cause di errore possono dar luogo a una discrepanza tra valore misurato e valore vero che si riproduce inalterata nelle misure ripetute di cui sopra, e la inosservabilità delle fluttuazioni non garantisce per nulla che la discrepanza sia inferiore all’incertezza di lettura dello strumento; né si può esser certi che essa sia contenuta entro l’intervallo di variabilità degli errori casuali (quando esso sia maggiore dell’incertezza di lettura). Gli errori di questo secondo tipo si dicono errori sistematici perché, ripetendo la misura nelle stesse condizioni sperimentali, si manifestano sempre con lo stesso segno, ed in alcuni casi, con lo stesso valore. Cause di errori sistematici possono essere quelle elencate nel seguito (ma la lista non è necessariamente completa):

Gli errori sistematici sono i più insidiosi da scovare perché non immediatamente osservabili: non si sa mai se stanno influenzando le misure e non si è mai certi che non le influenzino. Un modo per rivelarne la presenza può essere quello di misurare, se possibile, la stessa grandezza con strumenti e metodi diversi; questi presumibilmente sono affetti da errori diversi e possono fornire perciò risultati differenti. Tuttavia, neppure l’assenza di questo effetto dà la certezza che la misura sia esente da errori sistematici, ed essi sono generalmente individuati da una attenta e minuziosa critica sia dello strumento o, più in generale, della tecnica usati, sia della procedura seguita nella misura. Una volta scoperto, un errore sistematico può essere facilmente eliminato modificando lo strumento o la procedura, oppure apportando una opportuna correzione al risultato della misura.

Osserviamo che, in generale, le possibili cause d’errore sistematico possono produrre anche errori casuali: così, per il primo tipo, gli inevitabili giochi meccanici e gli attriti tra parti dello strumento in moto relativi dar luogo a risultati fluttuanti; per quanto riguarda il secondo tipo, condizioni ambientali variabili e non del tutto controllabili (come temperatura, umidità e pressione) possono produrre variazioni imprevedibili del risultato, e così via.

2.5 Cifre significative ed arrotondamenti

Abbiamo visto che il modo corretto per esprimere il risultato di una misura consiste nel dare la miglior stima della quantità considerata seguita da un intervallo di confidenza entro il quale è alquanto probabile che il valore sia racchiuso.

Prima di procedere ad una discussione statistica del modo migliore per stabilire il valore più rappresentativo e l’errore di una misura, è utile puntualizzare alcune regole generali su come esprimere le incertezze.

Innanzitutto, dato che l’errore è la stima di un’incertezza, non ha senso esprimerlo con troppa precisione. In altre parole, è ovviamente assurdo riportare un risultato del tipo

L=10.1±0.5839 m

E’ inconcepibile che l’incertezza nella misura si possa conoscere al meglio di quattro cifre significative. In esperimenti di elevata precisione, gli errori sono espressi in due o massimo tre cifre significative, ma il più delle volte, come nei corsi di laboratorio, possiamo affermare la regola seguente:

Regola per esprimere le incertezze

Per quasi tutte le misure, escluse quelle di elevata precisione,

gli errori dovrebbero essere arrotondati alla prima cifra significativa.

Quindi, se i risultati dei calcoli danno dL=0.5839…m, nel risultato finale la risposta dovrebbe essere arrotondata a 0.6 m e quindi la conclusione diventerebbe

L=10.1±0.6 m

C’è una sola importante eccezione a questa regola. Se la prima cifra significativa nell’incertezza dx è un 1, allora è meglio arrotondarla alla seconda cifra significativa. Ad esempio, se dx=0.0143 g, arrotondarlo a 0.01 porterebbe ad una sostanziale riduzione proporzionale del suo valore, quindi è più accurato esprimerlo come 0.014. Lo stesso ragionamento si può applicare se la prima cifra significativa è 2, ma certamente no se è più grande.

Stabilita la stima dell’errore di una misura, si deve considerare quali sono le cifre significative nel valore più rappresentativo. Una scritta del tipo

V=523.7594 ± 2.2 m/sec

è ovviamente ridicola. L’incertezza di 2.2 implica che la cifra 3 nel terzo posto di 523.7594 potrebbe essere piccola quanto 1 o grande quanto 5. Chiaramente, le cifre che seguono, 7, 5, 9 e 4 non hanno alcuna rilevanza e dovrebbero essere arrotondate. Quindi, la velocità precedente dovrebbe riscriversi più correttamente come

V=524 ± 2.2 m/sec

Quanto discusso finora può essere sintetizzato nella seguente regola:

Regola per esprimere le risposte

L’ultima cifra significativa del valore più attendibile di qualsiasi misura

deve essere nella stessa posizione decimale dell’incertezza.

Per esempio, la risposta 92.81 con un’incertezza di 0.3 dovrebbe essere arrotondata a 92.8±0.3. Se l’errore è 3, allora la misura dovrebbe riscriversi come 93±3, mentre se l’incertezza è pari a 30, allora la risposta è 90±30.

Tuttavia, i numeri che si usano nei calcoli si possono (devono) tenere con più cifre significative per evitare effetti di propagazione degli arrotondamenti. Il risultato finale deve però essere arrotondato secondo la regola sopra esposta.

Abbiamo già osservato che il risultato di una misura è un dato. Può chiamarsi anche campione o evento, ma indipendentemente dal nome è l’unità elementare di conoscenza di un dato fenomeno da cui si vuole estrarre dell’informazione attendibile.

Per trasmettere ad altri questa informazione in maniera rapida, incisiva ed efficace, è necessario rappresentarli graficamente o sintetizzarli in pochi, precisi numeri. Questo capitolo riguarda i metodi per rappresentare i dati in modo utile e chiaro senza farne un’analisi troppo approfondita. Ciò rientra nella cosiddetta statistica descrittiva.

3.1 Tipi di dati

I dati si chiamano quantitativi se si possono esprimere mediante numeri, altrimenti vengono detti qualitativi o non-numerici. I dati qualitativi si presentano soprattutto nelle scienze sociali e sono difficili da trattare in quanto non permettono un trattamento matematico rigoroso.

I dati quantitativi si possono ulteriormente dividere in discreti, se sono esprimibili mediante numeri interi, o continui se si devono usare numeri reali. Ovviamente, per questi dati è necessario un qualche tipo di arrotondamento, dato che è impossibile scrivere una serie infinita di decimali. Per esempio, se consideriamo un insieme di auto, il loro colore è una variabile di tipo qualitativo, il numero di sedili è intera mentre la lunghezza è continua.

La prima operazione da fare quando si ha una serie di dati grezzi è cercare di raggrupparli in classi, o blocchi, o gruppi. Questo è facile con i dati discreti: per esempio il numero di volte che il rosso (R) o il nero (N) sono usciti alla roulette. Supponiamo che su 20 lanci della pallina la sequenza dei risultati sia stata

{N,R,N,N,R,N,R,N,N,N,R,R,N,N,R,N,R,N,N,R}

Un modo più compatto e chiaro di scrivere il risultato è il seguente:12N, 8R, però si è persa l’informazione sulla sequenza degli eventi.

Per dati continui non è così semplice, dato che i loro valori, molto probabilmente, saranno tutti diversi. Per raggrupparli diventa necessario suddividerli in intervalli di valori per ogni blocco o gruppo contando quanti numeri cadono in un dato intervallo. Questo implica un ulteriore arrotondamento del dato e quindi un’ulteriore perdita di informazione: questo è lo scotto da pagare per sintetizzare i dati, per esempio rappresentandoli con un istogramma.

3.2 Diagrammi a barre ed istogrammi

Un insieme di dati discreti può essere rappresentato graficamente mediante un diagramma a barre, la cui altezza è proporzionale al numero delle uscite come mostrato in fig. 3.1. Questi diagrammi si possono ovviamente applicare sia a dati quantitativi, sia qualitativi. Per i dati quantitativi si può anche usare un istogramma, in cui la base del rettangolo è proporzionale alla larghezza dell’intervallo di valori considerato, mentre la sua altezza indica il numero di dati compresi in quel range. E’ opportuno rimarcare la differenza concettuale tra diagramma a barre, in cui il dato significativo è l’altezza della barra, e l’istogramma, in cui il dato importante è l’area della barra. Ciò è importante se si adotta una suddivisione dei valori non uniforme.

Per i dati numerici, la scelta della larghezza dell’intervallo di valori per i dati è molto importante (vedi figura 3.2). Se l’intervallo è troppo piccolo, in ogni gruppo ci saranno pochi eventi e l’altezza sarà totalmente dominata dalle fluttuazioni statistiche; se invece l’intervallo è troppo grande, dettagli reali della distribuzione possono andar persi. Non esistono regole fisse di comportamento: sta a voi decidereil modo migliore di operare. Ecco il primo esempio di come l’elemento soggettivo entra nel trattamento dei dati e di come sia necessario essere guidati dal buon senso!

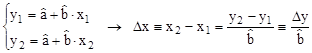

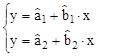

In altri casi i vostri dati saranno coppie di valori di due grandezze di cui sospettate o volete mettere in evidenza una correlazione o una vera e propria dipendenza funzionale (per esempio la tensione e la corrente nel tentativo di stabilire la legge di Ohm). Il modo più conveniente di fare questo è di rappresentare i vostri dati come punti in un piano cartesiano xy. Per fare questo è utile tenere presenti alcune semplici regole.

y=axb

riportata in un grafico log-log diviene

logy =loga+blogx

ovvero

per cui l’esponente bpuò essere immediatamente misurato dalla pendenza della retta risultante. In questo caso una sola avvertenza: attenzione a tener conto della dimensione delle decadi, se questa non è la stessa sui due assi. Questo non è un problema se usate della carta log-log perché generalmente essa viene stampata in modo da avere decadi della stessa dimensione sui due assi (e in ogni caso le dimensioni sono riportate in cima al foglio). Diverso è il caso se costruite il vostro grafico con un computer: generalmente la dimensione delle decadi sui due assi viene stabilita dal formato con cui il grafico viene stampato!

Indipendentemente dal tipo di grafico (lineare o logaritmico) e dal tipo di elaborazione (fit lineare o nonlineare) potreste scoprire che la vostra elaborazione non descrive affatto l’andamento dei dati e questo semplicemente perché avete sbagliato a introdurre un dato. Oppure potreste scoprire che l’elaborazione è buona solo in certo intervallo di valori. Avreste allora due possibilità: usare funzioni di fittingpiù complicate o ripetere l’elaborazione per i dati in un intervallo più ristretto. Quest’ultima soluzione vale in particolare quando volete interpolare linearmente un. tratto di curva che sapete a priori non essere una retta! In ogni caso, è sempre bene attenersi alla seguente

Regola per graficare il fit di dati

Il risultato della vostra elaborazione (o la curva teorica attesa)

deve sempre essere riportato sul grafico in modo da qualificare visivamente

(e quindi nel modo più rapido ed efficace) il risultato della misura.

3.3 Stime di tendenza centrale

Dato un insieme di dati numerici di una grandezza fisica non tutti coincidenti, è necessario definire un algoritmo che fornisca la stima migliore del valore vero della grandezza osservata; cioè di determinare quale, tra le infinite funzioni dei dati, ha la maggiore probabilità di dare il valore vero.

Ora, se supponiamo di avere eliminato tutti gli errori sistematici, è intuitivo come il valore di tale stima debba corrispondere ad una posizionecentrale nella distribuzione dei valori osservati. Nella statistica esistono varie stime della cosiddetta tendenza centrale di una distribuzione; la più immediata di queste stime è il valore corrispondente al massimo della frequenza, cioè il valore che si presenta il maggior numero di volte (ovvero la media dei valori contiguiche presentassero tutti la medesima massima frequenza): tale stima (se esiste) si chiama modadella distribuzione, e si indica con il simbolo ![]() . In generale però la distribuzione potrebbe non avere massimo oppure averne più d’uno in punti non contigui (distribuzioni multimodali ), anche se questo non dovrebbe essere il caso per le distribuzioni di misure ripetute. Per questi motivi la moda non è di uso molto frequente, e non è opportuna in questo contesto anche per ragioni che saranno esaminate più avanti.

. In generale però la distribuzione potrebbe non avere massimo oppure averne più d’uno in punti non contigui (distribuzioni multimodali ), anche se questo non dovrebbe essere il caso per le distribuzioni di misure ripetute. Per questi motivi la moda non è di uso molto frequente, e non è opportuna in questo contesto anche per ragioni che saranno esaminate più avanti.

Un’altra stima di uso frequente nella statistica è la medianadi una distribuzione, ![]() , definita come quel valore che divide l’istogramma dei dati in due parti di uguale area; in termini meno precisi, la mediana lascia un ugual numero di dati alla propria sinistra ed alla propria destra. Usando questa definizione, per trovare la mediana di un insieme di dati tutti distinti basta disporli in ordine crescente e prendere il valore centrale (per un numero dispari di misure; si prende la semisomma dei due valori centrali se le misure sono in numero pari). Al contrario della moda, la mediana esiste sempre; nel diagramma della frequenza cumulativa è definita dall’ascissa corrispondente all’ordinata del 50%.

, definita come quel valore che divide l’istogramma dei dati in due parti di uguale area; in termini meno precisi, la mediana lascia un ugual numero di dati alla propria sinistra ed alla propria destra. Usando questa definizione, per trovare la mediana di un insieme di dati tutti distinti basta disporli in ordine crescente e prendere il valore centrale (per un numero dispari di misure; si prende la semisomma dei due valori centrali se le misure sono in numero pari). Al contrario della moda, la mediana esiste sempre; nel diagramma della frequenza cumulativa è definita dall’ascissa corrispondente all’ordinata del 50%.

Si può dimostrare anche che la mediana ![]() è quel valore di x che rende minima la somma dei valori assoluti degli scarti dalle nostre misure xi da x; cioè tale che

è quel valore di x che rende minima la somma dei valori assoluti degli scarti dalle nostre misure xi da x; cioè tale che

![]()

La stima di gran lunga più usata del centro di una distribuzione di N dati numerici è la media aritmeticadei valori osservati ![]() , definita attraverso la

, definita attraverso la

![]()

La media aritmetica gode delle seguenti proprietà:

![]()

come si può dedurre derivando la sommatoria in parentesi grafa.

In figura 3.3 sono riportate le tre stime introdotte finora, ovverosia la moda, la mediana e la media aritmetica, nel caso di una distribuzione di dati continua. Come si può notare, queste tre stime non sono molto lontane le une dalle altre. Esiste una relazione empirica che le lega e che è valida per distribuzioni non troppo asimmetriche:

![]()

cioè la differenza tra media aritmetica e moda è circa il triplo della differenza tra media aritmetica e mediana.

Altre stime di tendenza centrale sono la media geometrica definita come![]()

la media armonica, ![]() , e la root mean square, generalmente abbreviata in r.m.s. value, pari a

, e la root mean square, generalmente abbreviata in r.m.s. value, pari a ![]() . Tutte queste stime sono molto meno comuni della media aritmetica, pertanto quando si menziona la media senza aggettivo, è sottinteso che si sta riferendo a quella aritmetica.

. Tutte queste stime sono molto meno comuni della media aritmetica, pertanto quando si menziona la media senza aggettivo, è sottinteso che si sta riferendo a quella aritmetica.

3.4 Stime di dispersione

La media sintetizza un campione di dati in un solo numero. Ciò è ovviamente utile, ma può essere ambiguo. Si consideri, ad esempio, i due istogrammi riportati in figura 3.4. Entrambi hanno una media pari a 7.0, ma la loro distribuzione differisce significativamente. E’ quindi necessario usare un secondo numero per quantificare la loro larghezza o dispersione.

.

La più grossolana delle stime statistiche di dispersione si effettua trovando il massimo ed il minimo valore osservato: la semidispersione massima è definita come la semidifferenza tra questi due valori. Essa ha il difetto di ignorare la maggior parte dei dati e particolarmente quelli, generalmente preponderanti, prossimi al centro della distribuzione. Inoltre, normalmente aumenta all’aumentare del numero di misure invece di tendere ad un valore determinato.

Caratteristiche di una distribuzione di uso frequente nella statistica (anche se non nella fisica) sono i quartili, i decili ed i percentili (collettivamente quantili), indicati con Qi (i = 1,2,3); Di(i= 1,... ,9); e Pi (i=1,... ,99) rispettivamente. Essi sono definiti (analogamente alla mediana) come quei valori della x che dividono la distribuzione rispettivamente in 4, 10 e 100 parti di uguale area. Ovviamente vale la

![]()

Come stima della dispersione di una distribuzione è usato dagli statistici l’intervallo semiinterquartilicoQ = (Q3 — Q1)/2, come pure la differenza P90— P10tra il novantesimo ed il decimo percentile; tali intervalli esistono sempre, ma non sono padroneggiabili agevolmente negli sviluppi teorici.

Altra stima di dispersione è la deviazione media assoluta, definita come

![]()

ma anch’essa non è facile a trattare a ragione dell’operazione non lineare costituita dal valore assoluto.

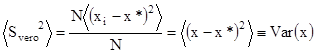

La più importante e più usata, non solo in fisica, stima di dispersione è lo scarto o deviazionequadratica media (s.q.m.)definito come

![]()

Più avanti vedremo che, quando il campione di dati non è grandissimo, una stima più precisa da un punto di vista statistico si ottiene sostituendo a N la differenza N-1 nella formula precedente. Per distribuzioni non troppo asimmetriche la deviazione media assoluta è circa i 4/5 della deviazione quadratica media, mentre l’intervallo semiinterquartilico è circa i 2/3 della stessa.

Se la distribuzione dei dati non è simmetrica, può risultare necessario caratterizzarne la forma usando ulteriori parametri. Questa quantità deve ovviamente tener conto del segno degli scarti. Ovviamente, non può essere il valor medio degli scarti, in quanto esso è nullo per definizione di media. Bisogna quindi passare ai cubi degli scarti e quantificare l’asimmetria della distribuzione mediante lo skew g definito come

![]()

dove il fattore S3 rende g adimensionale e la seconda uguaglianza mostra che per distribuzioni simmetriche g=0. Invece, g>0 implica una coda della distribuzione più accentuata a destra e viceversa per g<0. Per inciso la distribuzione di Gauss, essendo simmetrica, ha g=0 mentre la distribuzione di Maxwell delle velocità molecolari di un gas ha g>0.

Naturalmente, si può procedere oltre nella qualificazione della forma della distribuzione considerando potenze superiori degli scarti. In generale il valor medio della r-sima potenza degli scarti è chiamato l’r-simo momento centrale della distribuzione: il valor medio non è altro che il primo momento centrale della distribuzione e lo s.q.m. il secondo. Nella teoria degli errori si usano quasi esclusivamente la media e lo s.q.m.; tuttavia nella qualificazione di processi fisici (per esempio la distribuzione della penetrazione di particelle monoenergetiche attraverso la materia) possono essere utili e necessari momenti superiori.

3.5 Più di una variabile

In alcuni casi, ciascun dato non consiste di un solo valore ma di due, tre o più. Per esempio, se si vuole determinare la traiettoria di una particella in moto bisogna misurarne la posizione in un dato istante, cosicché i dati sono formati da coppie (x,t). Analogamente, il peso, le abitudini alimentari, il fumare o meno, e l’età, possono costituire le quattro variabili di una ricerca epidemiologica sulla popolazione. Ciò aggiunge un nuovo aspetto alle proprietà dei dati del campione, e si possono investigare le eventuali relazioni tra le diverse grandezze.

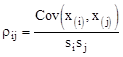

Consideriamo ora il caso in cui un evento è descritto da una coppia di numeri (o di misure) sicché l’insieme dei dati è espresso da {(xl,yl),...,(xN,yN)}. Per ognuna delle due grandezze x e y si possono calcolare la media e lo s.q.m., ma i dati contengono un’informazione supplementare: le due grandezze x e y sono tra loro indipendenti o no? Questo può essere stimato attraverso il calcolo della covarianza che è definita come il valor medio del prodotto degli scarti:

![]()

avendo utilizzato la definizione di valor medio per ottenere l’ultima uguaglianza.

Dalla definizione si può ben immaginare che se uno scarto positivo sulla x tende ad avvenire in concomitanza con uno scarto positivo (negativo) sulla y, e viceversa, la covarianza tenderà ad essere positiva (negativa). Se invece le due grandezze sono totalmente indipendenti, uno scarto positivo di x avrà la stessa probabilità di avvenire in concomitanza con uno scarto positivo o negativo della y, cosicché la covarianza tenderà ad essere nulla.

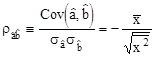

La covarianza è un utile parametro però ha le dimensioni [x][y]. E’ più opportuno definire una quantità adimensionale per rappresentare la stessa proprietà, il coefficiente di correlazione rxy:

![]()

Il coefficiente di correlazione è un numero compreso tra –1 e +1. Se rxy=0 si dice che le variabili x e y sono scorrelate. Una correlazione positiva implica che se x è più grande di ![]() , anche y sarà, in media, più grande di

, anche y sarà, in media, più grande di ![]() . Per rxy<0, un x più grande implicherà un y più piccolo. Se rxy=±1, allora x e y sono totalmente correlate: il valore di una specifica precisamente il valore dell’altra. Il coefficiente di correlazione è ovviamente indipendente da shifts dell’origine degli assi o da cambi di scala per le due variabili. In figura 3.4 sono riportati alcuni esempi grafici di correlazioni tra coppie di valori.

. Per rxy<0, un x più grande implicherà un y più piccolo. Se rxy=±1, allora x e y sono totalmente correlate: il valore di una specifica precisamente il valore dell’altra. Il coefficiente di correlazione è ovviamente indipendente da shifts dell’origine degli assi o da cambi di scala per le due variabili. In figura 3.4 sono riportati alcuni esempi grafici di correlazioni tra coppie di valori.

Il concetto di correlazione può essere facilmente esteso ad eventi di nvariabili che potremo indicare sinteticamente come (x(l),x(2),…, x(n) ). La covarianza tra ogni coppia di variabili è definita analogamente a quanto visto sopra come:

![]()

Le Vijpossono essere pensate come gli elementi di una matrice n x n,la matrice di covarianza, detta anche matrice degli errori. Notate che la matrice è simmetrica e che i suoi elementi diagonali sono gli s.q.m. delle singole variabili. Analogamente, si può definire la matrice di correlazione i cui elementi sono

Naturalmente, gli elementi diagonali della matrice di correlazione valgono tutti +1. Inoltre, si può dimostrare che il valore di r deve essere contenuto entro l’intervallo -1,+1 e che per variabili totalmente correlate (anticorrelate) esso vale +1 (-1).

Per comprendere meglio quanto abbiamo precedentemente accennato sulla variabilità del risultato di una misura, è utile introdurre i concetti di probabilità e, soprattutto, di distribuzione di probabilità. Si illustreranno poi alcune distribuzioni particolari di più frequente uso nelle scienze fisiche, cercando di mostrare come e perché una distribuzione dà origine ai risultati osservati. Solo a partire da questa comprensione è possibile usare il particolare comportamento dei dati per produrre affermazioni generali sui processi primari che li hanno prodotti (le leggi fisiche).

Per cominciare, partiamo da un esperimento in cui l'imperfezione degli strumenti e gli elementi di soggettività della misura non entrano: il lancio di una monetina e il relativo risultato, che non può essere altro che Testa (T) o Croce (C). Se la moneta è perfettamente simmetrica non c'è alcun motivo per privilegiare una faccia o l'altra e lanciando la moneta più volte vi aspettate di ottenere To C in ugual numero. Se si lancia la moneta una sola volta si otterrà l'uno o l'altro dei risultati e la predizione ovviamente non può essere verificata. Ma se viene lanciata due volte, si possono ottenere 1Te 1C, come previsto, ma anche 2To 2C. Cosa c'è che non va nella previsione? In questo caso non è possibile imputare la differenza a imperfezioni strumentali né alla soggettività dell'osservatore. Resterebbe solo il non perfetto controllo delle condizioni sperimentali. In realtà vi è qualcosa di più profondo, che ha a che fare con la natura probabilistica dell’evento. Potremo pertanto affermare che le predizioni di leggi fondamentali vengono modificate (quando le misuriamo) dalle distribuzioni statistiche dei risultati che hanno origine sia nelle imperfezioni degli strumenti, sia dalla

dimensione del campione di dati, sia da altre cause ancora.

4.1 Definizioni di probabilità

Ci sono varie definizioni possibili di probabilità, ciascuna con i propri vantaggi e i propri limiti. Noi ne presenteremo solo due, partendo dalla probabilità assiomatica, formulata originalmente da Kolgomorov.

Sia S={E1, E2,…, EN} un insieme di possibili risultati, o eventi, di un esperimento. Gli eventi si dicono essere mutuamente incompatibili se è impossibile che succedano contemporaneamente in una misura. Per ogni evento E esiste una probabilità P(E), che è un numero reale che soddisfa i seguenti assiomi di probabilità:

Da questi assiomi si possono ricavare tutti i risultati della teoria delle probabilità. Il problema, per uno sperimentatore, è che questi assiomi non hanno alcun significato. Non possiamo sfruttarli per determinare la probabilità di un dato evento. Solo se le varie probabilità sono già note, è possibile usarli per calcolare la probabilità di una qualche complicata combinazione di eventi. Questa è la debolezza della definizione assiomatica, ma è anche la sua forza, in quanto non contiene alcuna ambiguità.

La definizione di probabilità empirica non contraddice quella di Kolmogorov, semplicemente la rende un concetto operativo e misurabile. E’ la definizione “ortodossa” degli sperimentali e quella che useremo più spesso. Supponiamo che un esperimento sia ripetuto, sotto identiche condizioni, N volte e un certo evento A si verifichi in un numero M di questi casi. La probabilità dell’evento A è quindi data da:

![]()

dove il rapporto M/N è chiamato frequenza.

Le N prove possono essere fatte ripetendo lo stesso esperimento N volte in successione oppure facendo misure simultanee su N esperimenti identici. L’insieme di questi casi è chiamato gergalmente ensemble (statistico).

Anche questa definizione non è esente da critiche. Innanzitutto, la probabilità così definita non è una proprietà dell’evento A ma dell’evento e dell’ensemble considerato. Ad esempio, se vogliamo stabilire la probabilità che un lettore di giornale italiano abbia un titolo universitario, usando il campione degli abbonati alla Gazzetta dello Sport troveremo un valore decisamente inferiore rispetto agli abbonati dell’Herald Tribune o di Repubblica. Inoltre, la definizione empirica implica che sia possibile ripetere l’esperimento un numero elevato di volte in condizioni identiche e con diversi risultati possibili. Consideriamo però la frase: “domani probabilmente pioverà”. Cosa significa? C’è un solo domani, si può aspettare e vedere cosa succede, ma ciò può essere fatto solo una volta! Simili considerazioni valgono per il Big Bang, un incontro di calcio, o il Superenalotto. Tuttavia, nonostante questi limiti, la definizione empirica è quella più usata in laboratorio. Tornando all’esempio di prima, se la pressione atmosferica cala, il cielo si rannuvola e le immagini dai satelliti mostrano un fronte freddo in avvicinamento, dire che “domani probabilmente pioverà” è un’affermazione sensata e logicamente corretta.

4.2 Distribuzioni teoriche di probabilità

Per cominciare a introdurre alcuni concetti generali, utili per affrontare i problemi reali, consideriamo ancora un caso semplice anche se probabilmente non è di alcun interesse scientifico: il lancio successivo di 4 monete. Per ciascuna moneta, la probabilità che esca testa (T) è pari a ½, così come la probabilità che esca croce (C). I risultati possibili di questa sequenza di lanci sono 0T, 1T, 2T, 3T o 4Te ovviamente il complemento a 4 per C. Cominciamo a considerare la probabilità di ottenere come risultato 0T. Per la prima moneta questo equivale a considerare la probabilità di ottenere C e quindi essa è 1/2. Lo stesso ragionamento e risultato vale per le altre 3 monete così che la probabilità composta di questo evento, che indicheremo semplicemente col simbolo 0, sarà:

P(0)=1/2´1/2´1/2´1/2=1/16

La probabilità che esca solo una testa, P(1), può essere calcolata secondo la stessa linea di ragionamento. La probabilità che per la prima moneta esca Tè 1/2. Per le altre 3 monete il risultato deve essere allora 3C la cui probabilità composta è 1/8. Quindi la probabilità del risultato TCCCè ancora di 1/2´1/8 = 1/16. Tuttavia, per l’esperimento considerato non interessa quale moneta esce con Te quindi anche le permutazioni CTCC, CCTC e CCCTforniscono lo stesso risultato di una sola testa per sequenza di 4 lanci e ognuna con la stessa probabilità della prima combinazione considerata. La probabilità totale sarà la somma delle probabilità delle singole permutazioni e quindi

P(1)= 4 ´ 1/16 = ¼

Analogamente, la probabilità di ottenere il risultato 2Tsi otterrà sommando le probabilità delle 6 permutazioni (ognuna con probabilità 1/16) che portano allo stesso risultato: TTCC, TCTC, TCCT, CTTC, CTCT, CCTT. Quindi

P(2)= 6 ´ 1/16 = 3/8

La probabilità di ottenere 3To 4T, ovvero P(3) e P(4),è rispettivamente uguale a quella di ottenere 1To OTe quindi P(3) = P(1)e P(4) = P(0). Poiché ogni serie di lanci fornisce comunque un risultato, la somma delle probabilità di ottenere i vari risultati possibili (cioè la probabilità di ottenere

un risultato qualsiasi) deve dare 1 (la certezza) e infatti

P(0)+P(1)+P(2)+P(3)+P(4)=1

Una distribuzione di probabilità è quindi la successione di probabilità associate a tutte le diverse, possibili manifestazioni di uno stesso esperimento (nell’esempio sopra, il lancio di 4 monete). Nota la distribuzione teorica, si possono confrontare le sue predizioni con le misure. Se si lanciano le 4 monete una decina di volte, è quasi certo che i risultati osservati siano simili ma non uguali a quelli previsti. Aumentando il numero di prove, l’accordo tra misura e predizione migliora sensibilmente. Queste considerazioni, di validità generale, si possono sintetizzare dicendo che all’aumentare dell’ensemble le fluttuazioni si eliminano e le frequenze osservate tendono alle probabilità previste. Questo rappresenta un possibile enunciato della fondamentale legge dei grandi numeri.

Nota la distribuzione di probabilità teorica rispetto ad un indice discreto s, arbitrariamente definite come successo, si può determinare immediatamente il numero medio di successi che uno si aspetta di trovare, detto anche valore di aspettazione ed indicato col simbolo ![]() , tramite la relazione

, tramite la relazione

![]()

Considerando l’esempio del lancio di quattro monete, il valore di aspettazione corrispondente al numero di teste che mediamente ci si aspetta di trovare in ogni sequenza di 4 lanci sarà pari a

![]()

Il risultato in questo caso è ovvio, ma la formula sopra riportata fornisce un modo generale per calcolare il valore di aspettazione per una variabile sdella quale si conosce la distribuzione di probabilità P(s). Nell’esempio delle 4 monete, il valore di aspettazione coincide con il valore più probabile, ma non necessariamente è sempre così. Il risultato per spuò essere esteso a qualsiasi funzione di s, f(s), tramite l’espressione

![]()

Per una combinazione lineare di funzioni di s, il valore di aspettazione è la stessa combinazione lineare dei valori di aspettazione delle singole funzioni

![]()

come si può facilmente verificare partendo dalla definizione di valore di aspettazione. Notare che i valori di aspettazione generalmente non si moltiplicano, ossia

![]()

Un modo utile di pensare al valore di aspettazione è in termini di scommesse: supponiamo che ci sia una slot machine con vari possibili risultati etichettati con l’indice s, ciascuno dei quali ha una probabilità P(s) e viene pagato una quantità f(s). Il valore di aspettazione <f(s)> rappresenta quindi la somma che ci si aspetta di vincere in media e sarebbe la quantità giusta da pagare al possessore della macchina per ogni puntata.

C’è un ovvio parallelo tra valore di aspettazione e media di un campione. Il primo è una somma su una distribuzione teorica di probabilità, mentre la seconda è una somma simile ma su un campione di dati reale. La legge dei grandi numeri assicura che se un campione di dati è descritto da una certa distribuzione teorica di probabilità, al tendere ad infinito del numero dell’ensemble, si abbia

![]()

Come per le distribuzioni di dati reali, anche per le distribuzioni statistiche è utile determinarne la larghezza. Questa quantità si chiama varianza ed è definita come

![]()

Per questioni dimensionali, è più utile considerare la cosiddetta deviazione standard pari a

![]()

Tra questa quantità e lo scarto quadratico medio intercorre la stessa relazione che lega ![]() a

a ![]() . Detto esplicitamente, s rappresenta la larghezza di una distribuzione (teorica) di probabilità mentre lo s.q.m. di una distribuzione reale di dati. Per un numero molto grande di dati, la legge dei grandi numeri assicura che lo s.q.m. tende a s.

. Detto esplicitamente, s rappresenta la larghezza di una distribuzione (teorica) di probabilità mentre lo s.q.m. di una distribuzione reale di dati. Per un numero molto grande di dati, la legge dei grandi numeri assicura che lo s.q.m. tende a s.

Il caso trattato finora è quello di una variabile discreta (il numero di risultati "testa" può essere solo un numero intero). Cosa succede se si ha a che fare con una variabile continua? Prima di tutto vediamone un esempio. La lunghezza di un’assicella può essere espressa, a priori, da un

qualsiasi numero reale e quindi è rappresentata da una variabile continua. Supponiamo ora di misurare la lunghezza di un gran numero di assicelle che sono state tagliate a caso tra 20 e 25 cm e di chiederci quante sono lunghe 23 cm. Possiamo cominciare a contare quelle che hanno lunghezza compresa tra 22 e 24 cm: ce ne sarà un certo numero. Tra 22.5 e 23.5 cm ce n'è certamente un numero minore, tra 22.99 e 23.01 potrebbe anche non essercene nessuna. Quello che è certo è che tanto più piccolo è l'intervallo che si considera e tanto meno probabile è trovare un'assicella che vi sia compresa. Se si chiede qual’è la probabilità di trovare un'assicella lunga esattamente 23 cm, questa risulta nulla perché l'intervallo di accettazione è diventato nullo. Tuttavia, la probabilità di trovare delle assicelle in un certo intervallo tra x1e x2è finita ed è descritta dalla distribuzione di densità di probabilità P(x) definita come

![]()

Poiché le probabilità sono numeri puri, le densità di probabilità hanno le dimensioni dell’inverso della variabile (nel nostro esempio l’inverso di una lunghezza). Per quanto riguarda i valori di aspettazione e la varianza valgono gli stessi concetti sviluppati per le variabili discrete, tranne che, ovviamente, le sommatorie sono sostituite da integrali:

![]()

4.3 La distribuzione binomiale

Qualsiasi processo che si concluda con due soli risultati possibili (il lancio della moneta, vero o falso, accettato o rifiutato, guarito o ...., ecc.) è descritto dalla distribuzione binomiale. In generale, si usa descrivere il risultato con i termini di successo e insuccesso senza che questo pregiudichi quale dei due risultati indichiamo con il successo. La probabilità di successo sia pe la probabilità di insuccesso, di conseguenza, sia 1-p.Ripetendo il processo nvolte (nè il numero di tentativi) si otterranno ssuccessi e n-sfallimenti. La distribuzione di probabilità non è altro che una generalizzazione di quanto abbiamo visto nel caso del lancio di 4 monete (infatti in quel caso si trattava di 4 tentativi, o prove, di un processo con due soli risultati possibili: To C).

Per ricavare la distribuzione binomiale basta generalizzare i due fattori che abbiamo considerato per determinare la distribuzione di probabilità relativa al lancio di 4 monete. Il primo è dovuto alle 2npermutazioni di successo e fallimento. Di queste permutazioni dobbiamo però considerare solo quelle che portano a ssuccessi su nprove, che è il numero di modi diversi in cui si può selezionare s da n, ossia ![]() .

.

![]() Il secondo fattore è la probabilità composta, cioè il prodotto delle probabilità individuali, di ottenere successi di probabilità p e n-s insuccessi di probabilità 1-p: ps(1-p)n-s. (La differenza con il caso delle monete è che allora successo e insuccesso, T o C, avevano la stessa probabilità, così che la probabilità composta risultava semplicemente pn con p = 1- p = ½).

Il secondo fattore è la probabilità composta, cioè il prodotto delle probabilità individuali, di ottenere successi di probabilità p e n-s insuccessi di probabilità 1-p: ps(1-p)n-s. (La differenza con il caso delle monete è che allora successo e insuccesso, T o C, avevano la stessa probabilità, così che la probabilità composta risultava semplicemente pn con p = 1- p = ½).

La distribuzione binomiale di probabilità, cioè la probabilità di ottenere ssuccessi, ciascuno con probabilità p, su nprove è quindi data da

![]()

Normalmente si è interessati a come la probabilità Pvaria con s, per p e n fissati. Tuttavia, siccome tale probabilità dipende sia da p che da n,abbiamo indicato esplicitamente tale dipendenza, separandola da s con un punto e virgola. In altri termini, si considera s come variabile e p ed n come parametri della funzione.

Si dimostra facilmente che il valore di aspettazione della distribuzione binomiale è pari a

![]()

e che la sua varianza è uguale a

![]()

Per ricavare quest’ultimo risultato è conveniente partire dal calcolo dell’espressione

![]()

I primi due termini della sommatoria sono nulli e, raccogliendo il fattore n(n-1)p2, la sommatoria residua si riduce allo sviluppo binomiale [p+(1-p)]n-2 = 1. Quindi ![]() e ricordando quanto vale

e ricordando quanto vale ![]() si arriva facilmente alla formula sopra riportata.

si arriva facilmente alla formula sopra riportata.

La figura 4.1 mostra alcuni esempi di distribuzioni binomiali. Le curve sono piccate in prossimità di np, come ci si aspetta. All’aumentare di n, il picco, relativamente all’intervallo completo di n, diventa progressivamente più stretto, sebbene abbastanza lentamente. La larghezza relativa del picco dipende inoltre da p e, a parità di n, picchi con p vicina a 0 o 1 sono più stretti di quelli con p prossima a 0.5, in accordo con l’espressione della varianza appena calcolata.

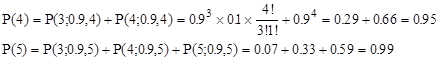

Dal momento che lanciare monetine, curare gli ammalati o fare un controllo di processo (prodotto accettato o rifiutato) ha abbastanza poco a che fare con le scienze esatte, che senso ha studiare la distribuzione binomiale? Ebbene, anche nelle scienze esatte esistono fenomeni che possono essere descritti dalla distribuzione binomiale: per esempio tutti i processi che avvengono oppure no come la rivelazione di una particella. Supponiamo, per esempio, di fare un esperimento in cui si voglia misurare le tracce (cioè le traiettorie) di particelle elementari (per esempio nello studio dei raggi cosmici). Assumiamo ragionevolmente che per misurare una traccia siano necessari almeno tre punti e decidiamo di usare come rivelatori delle camere a scintilla la cui efficienza è stata misurata essere il 90%, cioè la probabilità che una particella sia rivelata nel suo attraversamento della camera è 0.90. Per rivelare una traccia si deve usare un insieme di almeno 3 camere. Quanto efficiente è il vostro sistema? La risposta è semplice: P(3;0.9,3) = 0.93 = 0.729, cioè si ha un'efficienza inferiore al 73%. Volendo aumentare l'efficienza, serve o no aumentare il numero delle camere? La risposta è sì. Infatti con 4 o 5 camere si ottiene rispettivamente

Si può apprezzare l’utilità di simili stime pensando, per esempio, di aver deciso (contrariamente a quanto fatto prima) che una buona misura di una traccia richieda la determinazione di almeno 4 punti. In questo caso il numero minimo di camere è 4 e la loro efficienza complessiva è solo il 66% (il secondo termine della prima stima precedente). Aggiungere una quinta camera porta l'efficienza complessiva al 92% (il risultato della seconda stima precedente meno il primo termine) con un aumento di circa una volta e mezzo!

4.4 La distribuzione di Poisson

La distribuzione binomiale descrive casi dove degli eventi discreti avvengono in un preciso numero di eventi. La distribuzione di Poisson descrive invece processi in cui si hanno ancora risultati particolari, ma senza avere un'idea del numero di tentativi. Si tratta di eventi improvvisi ma che avvengono in un continuo. Per esempio, durante un temporale ci sarà un numero definito di lampi, ma ovviamente non ha alcun senso chiedersi quanto frequentemente non c’è un lampo. Analogamente, un contatore Geiger posto in prossimità di una sorgente radioattiva produrrà precisi segnali quando colpito da particelle, ma non precisi non-segnali.

Supponiamo che in tale esperimento si determina che il numero medio di eventi (conteggi) in un certo intervallo di tempo è un certo numero (per esempio 10 al minuto). Quindi, ci aspettiamo che in media ci saranno 10 conteggi al minuto, sebbene 9 o 11 possono comunque verificarsi. Se però ne osserviamo 15 o 3 al minuto, queste rilevazioni sono comunque compatibili con la statistica o qualcosa è cambiato durante il corso delle misure? Cioè fino a che punto la distribuzione statistica è verosimilmente la causa delle deviazioni dei risultati dal valor medio? La risposta va cercata determinando la probabilità di ottenere un particolar numero di eventi quando è noto il loro numero medio. Questo può esser fatto considerando il limite della distribuzione binomiale (rivelazione sì, rivelazione no) per n,il numero di tentativi, che diviene molto grande ma con una probabilità p che al tempo stesso diviene molto piccola. così che il numero medio (il valore di aspettazione np) rimane costante e finito.

Supponiamo di sapere che il numero medio di eventi in certo intervallo di tempo sia l. Dividiamo l'intervallo in questione in un numero di parti ncosì grande che sia trascurabile la probabilità che in uno di questi sotto-intervalli si verifichino 2 o più eventi. La probabilità che in uno di questi sotto-intervalli si verifichi un evento sarà allora p=l/n. Utilizzando la distribuzione binomiale possiamo allora calcolare la probabilità che nell'intervallo originario si verifichino seventi

![]()

In realtà la distribuzione di probabilità che cerchiamo è quella che si ottiene dalla binomiale al limite per nche tende ad infinito mentre l ed s rimangono finiti. Per quanto riguarda il terzo fattore osserviamo che n!/(n-s)!=n(n-1)(n-2)…(n-s+1). Questo è un prodotto di stermini, così che per n che tende ad infinito esso tende a nsche si semplifica con l'analogo termine del primo fattore. D'altra parte, per il secondo fattore, si ha

![]()

dove l’ultimo passaggio segue dalla definizione di esponenziale.

In definitiva, la distribuzione di Poisson, ossia la probabilità di ottenere s eventi se il numero medio è l, risulta essere:

![]()

che dipende da un solo parametro, il numero medio di eventi in un dato intervallo.

Le principali proprietà della poissoniana sono:

![]()

Le prime due sono ovvie, mentre l’ultima è sicuramente la cosa più importante da ricordare. La distribuzione di Poisson è sempre più larga di quella binomiale avente la stessa media. Ciò è comprensibile considerando che in una binomiale, il numero di successi è limitato superiormente (s£n) mentre nella poissoniana tale limite non esiste e quindi può avere una lunga coda.

In figura 4.2 sono riportati alcuni esempi di distribuzioni di Poisson. Quando l<1, il risultato più probabile è 0. Per valori più grandi, si sviluppa un picco che però è leggermente inferiore a l, cioè l rappresenta il valore di aspettazione (media) ma non la moda della distribuzione. Infatti, la formula mostra che per l intero, s=l e s=l-1 hanno la stessa probabilità.

Un’altra utile proprietà della distribuzione di Poisson è che la somma di due processi, aventi distribuzione individuale di Poisson, ha una distribuzione che è ancora di Poisson con valor medio pari alla somma dei rispettivi valori medi. Per esempio, la sorgente radioattiva, di cui abbiamo parlato all’inizio, può essere costituita da due radionuclidi, a e b, ognuno dei quali causerebbe individualmente il conteggio medio rispettivo la e lb. Poiché il contatore Geiger non distingue tra i conteggi dovuti ai due radionuclidi, quando si registrano sconteggi essi sono la somma di sa e di sb conteggi, rispettivamente. Ebbene, si può dimostrare che la distribuzione che descrive queste misure è una poissoniana con l = la + lb.

Infine, la distribuzione di Poisson è un’utile approssimazione della distribuzione binomiale se il numero delle prove n è abbastanza grande e/o la probabilità abbastanza piccola. Il vantaggio di usare la Poisson al posto della binomiale sta nel fatto di non dover calcolare noiosi fattoriali che diventano una bella impresa se il numero delle prove e degli eventi supera la decina! Naturalmente abbastanza grande e piccolo non è una definizione precisa e varia molto con il grado di precisione richiesto per il risultato.

4.5 La distribuzione di Gauss

Anche se il valor medio delle distribuzioni precedenti può essere un numero qualsiasi, gli eventi descritti sono discreti e quindi la variabile che li rappresenta, s,è discreta. Ci sono però eventi che sono descritti da variabili continue: per esempio il risultato della misura di una lunghezza può essere un numero qualsiasi, almeno idealmente, cioè prescindendo dagli errori di misura e dalla sensibilità degli strumenti.

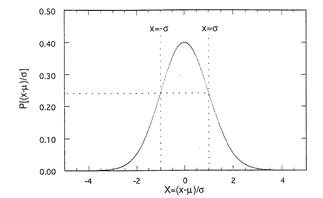

Tra le distribuzioni di probabilità di variabile continua la più famosa e utile è la distribuzione di Gauss. Questa è una curva a forma di campana, centrata e simmetrica rispetto al valore x=m e la cui larghezza è determinata dal parametro s. La sua espressione matematica è

![]()

Anche in questo caso, oltre alla variabile continua x che rappresenta l’evento, abbiamo messo in evidenza i parametri da cui dipende la forma della distribuzione. Variare il valor medio mfa traslare la curva lungo l’asse delle ascisse senza variarne la forma. Variare s, invece, allarga o restringe la curva in proporzione, ma senza farla traslare. In questo modo, tutte le curve gaussiane sono tra loro equivalenti, in quanto un cambio di origine e/o un cambio di scala le riduce alla forma standard,

![]()

riportata in figura

Figura 4.3 Distribuzione di Gauss unitaria.

Le proprietà principali della distribuzione di Gauss sono:

![]()

In altre parole, la gaussiana è normalizzata ad 1, il suo valore di aspettazione coincide col parametro m, che è anche uguale alla media ed alla moda, e la larghezza è proporzionale a s2, che giustifica a posteriori l’uso di questo simbolo da noi impiegato per identificare la deviazione standard di una distribuzione. Spesso, da un punto di vista sperimentale, cioè nello studio di processi governati da una distribuzione gaussiana, è più comodo misurare la larghezza della distribuzione a mezza altezza FWHW (FWHM è l’acronimo dell’inglese Full-Width-at-Half-Maximum). Si mostra facilmente che l’ascissa per cui la gaussiana assume un valore pari a metà del suo massimo è

![]()

quindi

![]()

Tutti i risultati precedenti si dimostrano a partire dai seguenti integrali notevoli

![]()

La probabilità che un evento cada nell’intervallo [x1,x2] è data dall’integrale ![]() . Sfortunatamente, questo tipo di integrale non può essere risolto analiticamente ed è necessario ricorrere al calcolo numerico o all’uso di tabelle che si trovano in ogni buon manuale di tabelle matematiche. In ogni caso, è bene ricordare che la probabilità che un evento cada entro l’intorno del valor medio pari a :

. Sfortunatamente, questo tipo di integrale non può essere risolto analiticamente ed è necessario ricorrere al calcolo numerico o all’uso di tabelle che si trovano in ogni buon manuale di tabelle matematiche. In ogni caso, è bene ricordare che la probabilità che un evento cada entro l’intorno del valor medio pari a :

Per quanto la probabilità di un evento diventi nulla solo a distanza infinita dal valor medio, essa si riduce a valori che possono essere trascurabili già a poche volte s. Per questo motivo viene di solito assunto che per una distribuzione gaussiana il massimo valore dello scarto sia 3s. Infatti la probabilità di uno scarto superiore a questo valore è solo 0.3% ed in teoria è possibile avere almeno un evento di questo tipo solo se il numero di prove è superiore ad alcune centinaia, cosa che raramente avviene nelle situazioni reali.

Dalla figura 4.2 si può notare che per lgrande, la distribuzione di Poisson ha una forma approssimativamente gaussiana. In tal caso, una conveniente approssimazione della poissoniana è la gaussiana con m=l e ![]() . Di fatto, usando l’approssimazione di Stirling per il logaritmo di s!,si può dimostrare che la poissoniana tende alla gaussiana per grandi valori di l. Quanto grandi dipende ovviamente dalla precisione richiesta, ma possiamo dire che al di sopra di 10 l’approssimazione è ragionevole. Poiché la distribuzione binomiale approssima la poissoniana per ngrande, anch’essa approssima una gaussiana con m = npe

. Di fatto, usando l’approssimazione di Stirling per il logaritmo di s!,si può dimostrare che la poissoniana tende alla gaussiana per grandi valori di l. Quanto grandi dipende ovviamente dalla precisione richiesta, ma possiamo dire che al di sopra di 10 l’approssimazione è ragionevole. Poiché la distribuzione binomiale approssima la poissoniana per ngrande, anch’essa approssima una gaussiana con m = npe ![]() . Il valore di nnecessario dipende da p: per p=0.5 questo avviene prima, mentre per valori grandi o piccoli di p si richiedono valori di nmaggiori.

. Il valore di nnecessario dipende da p: per p=0.5 questo avviene prima, mentre per valori grandi o piccoli di p si richiedono valori di nmaggiori.

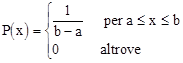

4.6 La distribuzione uniforme

Concludiamo questo capitolo menzionando la distribuzione di probabilità per variabili continue più semplice, ossia quella uniforme. Descrive una probabilità costante in un certo intervallo e zero all’infuori di esso. Poiché la probabilità totale espressa dall’integrale della distribuzione, cioè l’area racchiusa dalla curva, deve essere unitaria, l’altezza della distribuzione deve essere P(x)=1/(b-a), se a e b indicano i limiti dell’intervallo dove la probabilità è uniforme. Pertanto, la distribuzione uniforme può essere descritta dalle formule:

Proprietà di questa distribuzione sono: ![]() .

.

Riassumendo quando detto finora, le distribuzioni statistiche danno origine alla variabilità dei risultati osservati. Il valore di aspettazione di una qualsiasi funzione del risultato può essere calcolato se è nota la distribuzione. D’altra parte, si è visto che se si usa un numero finito di prove, il risultato può differire dal valore di aspettazione perché solo per N che tende ad infinito le frequenze approssimano le probabilità. Il problema dell’applicazione della teoria statistica alla teoria della misura e degli errori di misura è proprio questo. In generale, non si conosce la distribuzione (sia il tipodi distribuzione che i parametri che la caratterizzano) ma si vogliono dare delle ragionevoli stime dei valori di aspettazione a partire da un numero finito di dati. Il capitolo che segue tratta proprio delle tecniche per stimare i parametri che caratterizzano la distribuzione gaussiana.

Fare degli esperimenti significa eseguire delle misure, che vengono quindi analizzate per produrre dei risultati scientifici. Tali misure, che siano fatte da voi o dal sottoscritto o da un premio Nobel, non sono mai perfettamente esatte, ma sono affette da errori o imprecisioni. In questo capitolo, affronteremo come si possono maneggiare e stimare gli errori di tipo casuale e come gli errori sulle misure si combinano e si propagano agli errori sui risultati.

5.1 Perché gli errori casuali sono gaussiani?

Abbiamo già visto che gli errori di tipo casuale sono dovuti a tantissime cause diverse, il cui controllo, molto spesso, è difficile da realizzare. Ora, in statistica esiste un potente risultato che riguarda il comportamento di una variabile somma di moltissime altre, il cosiddetto

Teorema del Limite Centrale:

Se X è la somma di N variabili indipendenti xi, dove i=1,2…N, ognuna derivante

da una distribuzione di media mi e di dispersione si, allora la distribuzione di X

Quest’ultima proprietà, in particolare, è il motivo per cui la gaussiana è così importante. Una qualsiasi grandezza prodotta dall’effetto cumulativo di molte variabili indipendenti sarà, almeno in prima approssimazione, di tipo gaussiano, indipendentemente dalle distribuzioni descriventi le variabili di partenza. Gli errori casuali sono pertanto variabili gaussiane, così come molte altre quantità. Per esempio, anche l’altezza degli uomini o la lunghezza dei piedi, sono descritte da una distribuzione gaussiana, perché dovuti agli effetti combinati di moltissimi fattori genetici ed ambientali. Viceversa, il peso degli essere umani non è gaussiano ma ha una skew positiva, poiché una singola variabile, quanto uno mangia, domina su tutte le altre.

Osserviamo che moltissime distribuzioni sono indistinguibili da una gaussiana entro distanze di uno o due s dal loro picco, ma deviano sensibilmente in regioni più lontane. Questo zone sono chiamate code o ali, e la loro precisa analisi richiede tecniche molto sofisticate.

La prova dei primi due punti del TLC è molto semplice. Il primo punto è legato alle proprietà di linearità del valore di aspettazione:

![]()

Per quanto riguarda la dispersione della variabile somma, è opportuno partire da

Gli elementi dell’ultima somma sono le covarianze tra coppie di variabili diverse, ma per ipotesi queste sono tra loro indipendenti, quindi ciascun termine è nullo. Ne consegue che

![]()

La dimostrazione del terzo e più importante punto del TLC è abbastanza complicata e verrà tralasciata. Ci limiteremo a giustificarlo per via grafica, rifacendoci ai diagrammi di figura 5.1.

In figura 5.1A è riportato l’istogramma, con intervalli di 0.05, dei risultati dell’estrazione casuale di 1000 numeri compresi tra 0 e 1 con probabilità uniforme. Come ci si poteva aspettare, l’istogramma definisce una distribuzione circa piatta di altezza pari al valor medio di 50 dato dal rapporto tra 1000, i numeri estratti, e20, gli intervalli, cioè 1/0.05. Il valor medio è circa pari al valore di aspettazione 0.5. Le oscillazioni di altezza tra le varie caselle sono legate alle fluttuazioni statistiche dovute al numero finito di numeri estratti.

Le figure 5.1B, C, D sono l’analoga rappresentazione della somma di 2, 3 e 12 numeri estratti nello stesso modo. Potete vedere che la distribuzione si modifica mostrando un picco ben definito attorno al valore di aspettazione m = m1 + m2 +…= 0.5n, dove nè il numero dei numeri che vengono sommati (n = 2, 3, 12 e m = 1, 1.5, 6). Inoltre la distribuzione che è approssimativamente piatta (rettangolare) per n= 1, diviene triangolare per n= 2 e assomiglia ad una gaussiana per n = 12. Di fatto, se consideriamo la varianza, per la singola distribuzione essa vale 1/12, usando i risultati validi per una distribuzione uniforme, e, in base al TLC, per la somma di 12 numeri essa vale 12x1/12=1. La linea continua in figura 5.1D è proprio il calcolo della distribuzione di Gauss con m = 6 e s = 1. Si può notare che la somma di 12 variabili con distribuzione uniforme (cioè estremamente diversa dalla distribuzione gaussiana) è ottimamente rappresentata da una gaussiana con parametri determinati in base al TLC!

5.2 Lavorare con gli errori casuali

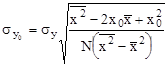

Abbiamo visto che tutte le misure sono affette da errori. Nel caso di errori di tipo casuale, il modo più semplice per controllarne e ridurne gli effetti consiste nel ripetere la stessa misura un numero di volte il più elevato possibile. In tal caso, possiamo applicare il TLC in modo semplice in quanto tutti i mi avranno lo stesso valore, indicato con m, e tutte le dispersioni si saranno uguali a s. La prima proprietà del TLC implica che ![]() , ed in termini di media

, ed in termini di media ![]() si ricava il risultato

si ricava il risultato ![]() . Se consideriamo la dispersione della media, avremo

. Se consideriamo la dispersione della media, avremo

Assumendo che tutte le misure siano tra loro indipendenti, il secondo punto del TLC comporta ![]() . Ne deriva che

. Ne deriva che

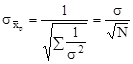

![]()

Cerchiamo di chiarire quanto abbiamo appena dimostrato. Innanzi tutto, cosa significa ![]() , ossia il valore di aspettazione di una media? Prese N misure, x1, x2,…, xN, si può calcolarne la media aritmetica. Il risultato è ovviamente