1.- Modelli Normativi e Politica Economica.

L’economia politica tratta fenomeni economici nel loro contenuto positivo (spiega i fenomeni), la politica economica invece tratta i fenomeni nel loro contenuto normativo (spiega le norme di comportamento). Nel caso dell’economia politica, quindi, si mira allo studio di ciò che è, mentre nel caso della politica economica, si misura allo studio di ciò che dovrebbe essere. Secondo la definizione classica di Robbins (o Bentman), definiamo politica economica l’insieme dei principi dell’azione (agenda) o dell’innovazione (non agenda) del governo rispetto all’attività economica. Secondo la definizione moderna di Caffè, invece definiamo politica economica quella disciplina che ricerca le regole di condotta tendenti ad influire sui fenomeni economici per orientarli nel senso desiderato.

Gli elementi costitutivi di un problema di politica economica son: il modello economico di riferimento e l’indicazione dell’obiettivo da conseguire. Quando si utilizza il modello economico di riferimento per spiegazioni analitiche (economia politica), si devono supporre come noti tutti gli elementi esterni (prelievo fiscale, tassi di interesse etc) e i comportamenti dei soggetti economici. In questo caso il modello viene risolto individuando gli aspetti fondamentali del sistema (reddito complessivo, occupazione etc). Per i fini di politica economica invece queste grandezze vengono considerate come obiettivi. Gli obiettivi di politica economica possono essere: Fissi e Flessibili.

Gli obiettivi fissi vengono trasmessi al policy maker tramite l’individuazione di un'unica alternativa da realizzare. Gli obiettivi flessibili prevedono invece l’indicazione di una funzione obiettivo che informi il policy maker delle preferenze del decisore (Timbergen). L’obiettivo fisso si concretizza sempre con l’indicazione di un valore da realizzare, mentre quello flessibile prevede l’esplicitazione di una funzione di preferenza che può essere una funzione da massimizzazione o minimizzazione.

OBIETTIVI FISSI E FLESSIBILI: IN UN INSIEME DI ALTERNATIVE POSSIBILI.

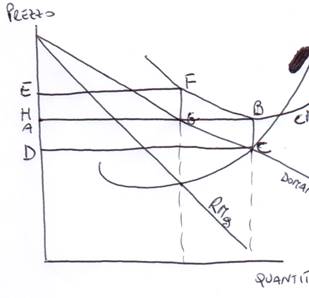

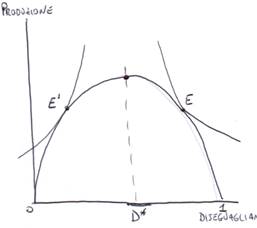

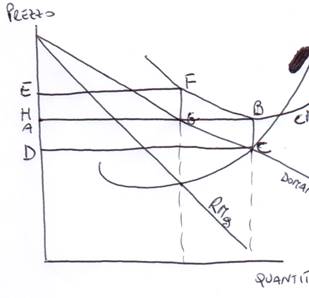

Supponiamo vi sia una frontiera delle possibilità produttive (curva di trasformazione) cc’ e due beni: A e B. il decisore esprimerà un obiettivo fisso scegliendo ad es. “E”. Se invece il decisore esprime una funzione continua di preferenze rappresentata tramite una famiglia di curve di indifferenza, allora il policy maker massimizzerà w (scegliendo E). Ma di fronte ad un progresso tecnologico che sposta verso Dx la FPP in DD’, il policy maker che ha ricevuto un obiettivo fisso non potrà mutare la soluzione E finchè non riceve una nuova preferenza dal decisore, anche se il vecchio programma è inefficiente. Il policy maker che ha ricevuto un obiettivo flessibile invece potrà passare alla soluzione P evitando inefficienze.

Le preferenze indicate dal decisore al policy maker sono un contratto il quale può essere completo o incompleto. I contratti completi sono quelli in cui è possibile specificare ogni possibile circostanza, mentre i contratti incompleti sono quelli in cui non è possibile prevedere tutte le circostanze che potrebbero emergere. Quando si imposta un problema di politica economica, si imposta un’impostazione ideologica che il politico fa propria. In questo caso si parla di ideologia esterna (nasce dal modello di riferimento). Nella politica economica agisce un altro importante condizionamento ideologico: la scelta dell’obiettivo, è poiché nasce direttamente dalla formazione del modello, viene chiamata ideologia interna.

La razionalità sostanziale è la razionalità classica della scienza economica per cui i risultati di una scelta discendono solo dalla funzione di preferenza dell’agente e dall’insieme dei vincoli che descrivono l’ambiente esterno. Ma nella realtà l’agente possiede informazioni limitate sulle alternative disponibili e risulta quasi impossibile supporre che conosca i risultati delle singole alternative. Inoltre non vi è alcuna evidenza empirica che di fronte a problemi di difficile soluzione l’individuo abbia le capacità adeguate. Di conseguenza, la teoria della razionalità sostanziale deve essere sostituita con la teoria della razionalità limitata, la quale tiene conto delle limitate capacità cognitive e di calcolo del decisor. Secondo questa teoria gli agenti economici sono incapaci di realizzare scelte ottime quando esse possiedono elevati livelli i complessità.

Nella realtà il movimento della razionalità limitata verso quella sostanziale è solo tendenziale, quindi occorre sviluppare un concetto che illustri l’interazione tra il decisore e i vincoli: la razionalità procedurale (Simon), cioè l’abilità nel trovare un comportamento adeguato per adattarsi all’ambiente esterno. Con questo concetto si sposta l’attenzione dalla capacità di scelta al processo di scelta, il quale non viene più assunto come un dato, ma è oggetto di ricerca. Nel processo di soluzione di un problema di politica economica intervengono due soggetti: il decisore pubblico (comitato), che detta gli obiettivi e seleziona il modello economico interpretativo, il policy maker che diviene il responsabile del modello di politica economica che gli è stato trasmesso (verifica la controllabilità del modello cioè se vi è almeno una soluzione). Tuttavia è opportuno inserire un terzo soggetto: il policy adviser. Quest’ultimo è interno come l’esperto capace di risolvere il modello (attenendo un programma unico se vi è una sola soluzione e un programma con più appendici se ve ne sono più di una).

La razionalità procedurale ha introdotto nell’economia le possibilità che i soggetti abbandonino l’approccio Optimizing per assumere comportamenti diversi: l’ottimizzazione approssimata e l’alternativa soddisfacente. La prima procedura consiste nell’introduzione di semplificazioni essenziali della situazione indicata dal modello. La seconda procedura, invece, comporta un cambiamento radicale del tipo di obiettivo: l’approccio optimizing viene sostituito con quello samsficing. In altri termini, ad un soggetto che ottimizza si sostituisce un soggetto che si accontenta.

In condizioni particolari, alcuni economisti si ispirano a semplici regole empiriche, cioè può essere accettabile quando il decisore si trova ad affrontare situazioni di routine che già conosce e che tendono a ripetersi. I comportamenti soddisfacenti e le regole empiriche sono ipotesi interessanti per spiegare molti aspetti dei programmi di politica economica e molte procedure di decentramento. Tuttavia essi non sono motivo sufficiente per abbandonare i modelli di razionalità che si esprimono per obiettivi fissi e flessibili. Le regole empiriche inoltre, riconducendosi a comportamenti di routine, divengono elementi di rigidità della politica economica. La risposta del programma infatti resta immutata di fronte a piccole alterazioni della realtà. Questo comportamento di rigidità può essere spiegato ricorrendo all’ipotesi di Quasi - Razionalità di Akerlof, basata sull’idea che un programma, sotto certe condizioni di condizioni di continuità della funzione obiettivo, possa deviare dall’ottimalità senza incontrare gravi perdite. Un comportamento non ottimizzante del policy maker può allora essere giustificato dall’accettazione di una piccola perdita che però consente di evitare i costi del ricalcolo del programma (Near Rationality).

IL COSTO DI UN COMPORTAMENTO QUASI RAZIONALE PER L’IMPRESA E PER LA SOCIETà

Supponiamo che il monopolio di tabacchi stimi la seguente funzione di domanda inversa P= a – bq. Uguagliando il Mr= a – 2bq al Mc= c, si ottiene la produzione ottimale di razionalità sostanziale Q0= (a – c) / 2b. Se interviene uno shock positivo di produttività che riduce il costo marginale del monopolio di una percentuale k Ɛ (0,1), abbiamo una nuova curva di costo c’= c(1-k). Il monopolista dovrebbe allora impostare un altro programma con soluzione Q1= (a – c’) / 2b. Il policy maker potrebbe preferire una soluzione quasi razionale per evitare i costi di configurazione e gestire di un nuovo programma. In questo caso egli conferma il vecchio programma di formazione Q0. Ciò comporta una minore produzione rispetto a quella ottimale pari a q1 – q0= ck/2b=h(k). Cosi facendo il monopolista incorre in una perdita di profitto che è pari all’area del triangolo g= jh, che è h(k) k/2. Il valore della perdita è gjk= c2k2/4b, in quanto l’abbandono di un comportamento razionale costa al monopolista una somma proporzionale ad un valore che dipende dal quadrato dello shock.

Se il comitato esprime una visione positiva del mando, nel programmare il proprio intervento cercherà di assumere il modello economico interpretativo che ritiene superiore a tutti gli altri in termini di verità. Tuttavia anche se il modello selezionato è superiore, non vi può essere certezza che non sia falso e che quindi non contempla errori. Per capire se nel caso in cui il modello risulti nel futuro errato come si modifica, a parità di obiettivo, il relativo programma di politica economica, dobbiamo analizzare la robustezza della politica economica. Naturalmente la visione positiva della scienza economica tende a provole giare i programmi robusti poiché non richiedono una modifica dei disegni di intervento anche se il modello in futuro si dimostrerà sbagliato.

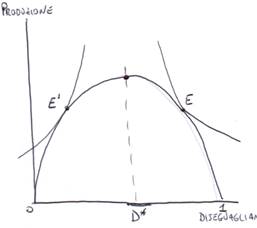

LA ROBUSTEZZA DEL PROGRAMMA DI POLITICA ECONOMICA.

Assumiamo che una funzione di trasformazione (fpp) sia stimata come modello lineare (produttività marginale costanti), ma che questa stima si dimostri errata, assumendo una configurazione concava rispetto all’origine (produttività marginale decrescenti). Se il modello presenta un obiettivo fisso di piena occupazione E, allora il relativo programma è robusto. Ciò invece non accade per obiettivi diversi (e’, e’’). Infatti la soluzione e’ è un programma debole poiché richiede risorse che non sono disponibili, mentre la soluzione e’’ è debole poiché fallisce il requisito della piena occupazione.

Tra i modelli riguardanti i ruoli dell’imprenditore, i più importanti sono: il modello di Walras. Per Walras l’arte di farsi imprenditore deve essere riconnessa alle capacità di coordinare l’attività produttiva (formazione professionale); il modello di Knight l’arte di farsi imprenditore è da intendere come propensione della persona al rischio (migliorare il sistema informativo); il modello di Schumpeter l’arte di farsi imprenditore è nella capacità di creare (migliorare l’ambiente socio – economico); il modello di Kalecki la costituzione di una impresa è un’attività limitata dalla disponibilità di capitale proprio (migliorare il settore creditizio).

Per individuare gli obiettivi, un decisore deve selezionare azioni che conducono a situazioni diverse. Ad ogni situazione diamo il nome di stato del mondo. Quale situazione sia da considerare migliore, dipende da una valutazione sociale dei diversi stati del mondo e da questa quindi dipenderà il programma di politica economica del policy maker che deve distribuire i diritti di proprietà. Per la determinazione dell’obiettivo è necessario quindi introdurre un ordinamento sociale che fornisca una graduatoria dei diversi stati del mondo. Questa graduatoria può essere espressa tramite una lista che definisce la classifica dallo stato preferito a quello peggiore, oppure può essere espressa tramite una funzione che attribuisce ad ogni stato del mondo un valore definito nel campo dei numeri reali. Definita la graduatoria, se l’obiettivo è fisso sarà comunicato al policy maker, mentre se è flessibile il decisore comunicherà la funzione di benessere sociale. Il primo problema della politica economica è quello di determinare tale ordinamento, il quale può essere: Diretto, se la graduatoria degli stati del mondo è introdotta dall’estero; Indiretto, se la graduatoria è riferita esclusivamente alle preferenze degli individui. Se la società si organizza con un ordinamento diretto, le preferenze e gli obiettivi sono indicati da parte di elites. L’elitarismo implica che il potere pubblico non è stato pensabile alla richiesta del popolo quanto lo è verso gli interessi dell’elite. Se la società si organizza secondo i principi dell’ordinamento indiretto, bisogna aggregare le preferenze individuali. L’obiettivo del modello normativo viene poi trasmesso al policy maker tramite il funzionamento di istituzioni democratiche come i parlamentari e governatori etc.

AGREGAZIONE DELLE PREFERENZE DEGLI INTERESSI DEI GRUPPI E LE SOLUZIONI DI COMPROMESSO.

Supponiamo vi sia una società che sia chiamata ad esprimersi sui fini di un intervento ambientale. In essa vi sono due gruppi: gli inquinanti A i quali hanno interesse che il risanamento sia pagato tramite imposte; gli inquinanti B i quali chiedono una politica di risanamento ambientale finanziata con il principio paga chi inquina. Il policy maker dovrà assumere un obiettivo ci compromesso s, se le 2 forze si equivalgono o dovrà spostarsi verso quella che ha maggior peso relativo (s’). Tranne nel caso in cui il potere politico di un gruppo o persone sia tale da far coincidere l’obiettivo con le proprie preferenze in tutti gli altri casi l’ideologia interna sembra occuparsi dall’individuazione dell’obiettivo di politica economica.

2.- Le scelte pubbliche: la teoria delle votazioni.

Le scelte pubbliche nelle società democratiche si formano in organismi collegiali (comitati) composti dagli individui su cui l’esito delle scelte ricade (democrazia diretta) o da loro rappresentanti (democrazia indiretta). Un comitato è quindi un gruppo di persone che perviene ad una scelta tra più alternative tramite il voto. Quest’ultimo indica l’insieme delle procedure attraverso le quali si può pervenire ad una decisione. Le mozioni (proposte di azioni) vengono sottoposte al comitato stesso affinché le approvi o le respinge con una votazione. Possono essere seguite due modalità di votazione: votazione Multipla, in cui le alternative vengono votate simultaneamente secondo criteri che consentono di pesare ciascuna preferenza; e votazione Binaria, in cui le alternative vengono votate in coppia, scindendo il problema dei vari confronti. Una votazione multipla può essere condotta con almeno due procedure: Indicazione della sola Mozione preferita, ma che presenta la debolezza di fornire un risultato che tiene conto solo delle preferenze di primo livello trascurando le altre; e la Regola di Borda, con la quale si assegna un punteggio da attribuire ad ogni mozione e risulta vincente l’alternativa che raccoglie il punteggio maggiore. Tale metodo, però impone di misurare con un numero cardinale le preferenze ordinali, producendo cosi un risultato che potrebbe essere diverso a seconda del punteggio assegnato i vari posti della graduatoria. Per superare queste critiche della votazione multipla, si ricorre alla procedura binaria che, seguendo il criterio di Condorcet, scompone il confronto tra gli insieme in coppie e sceglie quella che sconfigge tutte le altre. Adottando questo criterio si aprono due alternative: Procedura completa o di Tàtonnement, in cui vengono confrontate tutte le possibili coppie; e procedura Ordinaria, in cui c’è un processo a eliminazione successiva. Si parte da una data coppia di alternative e la coppia vincente si confronterà con una delle escluse e così via. La scelta della procedura non è neutrale rispetto all’esito finale della delibera. Inoltre la procedura è da mettere in relazione anche con la scelta degli obiettivi fissi o flessibili: la procedura multipla con il criterio di Borda o quella Binaria completa sono condizione necessarie per gli obiettivi flessibili, mentre la procedura dell’alternativa migliore o quella Binaria ordinaria sono solo condizioni sufficienti per gli obiettivi fissi.

La regola dell’unanimità comporta che la selezione di una mozione avvenga soltanto se tutti i soggetti la preferiscono all’altra. L’unanimità in senso Pieno comporta che venga approvata la mozione se e solo se tutti gli agenti del comitato sono d’accordo nel preferirle (d1=d2=…..dn=1). In una versione meno stringente dell’unanimità l’iter è approvato se nessun agente vota contro (l’astensione e considerata come voto favorevole). La regola della Maggioranza comporta che una collettività di persone seleziona un obiettivo soltanto se la maggior parte dei soggetti la preferisce all’altro. La maggioranza Semplice è definita tramite la somma algebrica delle preferenza (x=1;y=-1). Se questa somma è positiva, X sarà preferita ad Y, se negativa Y sarà preferita a X. Una diversa regola della maggioranza è quella della maggioranza Assoluta. A tal fine dobbiamo introdurre un operatore matematico che conti le preferenze uguali: N+1 dato dalla somma delle preferenze strettamente positive (no astensione); e N-1 dato dalla somma delle preferenze strettamente negative. Se N+1 > N/2 passa X, se N-1 > N/2 passa Y. Le due regole di maggioranza differiscono per il modo con cui vengono contate le diverse posizioni degli agenti. Se non vi sono astensione le due regole coincidono.

B.- DIPENDENZA DEL SENTIERO NELLA PROCEDURA OTTIMALE DELL’UNANIMITà.

L’esito della scelta collettiva dipende sia dalla situazione iniziale che dalla successione delle alternative. Tale proprietà della procedura di decisione dell’unanimità è nota come Path Dependance (dipendenza del sentiero) della soluzione efficiente, cioè l’esito della procedura deliberativa dipende dalla scelta delle alternative proposte dal presidente. Il grafico sottostante mostra questa proprietà indesiderabile dell’unanimità. In ascissa e ordinata vi sono rispettivamente le utilità totali che ogni iter comporta per i due individui A e B, presi in considerazione.

A.- SOLUZIONI POSSIBILI CON LA REGOLA DELL’UNANIMITà.

Le proposte saranno approvate all’unanimità solamente se A e B voteranno entrambi si. Da ciò deriva che solo gli item contenuti nel semipiano ombreggiato potranno essere accettati da entrambi. Se il presidente propone nell’ordine del giorno le mozioni Mi, il sentiero percorso sarà Emi e sarà approvata Mb, se invece il presidente propone le mozioni Ni il sentiero sarà Eni e sarà approvato Nb. L’esempio mostra che fatto all’unanimità il primo passo su un sentiero non è più possibile tornare indietro in quanto l’altro sentiero sarà bloccato dai veti o di A o di B.

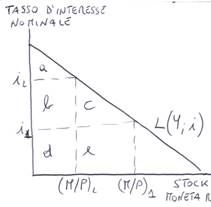

Questa procedura di voto permette la ricerca dei miglioramenti possibili all’interno del Core, una rende anche possibile che la selezione delle azioni efficienti si presti ad essere manipolata, sia da parte del presidente (tramite l’ordine del giorno), che da parte dei singoli partecipanti al comitato se decidono di votare in modo non sincero, adottando un comportamento strategico. Con l’espressione Manipolazione Strategica del voto si intende la possibilità di ottenere un risultato più favorevole votando in modo insincero. Quindi una procedura di votazione si dice manipolabile se, c’è almeno un votante che trae vantaggio dal dare una falsa rappresentazione delle proprie preferenze. Esiste una seconda interessante considerazione della votazione ordinaria dell’unanimità. La quantità di bene pubblico scelta attraverso questa procedura, pur appartenendo al Core, non corrisponde alla quantità ottimale desiderata da nessuno dei due membri del comitato. Tale problema può essere eliminato ricorrendo alla procedura completa o di Tàtonnement. Secondo questa procedura di voto, il presidente (banditore Walrasiano) annuncia una proposta di ripartizione del costo di acquisto e i membri votanti esplorano l’intero spettro delle possibili combinazioni. La quantità di spesa sarà approvata se solo se è unanimemente preferita ad ogni altra alternativa possibile (U’= MC). Se la ripartizione scelta non soddisfa tale condizione di ottimalità, il presidente aggiusta le aliquote aumentando quella dell’individuo per cui l’utilità marginale eccede il costo e riduce l’altra. Questa posizione ottimale che si raggiunge con la procedura completa dell’unanimità è detta Equilibrio di Lindahl.

LA PROCEDURA COMPLETA DELL’UNANIMITà

L’EQUILIBRIO DI LINDAHL.

L’equilibrio di Lindahl, poiché ottenuto come intersezione delle due curve di domanda individuali del bene pubblico verifica le medesime proprietà di ottimalità dell’equilibrio economico generale Walrasiano. L’equilibrio di Lindahl è unico e non dipende dal percorso di selezione delle alternative possibili ma solo dalle condizioni iniziali e dagli ordinamenti delle preferenze individuali. Ciò accade perché ciascun votante è in grado di esplorare l’intero spettro delle alternative possibili è potrà quindi scegliere quella che è preferita in assoluto.

ASPETTI NORMATIVI DELL’UNANIMITà.

Il principio dell’unanimità dei cittadini è una condizione necessaria per intraprendere un’azione collettiva. Ne segue che le sole azioni collettive possibili sono quelle per le quali il beneficio aggregato supera il costo aggregato, così che coloro che ne sono danneggiati possono essere compensati da coloro che ne traggono vantaggio. Dunque la regola di decisione unanime consente di esplorare le strategie migliorative e di giungere sulla frontiera delle allocazioni Pareto – Efficienti, ma non consente di risolvere i problemi puramente distribuiti (giochi a somma zero, ripartizione costi).

La regola delle decisioni all’unanimità, se è in grado di escludere qualsiasi possibilità di sopraffazione degli interessi individuali da parte della maggioranza, non è pero immune da un’altra forma di tirannia consistente nell’incapacità di assumere una decisione e, quindi, nella conservazione dello status quo. I comitati, infatti, dovendo scegliere una sola alternativa, si trovano spesso nell’impossibilità di decidere. In questi situazioni si impone lo status quo, ovvero il mantenimento della situazione preesistente. L’unanimità è molto difficile da raggiungere e si crea spesso un forte giudizio a favore dello status quo. Quindi la regola dell’unanimità non è immune da costi. Infatti, poiché la regola dell’unanimità incoraggia il comportamento strategico, i tempi di una delibera possono dilatarsi enormemente a causa di un comportamento non sincero degli agenti. Peraltro il tempo richiesto per un consenso unanime è di importanza cruciale per la politica economica. L’efficacia stessa di un provvedimento di politica economica dipende dal periodo di tempo (intervallo della politica economica), che intercorre la manifestazione del fenomeno che richiede l’intervento e l’inizio dell’attivazione della strategia. Quindi, l’intervallo della politica economica è la somma del Ritardo di Percezione, che intercorre tra la manifestazione del fenomeno e la sua percezione da parte del policy maker, e il Ritardo di Delibera, che dipende invece dal tempo richiesto per formare il consenso.

LA TEORIA DELLA MAGGIORANZA OTTIMA (COSTI INTERNI ED ESTERNI).

La teoria della maggioranza ottima (Buchaman e Tullock) afferma che in ogni decisione sociale sono presenti due tipi di costo: costi esterni e costi interni. I cosi esterni sono davanti alla coercizione, cioè la perdita di utilità connessa all’abbandono dell’unanimità (costo decrescente all’aumentare del quorum, costo è massimo in presenza di un dittatore). I costi interni si riferiscono al tempo e allo spazio richiesto per assicurare l’ottenimento dell’accordo. Tale costo è zero quando è sufficiente un solo individuo per prendere decisioni, mentre cresce con il numero di persone che si deve accordare (curva BB’). Volendo minimizzare i costi di una procedura decisionale occorre sommare i due costi e scegliere quella maggioranza associata al minor costo totale di decisione (x nella curva cc’). In corrispondenza di x si individua allora la maggioranza ottenuta che minimizza i costi della scelta sociale in questione.

L’impostazione di Buchaman – Tullock non è immune da critiche. Infatti esistono ovvi problemi di misurazione dei costi esterni e interni. Inoltre tale regola non identifica una soluzione valida per tutte le delibere, poiché i costi possono variare enormemente da delibera a delibera.

Secondo il teorema di May, una regola di scelta sociale f(.) è una regola di voto della maggioranza semplice se e solo se soddisfa i principi di: Dominio Universale, Anonimia, Neutralità e Condizione di risposta positiva. Dominio universale se la regola di scelta sociale ha per dominio tutti i possibili ordinamenti delle preferenze degli individui che compongono il comitato (cioè se la società può esprimersi per ogni insieme di preferenze individuali); Anonimia se tutti gli individui sono trattati allo stesso modo; Neutralità se invertendo le preferenze di tutti gli agenti anche la società le inverte; Condizione di Risposta Positiva se quando un individuo aumenta la propria preferenza per una mozione rispetto ad un’altra, anche la società rispecchia questa preferenza.

Se di assume che nessun membro del comitato conosce le future preferenze proprie e degli altri agenti e ci si chieda qual è per ciascuno la regola ottimale di delibera, data la condizione di incertezza, è naturale definire ottimale per l’individuo una regola che minimizzi il numero dei casi in cui egli può trovarsi in dissenso con al collettività. In particolare l’individuo preferirà la regola della maggioranza quando è favorevole ad una mozione ma la società la respinge, oppure quando è contro una mozione ma la società l’adotta.

Secondo il teorema Dell’elettore Mediano se le preferenze degli individui presentano una sola mansione rispetto ad un certo ordine condiviso, e se ogni individuo vota per l’alternativa più vicina alla posizione che preferisce maggiormente allora la regola della maggioranza produce sempre un risultato di equilibrio e la proposta vincente sarà quella collocata al centro cioè in posizione mediana rispetto alle altre. Il teorema dell’elettore mediano mostra anche i limiti fondamentali della regola della maggioranza, infatti essa è in grado di decidere sulle proposte che riguardano iter ordinabili secondo un unico criterio classificatorio ma è più debole di fronte a proposte che implicano una scelta tra più alternative, ossia proposte ordinabili secondo più criteri classificatori. In tutti questi casi la regola della maggioranza può incontrare difficoltà, come il paradosso del voto.

Condorcet osserva che le votazioni a maggioranza relativa, quando sia consentito a ciascun votante di indicare solamente l’alternativa preferita senza pronunciarsi su tutte le altre, possono dar luogo ad incongruenze e ad esiti irragionevoli. Infatti qualora vi siano più di due mozione tra cui scegliere, la maggioranza semplice può condurre a decisioni intransitive, cioè si possono formare esiti cilici di maggioranza (paradosso del voto).

Secondo il teorema di Black (se il numero dei votanti è dispari) e le preferenze individuali sono Single – Peaked, allora le maggioranze semplice esprime una preferenza collettiva degli iter ordinate in senso 1.-non decrescente o in senso 2.-crescente. La proprietà Single – Peaked è quindi sufficiente per escludere il paradosso del voto.

La procedura ordinaria di comitato (Managing Ordering), consente di restringere l’insieme delle alternative possibili votando semplicemente non u tutte le coppie di alternative, ma su un numero minore, in quanto l’alternativa che perde un confronto viene eliminata. L’ordine con cui le alternative vengono poste a confronto è detto Agenda (O.D.G). Questa procedura ha senso solo se, in ciascuno stadio, si riesce a definire un vincitore. In caso di indifferenza occorre prevedere delle procedure di Tie – Breaking (sorteggio). Il difetto principale della procedura ordinaria di comitato è che l’esito finale della votazione dipende dall’ordine in cui le alternative vengono sottoposte a votazione e non dalla configurazione delle preferenze individuali. Di conseguenza l’Agenda determina il risultato (O.D.G).

Definiamo come procedura Manipolabile una regole di voto che offre ad almeno un membro del comitato il vantaggio a non esprimere sinceramente le proprie preferenze. Definiamo invece come procedura Dittatoriale una regola di voto che per ciascun profilo di ordinamenti possibili produce una decisione di comitato che coincide con quella di un dato individuo.

Secondo il teorema di Gibbard – Satterthwaite, quando si deve scegliere almeno tra tre alternative non esiste alcuna procedura di voto non dittatoriale che sia resistente contro la manipolazione delle preferenze da parte dei votanti: ogni procedura è manipolabile o dittatoriale. Ma non esiste quindi alcun sistema di votazione che sia al tempo stesso razionale, decisivo ed egualitario, facile manipolazione tra loro.

4.- Le scelte pubbliche: gli obiettivi secondo la funzione del benessere sociale.

Un ordinamento di preferenze deve soddisfare alcune ipotesi di coerenza Completezza = per ogni coppia di alternative (x,y) deve essere vero che xRy o yRx oppure entrambi xIy; Transitività = se xRy o yRz = xRz; Quasi Transitività = xPy e yPz = xPz; Aciclicità = un ordinamento di preferenze è aciclico se date “n” alternative non genera mai cicli di preferenza collettiva. In letteratura vi sono più modi per intendere una funzione di utilità = Cardinale in scala assoluta, per cui la funzione u(.) è invariante e non ammette alcuna trasformazione; Cardinale in scala Relativa, per cui la funzione u(.) è invariante a meno di una trasformazione proporzionale positiva U°(.)=U(.) se U°=f(u) con f=ku e k>0; Cardinale per cui la funzione u(.) è invariante a meno di una trasformazione lineare affine positiva, a meno di una trasformazione monotona crescente, U°(.)=U(.) se U°=f(u) con f’>0.

Da notare che i modelli che assumono le ipotesi più forti giungono a conclusioni che sono per conseguenza meno robuste, mentre i modello che assumono le ipotesi più deboli giungono a conclusioni che devono essere accettate come più robuste. Le ipotesi sul confronto interpersonale delle utilità invece possono essere formalmente indipendente dall’ipotesi sulla misurabilità. Le tre alternative possibili sono: Confrontabilità piena (assoluta), quando tutte le informazioni sulle utilità degli individui sono confrontabili; Confrontabilità parziale (relativa), quando solo alcune informazioni sulle utilità degli individui sono confrontabili; Inconfrontabilità quando nessuna informazione e confrontabile. L’ultimo problema che sorge per la definizione di un ordinamento sociale indiretto è quello della regola per l’aggregazione delle preferenze individuali.

Quelle più usate sono: Il criterio di Pareto e quello di Kaldor.

CRITERIO DI PARETO - EFFICIENTE

Il criterio di Pareto si fonde su l’individualismo etico; la misura ordinale dell’utilità e l’inconfrontabilità personale delle utilità. Le condizioni logico – matematiche su cui si fonda il criterio di Pareto sono: Formula……….. con la prima si individua il principio di Pareto nella sua versione debole: esso sostiene che un insieme di persone migliora la propria soddisfazione passando da y a x se tutti gli individui hanno livelli più alti di utilità. Con la z si individua il principio di Pareto nella sua versione forte: esso sostiene che un insieme di persone migliora la propria soddisfazione passando da y a x se almeno un individuo sta meglio e nessuno sta peggio. Si definisce Ottimoparetiano uno status per cui non è possibile migliorare la soddisfazione di qualcuno senza peggiorare quella di un altro. Il criterio di Pareto consente un ordinamento parziale e non completo delle preferenze sociali sia tra allocazioni ottimali che sub ottimali (in quanto alcune allocazioni sono non confrontabili). La regola di aggregazione espressa dal criterio di Pareto è molto forte poiché utilizza le ipotesi più deboli riguardo la misura (ordinale) e il confronto interpersonale delle utilità. Inoltre essa non consente di risolvere tutti i problemi di ordinamento sociale degli stati dl mondo.

Il criterio di Kaldor tenta di allargare gli stati del mondo ordinabili dal punto di vista della società, mantenendo le premesse del criterio di Pareto riguardo all’impossibilità nei confronti interpersonali. Tale criterio introduce la possibilità di concedere un indennizzo per prendere posizione su alternative sulle quali Pareto non si saprebbe esprimere (principio di indennizzo). Tuttavia sono state mosse delle critiche anche a questo criterio. Infatti il principio di indennizzo si esaurisce solamente in un problema concettuale non a caso nulla dice sul modo con cui tale trasferimento possa concretizzarsi e su quale istituzione debba provvedersi.

Secondo la funzione del benessere di Berson – Sammuelson, la società preferisce lo stato x allo stato y = w(ua(x);ub(x)….;un(x)) > w(ua(y);ub(y)….;un(y)). Tuttavia pur considerando tutte le N funzioni di utilità u(.), rimane aperto il problema della scelta del tipo di funzione tramite la quale effettuare l’aggregazione delle utilità individuali. Per risolvere tale problema è stato introdotto il principio utilitarista di Bentham, che suggerisce di calcolare il benessere pubblico sommando le utilità individuali = w=u1+u2…..+un = ∑ ui. Per trovare la configurazione migliore per il comitato, occorre massimizzare la funzione di benessere sociale dw/dqa = dua/dqa ((dub/dqb)(dqb/dqa))= 0. Poiché dqb/dqa =-1, otteniamo una condizione che permette di determinare quale allocazione sia preferita per la società (dua/dqa)- (dub/dqb) =0. Ma tale espressione rende palese che per decidere sulla ripartizione ottimale del bene è necessario procedere ad una comparazione interpersonale dell’utilità individuali, un’ipotesi restrittiva per cui sotto questo punto di vista le regole di aggregazione proposte da Sammuelson appare debole. Per cercare altre regole di aggregazione si aprono quindi due strade: Una di sostanziale conferma ma che cerca ulteriori affinamenti, l’altra di abbandono. Per prima alternativa si tratta di insistere nell’ipotesi di proporre confronti interpersonali cercando altre regole e altri criteri. Ma cosi facendo si porta la politica economica verso altre discipline filosofiche. Della seconda alternativa si è fatto carico Arrow, cercando un’impostazione della funzione di benessere sociale che rigettasse sia la comparazione interpersonale delle utilità, sia qualsiasi misurazione cardinale del benessere sociale.

Altri criteri di aggregazione sono: la funzione del benessere sociale di Bernoulli – Nash, che a differenza di quella di Bergsou – Sammuelson usa il prodotto auriche la somma l’ottimo sociale non richiede più l’uguaglianza delle utilità marginali, ma l’uguaglianza dei tassi di variazione delle utilità stesse; e la funzione di benessere sociale di Rawl, che si basa sul criterio del MAXMIN, in cui la valutazione di uno stato sociale dipende solo dal benessere dell’individuo che si trova nella situazione peggiore min ui.

Una regola di scelta collettiva (rsc) è una relazione funzionale che specificano una relazione di preferenza sociale per ogni profilo di preferenza cioè per ogni insieme di ordinamenti individuali. Una funzione di benessere sociale (fbs) è una regola di scelta collettiva (rsc) il cui codominio è ristretto alle R che generano degli ordinamenti.

Una funzione di decisione sociale (fds) è una regola di scelta collettiva (rsc) il cui codominio e ristretto alle R che generano una funzione di scelta. Arrow analogamente a quanto richiesto per l’individuo, richiede anche per la società la verifica dei seguenti assiomi: Completezza e Transitività; Dominio Universale delle Alternative; Principio debole di Pareto (unanimità); Indipendenza dalle alternative irrilevanti; Mancanza di un Dittatore.

Il teorema dell’impossibilità di Arrow è enunciato in due versioni: non esiste una fbs che soddisfi tutte le condizioni del teorema; e qualunque fbs che soddisfi le prime la condizioni pone un agente nelle condizioni de essere un dittatore.

Consideriamo due ordinamenti di prferenze degli individui α e β su quattro alternative A= xPuPvPy e B=vPyPxPu. Se per ipotesi supponiamo che sulla coppia (u,v) la collettività si esprime con la preferenza uPv, per l’assioma della transitività ne consegue che = xPu; uPv; vPy = xPv. Allora se una configurazione di ordinamento di u e v di certi votanti implica che “u” sia collettivamente preferito a y. Questa proprietà è chiamato neutralità, e con ciò si è dimostrato il rispetto dei primi quattro assiomi del teorema di Arrow.

Dobbiamo considerare una scelta sociale in un caso più generale in cui gli ordinamenti di preferenze di α e β siano un insieme più vasto di stati sociali alternativi A= vPyPxPuPzPw e B= uPyPwPxPzPv. Il quadrante in cui ciascuna alternativa è collocata dipende dall’ordine in cui i due individui classificano l’alternativa stessa rispetto alla x. Il q1 comprende l’alternativa y che entrambi preferiscono ad x; il q2 racchiude u e w che β giudica migliori di x mentre α inferiori; il q3 contiene z che entrambi considerano inferiore a x; e il q4 comprende che α considera migliore di x, mentre β peggiore. Le condizioni di Arrow implicano che ogni fbs sia in grado di classificare ogni alternativa presente in un quadrante rispetto ad x. È chiaro che non vi è problema per q1 e q3 mentre ve ne sono per q2 e q4. La proprietà della neutralità comporta che ogni alternative presente in un quadrante sia collettivamente considerata nello stesso modo rispetto a x. In più la neutralità implica che se uPx=xPv, perche la configurazione delle coppie (u,x) e (x,v) è la stessa. Siccome l’assioma dell’unanimità implica che q1 sia preferita a x e che q3 sia inferiore i 4 assiomi di Arrow sono compatibili solo con 2 esiti sociali. Se q4 è preferito a x e q2 è inferiore, α è un dittatore; se q2 è preferito a x e q4 è inferiore β è un dittatore.

Per superare il problema del teorema di Arrow si è indebolito il requisito della Transitività. A causa di ciò non è più necessaria una fbs ma è sufficiente una funzione di decisione sociale (fds), in quanto non è richiesto la transitività di R. tale procedure porta al teorema della possibilità di Sen, secondo il quale per x finto esiste una fds che soddisfa le ultime quattro condizioni del teorema di Arrow e la transitività della sola relazione di preferenza sociale stretta P. Sen stesso riconosce che la norma del consumo non rappresenta una alternativa risoluta al problema di Arrow, perché se due individui hanno interessi contrapposti la norma del consumo dichiara le due alternative indifferenti. Gibbard dimostro che ogni procedura che soddisfi la transitività di P e obbedisce ai restanti assiomi di Arrow, esiste un gruppo privilegiato di individui (oligarchia), il quale ha il potere di informare all’intera società la propria preferenza stretta riguardo a qualsiasi coppia di alternative.

Per sfuggire a questo problema è stato necessario indebolire ulteriormente il concetto di razionalità della scelta collettiva, imponendo il rispetto di una condizione ancora meno restrittiva della transitività di P: L’aciclicità (assume di cicli di preferenza stretta).

Le vie per sfuggire al dilemma Arrowiano tra uguale distribuzione del potere e decisività sono limitate e sono quindi inevitabili pesanti compromessi. Assiomi secondo Sen: si deve indebolire la nozione di razionalità collettiva rinunciando sia alla transitività della relazione di indifferenza I, sia alla transitività della relazione di preferenza stretta P, si richiede quindi l’aciclicità; si deve rinunciare all’assioma arrowiano di indifferenza delle alternative irrilevanti; si deve assumere una versione molto debole del principio di Pareto (unanimità); conservare la condizione di irriversalità degli altri requisiti arrowiani, per evitare che il dominio della regola di scelta risulti arbitrariamente ristretto (dominio non ristretto: ogni insieme di ordinamenti individuali è incluso nel dominio della regola di scelta collettiva rsc); e aggiungere infine una condizione che rappresenta una garanzia del valore della libertà individuale, il Liberalismo (per ogni individuo esiste almeno una coppia di alternative tale che, se questo individuo preferisce x a y o y a x, allora la società deve preferire x a y o y a x).

Secondo il teorema dell’impossibilità di Sen, non esiste alcuna funzione di decisione sociale che possa soddisfare simultaneamente le condizioni sopra elencate.

La teoria delle scelte sociali può essere sviluppata su due ipotesi: se la regola deve operare solo sull’insieme di tutte le alternative, si dice che il comitato delibera con Agenda Fissa; se invece si vuole che la regola di scelta indichi anche quali sono le alternative prescelte da alcuni sottoinsiemi delle alternative, allora la regola opera con agenda variabile (fondata da Arrow). Ovviamente una regola che opera con agenda variabile offre più informazioni di una opera con agenda fissa, ma la delibera è più complessa.

I teoremi di impossibilità affermano che non esiste alcuna regola di scelta sociale che soddisfi certi assiomi desiderabili. Essi conducono quindi alla conclusione che la democrazia di un comitato sembra essere un’utopia. Nonostante il tentativo di modificare le ipotesi, il risultato è rimasto pressoché immutato. La risposta più fruttuosa ai teoremi di impossibilità nella teoria delle scelte sociali è quella che sottolinea la necessità di un mutamento di prospettiva, auriche di un indebolimento delle condizioni. Tra questi mutamenti di prospettiva, Denicolo indica come particolarmente proficui quelli che consistono nell’ammettere la necessità di effettuare confronti interpersonali di utilità, poiché questa proposta va nella direzione di esplicitare i giudizi di valore impliciti nelle scelte pubbliche. Ciò conviene tramite le funzioni di Preferenza e le funzioni di Perdita.

Per Dittatore Benevolente si intende quel responsabile politico che tratta in modo egualitario tutti gli agenti, tale ipotesi si è dimostrata la più resistente agli attacchi dei critici ed è adottata in molti modelli come l’attimo sociale del mercato di libera concorrenza (p=mc); e l’ottimo sociale del sistema economia-ambiente (bm=mc).

La forma funzionale più semplice della funzione di preferenza è la Funzione di Preferenza Lineare definita tramite dei parametri qi per i=1,2,..n. L’esplicitazione più comune è: w(x)=q0+∑ qixi, dove qi è la ponderazione dei politici attribuita alle diverse variabili e q0 è una costante. La forma lineare, tuttavia è troppo semplice poiché la derivata seconda è sempre nulla, una proprietà indesiderabile per i problemi che comportano la ricerca di un massimo o un minimo. Per questo motivo si utilizza spesso la funzione di preferenza Quadratica. La forma quadratica generale assume la forma w(x)= q0+∑ qixi + ∑∑ qij xi xj, dove il coefficiente qij rappresenta la ponderazione che il politico attribuisce al prodotto tra due distinte variabili obiettivo, mentre i prodotti xi xj divengono forme quadratiche del tipo xi2 per i=j e il coefficiente qij rappresenta la ponderazione che il politico attribuisce al quadrato della variabile obiettivai-esima.

Da ciò deriva la forma quadratica particolare w(x)= q0+∑ qi xi + ½ ∑qii xi2. La forma quadratica è spesso rappresentata tramite l’algebra lineare delle matrici e dei vettori, usando forma quadratiche del tipo xiqx. In questo caso la formula assume la trascrizione w(x) q0+q’x+x’qx con q=(qi) vettore colonna dei coefficienti di ponderazione; x=(xi) vettore colonna delle variabili rilevanti; q=(qi) matrice (n-n) di parametri. La formula di w(x) è molto comoda poiché tutte le proprietà della forma quadratica che interessano alla economista sono comprese nelle caratteristiche della matrice qi, se la matrice è diagonale nello sviluppo quadratico rimangono solamente i termini sulla diagonale principale quindi troviamo la forma quadratica particolare, se la matrice è simmetrica significa che le preferenze del politico sono indifferenti per la commutazione nel prodotto dei termini rettangolari. Inoltre la forma quadratica x’qx riassume tutte le proprietà della funzione w(x) in termini di concavità o convessità (max o min).

Esistono altre forme di funzioni di preferenza anche se meno usate come la funzione cubica particolare, la forma esponenziale e la forma logaritmica (tutte funzioni eclettiche). Le funzioni w(.) che abbiamo visto prendono la connotazione di una funzione obiettivo nei modelli di politica economica con obiettivi flessibili. Poiché queste funzioni di preferenza possono assumere l’interpretazione di funzioni di benessere o funzioni di costo, allora il programma di politica economica comporta: una soluzione di massimo se la funzione di preferenza rappresenta una funzione di benessere; e una soluzione di minimo se la funzione di preferenza rappresenta una funzione di costo.

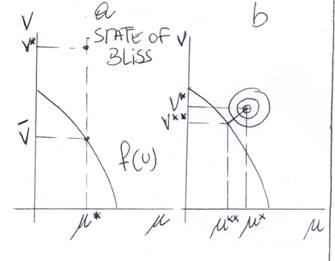

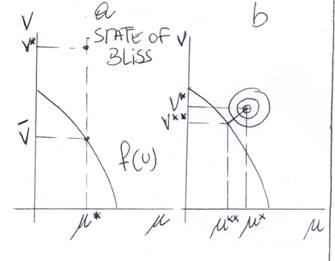

Se riprendiamo la funzione w(x)=q0+q’x+x’qx la immaginiamo come funzione del benessere concava, notiamo immediatamente che essa ammette un punto di massimo assoluto: dw/dx= q+qx=0 di cui x’=-q-1q dove x’ può essere definito come lo stato of bliss delle preferenze del politico.

B.- SIGNIFICATO GEOMETRICO DI UNA FUNZIONE DI RENDITA.

A.- STATE OF BLISS INSIEME DELLE POSSIBILITà.

Può accadere che il valore della X* sia irraggiungibile allora non riconosce che esprimere una valutazione sulle preferenze rispetto alle rinunce che si è costretti a sopportare, questa funzione è detta funzione di perdita. Essa valuta l’entità dei sacrifici necessari non potendo arrivare al massimo assoluto di benessere. La più usata della funzione di perdita e quella quadratica pura P(x)= (x-x*) ! q (x-x*), dove i parametri della matrice Q devono essere interpretati come i pesi attribuiti al politico ad una rinuncia di entità (xi – xi*).(xj-xj*). An cera una volta la matrice q può essere diagonale e la funzione P(x) assume la forma quadratica particolare, che attribuisce penalità solamente alle deviazioni della variabile i-esima rispetto al suo valore desiderato (xi – xi*)2. Tuttavia questa forma quadratica particolare ha una proprietà che può rivelarsi un difetto: poiché la funzione p(x) definita su una matrice diagonale q contiene solo scarti elevati al quadrato le diviazioni per difetto o per eccesso dello State Of Bliss sono penalizzate allo stesso modo. Il grafico a indica lo State Of Bliss ma è ovvio che esso risula impossibile rispetto al vincolo delle risorse. Il comitato dovrà allora indicare una funzione di perdita al policy maker rispetto ad un ottimo irraggiungibile P= ½ (v-v*)2 + ½ (u-u*)2. Questa funzione genera una famiglia di curve di indifferenza come cerchi concentrati rispetto al punto (u*,v*). Il policy maker dovrà quindi rispondere al comitato cercando il programma che minimizza le distanze dalla situazione ideale. Il punto (u**,v**) è l’ottimo vincolato, identificato dalla condizione di tangente tra la curva g(u) e il cerchio più vicino allo state of Bliss. La distanza misurata dal cerchio di tangenza indica il sacrificio minimo cui le società è chiamata.

Capitolo 7

L’INTERVENTO DELLO STATO

Secondo la teoria dello stato minimale, le due funzione minime che lo stato dovrebbe svolgere sono: garantire l’esercizio della proprietà e assicurare il funzionamento dello Stato. Il primo teorema dell’economia del benessere afferma che se le preferenze di ogni agente sono convesse, continue e monotone e se (x*, p) è un equilibrio competitivo, allora x* appartiene al core (e quindi è un’allocazione Pareto-efficiente). Il secondo teorema dell’economia del benessere, invece, afferma che se le preferenze di ogni agente sono convesse, continue e monotone, allora se Y è una qualsiasi allocazione ottimale secondo Pareto con dotazione almeno positive, esiste un vettore di trasferimenti (che ridistribuiscono le dotazioni degli agenti) e un vettore dei prezzi p tale che (Y, p) è un equilibrio competitivo.

I sostenitori dell’intervento dello Stato sostengono che le scelte collettive (intervengo pubblico) sono necessarie non solo per ampliare l’insieme delle scelte di mercato, ma anche per abbandonare una situazione di inefficienza cui le scelte individuali, egoistiche e decentrate possono condurre. Inoltre, l’intervento dello Stato può essere necessario per risolvere un problema di coordinamento delle scelte individuali (decidendo ad esempio che deve agire per primo). Lo Stato può esercitare la sua autorità tramite: l’introduzione di leggi, l’internalizzazione dei valori della matrice dei pagamenti tramite una norma che dichiari fuori legge il furto e preveda delle sanzioni, e premiare la cooperazione.

Il gioco Economico raramente è proposto una volta sola, ma si ripete all’infinito. In queste condizioni può emergere un fenomeno di apprendimento dei soggetti economici che li conduce ad apprezzare certi tipi di comportamento socialmente desiderabili. Se un gioco viene ripetuto più volte, esso dà luogo ad un gioco differente, detto supergioco, il quale è diverso dal gioco ad un solo colpo per due motivi: nel supergioco la strategia di ogni giocatore non è più la scelta di una singola mossa, ma la scelta di una sequenza di mosse; e la soluzione del supergioco non è necessariamente la stessa del gioco iniziale (la ripetizione introduce la possibilità di apprendimento). Secondo il Folk Theorem, nel gioco ripetuto infinite volte emerge un comportamento cooperativo se il tasso di sconto è sufficientemente piccolo.

In economia il termine istituzione ha un significato molto ampio, nonostante ciò si possono distinguere due tipi di istituzioni: la prima classe fa riferimento ad un insieme di leggi, sanzioni e convezioni di varia natura, ma aventi carattere durevole, atte a regolare i rapporti tra i diversi soggetti economici. Simili istituzioni possono nascere automaticamente dai comportamenti dei diversi dei diversi soggetti o essere imposte dall’esterno (istituzione formale); la seconda classe di istituzione non si riferisce solo ad un complesso di norme che dura nel tempo, ma comprende anche le persone che amministrano e applicano quelle norme e i mezzi materiali dei quali esse si avvalgono. Sulle motivazioni che portano alla nascita delle istituzioni formali, esistono tre scuole di pensiero:quella collettivista, quella organica e quella storica. Secondo l’idea collettivista, le istituzioni sociali sono il frutto di un’azione collettiva di agenti economici nazionali. Seguendo la chiave di lettura organica, si afferma che le istituzioni sorgono dall’ interazione di moltissimi agenti, ciascuno dei quali persegue i propri interessi. Infine, secondo la teoria storica, le istituzioni sono il prodotto di conflitti e di convergenze tra i diversi gruppi sociali che non necessariamente si compongono in maniera efficiente. Le istituzione, invece, possono essere suddivise secondo altri criteri. Le istituzioni economiche si classificano in pubbliche e private. Sono pubbliche le istituzioni che perseguono interessi collettivi e sono dotate di poteri coercitivi; mentre sono private quelle che perseguono finalità individuali e sono caratterizzate dalla partecipazione volontaria. Una seconda distinzione fa riferimento alla circoscrizione in cui l’istituzione opera: nazionali internazionale e sovranazionali.

IL MODELLO DI BUREAU.

Il sistema si scambi volontari che identifica un’economia di mercato, per realizzarsi, richiede che la collettività abbia risolto alcuni problemi. Infatti è necessario che alle funzione dello Stato minimale si aggiungano altri interventi: una funzione di redistribuzione delle risorse se la collettività intende decidere in ambiti più ampi di quelli imposti dal mercato; un sistema di leggi (con sanzioni e premi); e, infine, un complesso di istituzioni. Volendo riassumere in un modello l’intervento del policy maker, dobbiamo creare alcune regole normative applicate alla condotta dell’economia pubblica. Facendo riferimento all’attività di uno Stato immaginario, la molteplicità degli obiettivi può essere ricondotta a tre uffici fondamentali (bureau): al location bureau, che si occupa della gestione e distribuzione delle risorse; stabilization bureau, che si occupa della stabilizzazione dell’attività economica; distribution bureau, che si occupa della distribuzione del reddito e della ricchezza.

Una prima importante distinzione del modo con cui i bureau dello Stato possono intervenire sul sistema economico è quella tra indiretto e diretto. Per controllo diretto si intende ogni intervento mirato a raggiungere l’obiettivo imponendo un dato comportamento agli operatori privati. Per controllo indiretto si intende ogni intervento mirato a conseguire l’obiettivo inducendo gli operatori a comportarsi nel modo desiderato dallo Stato. Nel sistema di mercato, il problema della selezione tra gli interventi diretti e indiretti coinvolge due alternative: intervenire sulla quantità (intervento diretto) o sui prezzi (intervento indiretto). Secondo il teorema di Poole-Weitzman (principio di indifferenza), in condizioni di incertezza, l’intervento indiretto del policy maker nel mercato, tramite un provvedimento quantitativo, supportato da un adeguato enforcement (attrazione), conduce allo stesso risultato dell’intervento indiretto tramite una legge che introduce prezzi (imposte o sussidi) e che lascia decidere la produzione al mercato. Tale principio di indifferenza, però, viene meno qualora si introducono considerazioni di efficienza o se si considera un modello stocastico. Per il teorema di Baumol-Oate, l’intervento diretto tramite imposte o sussidi per ottenere un livello socialmente desiderabile di produzione/consumo di un bene, soddisfa le condizioni per minimizzare il costo sociale dell’intervento. Questo teorema dimostra la superiorità dell’azione indiretta dello Stato, ma in un contesto stocastico la soluzione non è così scontata. Infatti, se lo Stato non conosce la realizzazione dei disturbi, code il principio di indifferenza. Se i due strumenti non conducono più allo stesso risultato, si impone l’introduzione di un criterio di scelta: il criterio di Poole e il criterio di Weitzman. Il criterio di Poole enuncia la preferenza per quell’intervento che conduce al minimo valore atteso dello scarto tra l’esito della politica e l’obiettivo desiderato. Il criterio di Weitzman, invece, enuncia la preferenza per quello strumento che conduce al massimo beneficio sociale atteso, cioè la stessa funzione rispetto alla quale il policy maker ha formato il proprio programma. I due criteri hanno diversi presupposti. Quello di Poole privilegia un’espressione quantitativa confrontando coerente con un modello a obiettivi flessibili. Pur essendo diversi, i due criteri portano a conclusioni comuni: il disturbo sulla funzione di preferenza sociale non è influente rispetto alla scelta tra l’una e l’altra modalità di intervento; e la soluzione dello strumento dipende dalla variabile che l’evento causale produce sulla scelta privata di produzione.

Una seconda importante distinzione del modo con cui i bureau possono intervenire nel sistema economico è la distinzione tra interventi legati all’esecuzione di regole oppure ispirati ad un governo di natura discrezionale. Per il governo dell’economia tramite regole, siano esse razionali oppure empiriche, è necessario distinguere tra regole fisse (che dipendono dalla sola osservazione iniziale dello stato del sistema dette regole open loop) e regole flessibili ( se eseguono l’evoluzione economica del sistema nel tempo, dette regole closed loop o feedback), oppure, in base al loro grado di semplicità, tra regole fisse (le più semplici perché non mutano mai) e regole contingenti, che si modificano in funzione del tempo. Quindi, i modi con cui l’ autorità pubblica può esercitare sono: un controllo discrezionale, se gli strumenti di politica economica vengono manovrati caso per caso, dopo un’attenta valutazione della situazione specifica; e un controllo con regole automatiche, se gli strumenti di politica economica vengono governati senza che vi sia bisogno di decidere caso per caso, ma rispettando regole prefissate. Gli argomenti a favore della superiorità delle regole fisse sono tre: l’inefficienza dei bureau (Friedman); il disturbo della strategia degli agenti privati (Lucas); e l’incoerenza temporale. Infatti, la discrezionalità in politica economica potrebbe essere superiore alla regola fissa, ma i privati con i loro comportamenti forzano i bureau a legarsi a delle regole fisse.

A favore della discrezionalità troviamo l’ortodossia keynesiana mentre a favore delle regole fisse la nuova macroeconomia classica. Secondo quest’ultima l’azione dei bureau non è efficace e gli scostamenti della produzione effettiva rispetto al valore nominale di piena occupazione sono dovuti unicamente agli effetti sospesi. Questa conclusione porta alla negazione della discrezionalità dei bureau poiché, per essere efficace, dovrebbero giocare “a caso” la decisione sugli interventi di politica economica. A causa di ciò, la nuova macroeconomia classica nega l’opportunità di bureau che si occupano di politiche discrezionali. Infatti, poiché gli interventi dei bureau producono instabilità, la nuova macroeconomia classica propone di minimizzare le loro funzioni e la loro attività. In questa visione, la politica economica non richiede un’istituzione in grado di scegliere tra finalità alternative e di disporre di controlli efficaci per raggiungere l’obiettivo prescelto. La gestione dei bureau dello Stato può essere affidata a semplici funzionari che si attengono a regole fisse per lunghi periodi. In questo caso si parla di nuovo Stato minimale. Quest’ultimo garantisce l’esercizio della proprietà e dei contratti, assicurando cosi il funzionamento del mercato e gestisce l’economia tramite i funzionari senza autorità discrezionale.

Musgrave, nell’indicare l’attività dei bureau, formulò l’ipotesi che essi potessero funzionare l’uno indipendente dall’altro. Mai più recenti studi macroeconomici hanno rimesso in discussione tale ipotesi di separazione, soprattutto tramite la Teoria del disequilibrio. Quest’ultima propone una chiave di lettura più realistica dei mercati: i prezzi sono fissati dagli agenti, i prezzi sono fissi, e gli scambi avvengono anche fuori dall’equilibrio. Quest’ultimo punto comporta un importante corollario per la teoria economica: nn si può continuare ad assumere che le decisioni degli individui vengano prese esclusivamente tenendo conto delle informazioni di prezzo. Si configura cosi la possibilità di un’analisi del disequilibrio del sistema economico in cui: alcuni mercati possono non essere in equilibrio; gli aggiustamenti possono avvenire nelle quantità piuttosto che nei prezzi; e che gli agenti reagiscono ai segnali di prezzo e di quantità. Se gli agenti fissano un prezzo diverso da quello di equilibrio, non è più vero che ogni compratore trova un corrispondente venditore e viceversa. Poiché non tutti gli agenti sono soddisfatti, per l’analisi del disequilibrio è necessario sviluppare due regole che consentano di: individuare il volume degli scambi e individuare chi rimarrà insoddisfatto.

DISEQUILIBRIO CLASSICO KEYNESIANO E IL CORDINAMENTO DELLE POLITICHE ECONOIMCHE.

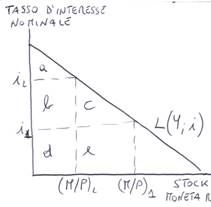

“La regola del lato corto, governa il funzionamento dei mercati in disequilibrio poiché, soddisfacendo le proprietà della volontarietà e dell’efficienza del mercato, afferma che la transazione che si verifica di fatto è la più piccola tra la domanda e l’offerta. Questa regola consente di determinare l’entità delle transazioni e l’entità del razionamento(evidenziata in grassetto). Al prezzo P1 il segmento AB riflette il razionamento dei venditori, mentre al prezzo P2 il segmento CD riflette il razionamento degli acquirenti. Per completare la teoria del funzionamento del mercato in disequilibrio, rimane il problema dell’individuazione di chi risulterà razionale. È quindi necessario disporre di uno schema di razionamento. Tra le molteplici possibilità, Bonassy ne ricorda 3:il razionamento proporzionale, per cui gli agenti del Lato corto realizzano le loro domande o offerte, mentre gli agenti del lato lungo realizzano delle transazioni che sono proporzionali alla loro offerta o domanda; il razionamento con il sistema delle code, per cui gli agenti sono soddisfatti secondo un ordine predeterminato; il razionamento per priorità, per cui alcuni agenti scambisti sono individuati per criteri personali o istituzionali che conferiscono loro diritto di priorità. I casi del disequilibrio possono essere 2: quelli in cui è razionata l’offerta perché il prezzo è troppo alto (caso keynesiano) e quello in cui è razionata la domanda perché il prezzo è troppo basso (caso classico). Nel caso keynesiano il bureau può intervenire direttamente esprimendo una domanda pubblica, oppure indirettamente, tramite incentivi che inducono i privati ad aumentare la loro domanda effettiva (d’). nel caso classico il bureau con competenze microeconomiche, se intende muovere lungo l’offerta per raggiungere la produzione W, deve aumentare il prezzo, mentre il bureau con competenze macroeconomiche non ha alcun titolo di intervento: un aumento della domanda si risolverebbe del tutto inefficace. Infatti, qualsiasi domanda addizionale, essendo l’offerta il lato corto del mercato, si risolverà solo in un ulteriore razionamento. Nel caso classico, quindi, solo un bureau può intervenire per raggiungere l’obiettivo. La teoria del disequilibrio comporta quindi l’esigenza di coordinare le azioni del bureau.

Una volta accertato che esistono ragioni per l’intervento di più bureau si apre il problema del decentramento. Se alcune funzioni vengono attribuite a uffici specifici, si parlerà di funzionamento decentrato, se invece tutte le funzioni sono mantenute presso un unico ufficio, si parlerà di funzionamento accentrato. Il decentramento delle funzioni dei bureau può essere verticale ed orizzontale. Il decentramento verticale è attuato quando le diverse funzioni vengono attribuite a soggetti separati, ma con riferimento a tutto il territorio nazionale. Il decentramento orizzontale (Stato Federale) si avrà invece quando il bureau ripartisce la propria autorità su enti territoriali diversi. Le motivazioni per la scelta federale/orizzontale sono: le Economie di scala, in quanto per alcunoi beni si esauriscono a livelli territoriali minori; gli Effetti di spillover, in quanto il decentramento territoriale è consigliabile per quegli interventi che esauriscono la maggior parte dei loro effetti all’intyerno di un territorio; la Libera circolazione dei cittadini, in quanto lo Stato federale consente un’efficienza democratica maggiore rispetto allo Stato centralizzato, sia perché i cittadini possono distribuirsi negli stati secondo uniformità di gusti, sia perché al voto nei comitati si aggiunge un’altra manifestazione di volontà politica, il voto con i piedi; la Competizione tra le regioni (molto simile alla competizione tra le imprese); e la Soddisfazione del maggior numero di cittadini. Uno Stato attua un decentramento verticale quando le funzioni dei bureau vengono distribuite a più soggetti indipendenti. Nel decentramento verticale sorge il problema dell’assegnazione, ai singoli bureau, di obiettivi e strumenti. Se il modello economico non è integrato, cioè è rappresentabile tramite una matrice di partecipazione delle variabili diagonale, il problema di corretta assegnazione non si pone in quanto ciascun obiettivo risponde all’azione di un solo strumento ed esiste un solo accoppiamento strumenti-obittivi. Se il sistema è parzialmente integrato, il problema della corretta assegnazione degli strumenti agli obiettivi risulta semplificato poiché l’interdipendenza lega solo i gruppi di variabili. Se il modello è completamente integrato, allora il cambiamento di un qualsiasi strumento influenza non solo la variabile obiettivo cui è assegnato, ma anche tutte le altre. Per il Teorema di Mundell, se il sistema economico è controllabile, in una politica economica policentrica ciascuno strumento dovrebbe essere applicato al controllo dell’obiettivo su cui agisce maggiore efficacia relativa. Il significato di tale principio è che, quando si muove un qualsiasi strumento per ricondurre una variabile verso il valore obiettivo, se il modello è integrato, si eserciteranno degli effetti su altre variabili. Se però l’accoppiamento strumenti-obiettivi avviene secondo il principio della classificazione dei mercati, è possibile rendere minimi questi effetti.

La LAW AND ECONOMICS (economia delle leggi) può essere distinta in una nuova e vecchia teoria. la vecchia Law and Economics riguarda tutte le leggi che influiscono direttamente sull’economia e ne esamina gli effetti sui mercati. La nuova Law and Economics si occupa invece dell’apparato legislativo e non solo delle leggi che riguardano gli aspetti economici. L’economia delle leggi ha un contratto positivo e uno normativo a seconda che essa si occupi prevalentemente dell’analisi degli effetti economici delle leggi o si preoccupi invece di considerare le norme come uno strumento di governo per raggiungere determinati obiettivi.

Dal punto di vista normativo una legge è introdotta per raggiungere dei benefici sociali, ma ogni legge comporta dei costi sociali. L’economia del benessere, quindi, richiede che la giustificazione di una legge consente: di interrogarsi sulla RATIO economica di una norma; di studiare le limitazioni nell’esercizio del diritto che devono essere introdotte per evitare che in date situazioni i costi della legge superino i suoi benefici; e di riflettere sull’osservazione dei mutamenti nei contesti sociali cui si applica la legge modificano il suo saldo benefici-costi, comportando la nascita, l’evoluzione e l’estensione della norma.

Esistono molti modi per applicare le leggi e, a causa di ciò, è necessario determinare come selezionare la modalità ottimale di intervento. I principali metodi di applicazione delle leggi prevedono la definizione: dello STADIO D’INTERVENTO, che può essere di prevenzione o successivo; della FORMA DELLA SANZIONE, la quale può essere monetaria o non monetaria;e dello STADIO DELLA DENUNCIA, che può derivare dall’iniziativa privata o dal controllo pubblico.

I costi di transazione sono i costi relativi alla pianificazione, adattamento e controllo dell’insieme dei compiti con cui si articolano le diverse strutture amministrative. I costi di transazione più comuni in politica sono: il contratto politico, in quanto i contratti sono incompleti e gli agenti incontrano costi di transizione sia per formulare al meglio contratti stessi in condizioni di informazione imperfetta, sia per ricorrere a istituzioni legali per rendere esecutivo il contratto al manifestarsi di condizioni inattese; la struttura di governo, in quanto l’organizzazione incontra nel suo funzionamento costi di transizione per riconoscere incentivi agli agenti o ai lavoratori interessati,per controllarli, per fare eseguire i loro compiti etc; l’informazione asimmetrica in politica, in quanto anche in politica ottenere delle informazione ha nascosto; l’opportunismo dei politici, in quanto se le azioni degli agenti non sono completamente osservabili, si apre la strada a comportamenti opportunistici e il principale sostiene costi sia per incentivare il comportamento desiderato dall’agente, sia per controllarlo o per punirlo; e la specificità di alcune azioni politiche (in economia si considerano specifici quegli investimenti che sono irreversibili in quanto fatti per un determinato cliente). I rimedi a tali costi di transazione sono: un ‘impegno politico inderogabile, infatti poiché l’opportunismo e l’incoerenza discendono da una possibile libertà post-contrattuale, il rimedio per il politico è prendere impegni inderogabili che limitano questa libertà; un’azione anticipata di chiusura, infatti un politico può intraprendere un’azione non perché giustificata dai fatti, ma solo per mostrare e per rendere credibili le proprie preferenze o per restringere in futuro la propria libertà d’azione; una delega politica, e la reputazione in politica, infatti il politico può fondare la propria credibilità sulla sua reputazione.

Capitolo 8

LE FUNZIONI DEI BUREAU

L’allocation bureau è un ufficio dello Stato che si occupa di conservare l’efficienza del sistema economico. Secondo il Teorema del Second Best, non è vero che una situazione nella quale un numero maggiore di condizioni di ottimo paretiano sono soddisfatti è necessariamente superiore ad una situazione in cui un numero minore di esse sono soddisfatte. Il teorema del second best consente due importanti risultati normativi: qualora un impedimento si frapponesse nel consentire la soddisfazione di tutte le condizioni di efficienza statica, si raggiungerebbe comunque un risultato inferiore rispetto all’ottimo paretiano; e, l’esistenza di una soluzione di secondo ordine non consente di concludere che di fronte ad un unico impedimento ci si deve limitare a garantire la soddisfazione delle rimanenti condizioni di efficienza, infatti, anche di fronte ad un asola deviazione è necessario che l’intera soluzione del sistema di mercato sia rivista. Le condizioni di fallimento del mercato sono riconducibili a quattro classi fondamentali: i nuovi mercati sono imperfetti; i mercati sono incompleti (non esistono mercati per tutti i beni); esistono asimmetrie informative; e nel sistema esistono beni particolari non riferibili ai criteri della proprietà privata. In particolare esistono ben 7 fallimenti di mercato: i mercati di monopolio; la presenza di effetti esterni nella produzione e nel consumo; i beni pubblici; l’assenza di mercati contingenti e a termine; l’informazione asimmetrica sui prezzi e sulla qualità; i beni meritori; e i beni comuni.

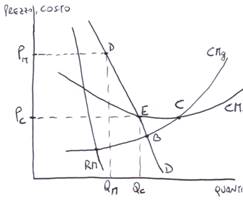

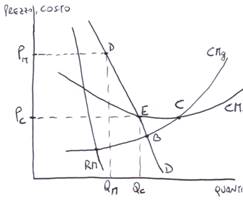

Il Monopolio è un mercato in cui vi è una sola impresa. Essa ha potere di monopolio e fissa un prezzo superiore al costo marginale. Di fronte ad una situazione di monopolio si rendono quindi necessari gli interventi correttivi dell’allocation bureau. Infatti la legislazione antitrust cerca di ripristinare l’efficienza statica impedendo la formazione di monopoli. Una legge, infatti, può dichiarare illegali le intese che hanno lo scopo di restringere la concorrenza, può impedire l’abuso di posizione dominante etc. poiché il potere di monopolio porta ad un prezzo superiore al MC, con il controllo dei prezzi si fissano dei prezzi massimi di vendita per impedire che il mercato di discosti delle condizioni di efficienza nel breve periodo, ma non ha effetto nel lungo periodo (neutralità della moneta).

IL MONOPOLIO DEI MERCATI CONTENIBILI.

Se nuove imprese possono entrare ed uscire liberamente e senza costi dal mercato, il mercato è detto contenibile. In questo caso, anche in un monopolio si può avre un equilibrio concorrenziale dettato dalla minaccia di entrata. Si supponga che l’impresa, comportandosi da monopolista, fissi il prezzo Pm che massimizza il profitto. Se l’entrata e l’uscita sono libere, nuove imprese saranno attratte dai profitti dell’incumbent e cercheranno di catturarne una parte entrando nel mercato e offrendo lo stesso prodotto ad un prezzo minore. Ciò provocherà una riduzione del prezzo fino a quando si collocherà nel punto E, annullando tutti i profitti. Quindi la tattica del colpisci e fuggi conduce all’equilibrio di concorrenza perfetta, annullando il profitto anche in presenza di economie di scala. L’allocation bureau dovrebbe allora agire in modo da garantire l’assenza di barriere all’impresa nei mercati e, in particolare, garantisce la contendibilità dei mercati cercando, per quanto possibile, di eliminare i costi irrecuperabili.

IL MONOPOLIO NATURALE:

GESTIONE DIRETTO, REGOLAMENTAZIONE O COMPLETAZIONE PER IL MERCATO.

È però stato sostenuto che la contendibilità dei mercati non è sufficiente a garantire il contenimento dei profitti delle imprese esistenti. Queste imprese hanno infatti una posizione di vantaggio rispetto a quelle entranti: possono enunciare strategie volte a scoraggiare la concorrenza potenziale ( vantaggio della prima mossa). Infatti esse possono adottare un Politica Predatoria Dei Prezzi. Affinché quest’ultima abbia effetto è necessario che la minaccia sia credibile, inoltre, affinché tale politica sia razionale, il gioco deve essere ripetuto all’infinito e l’informazione deve essere asimmetrica.

Se la funzione di costo medio è sub-additivo, cioè ( manca formula) si ha una concorrenza di monopolio naturale. Se il monopolista adotta la strategia del massimo profitto, il prezzo è Po, ma l’allocazione è inefficiente. Se invece adotta una politica efficiente fissando il prezzo uguale a MC, l’impresa produce in perdita. La soluzione a tale problema consiste nell’imporre all’impresa di praticare un prezzo pari al costo marginale e di coprire la perdita tramite trasferimenti pubblici. Una soluzione di compromesso a tale problema (Second Best), consiste nel fissare un prezzo uguale al costo medio in modo che l’impresa possa pareggiare i costi senza ricorrere ai trasferimenti pubblici.

Si ha un’esternalità quando un comportamento di un agente modifica le preferenze di un altro senza modificare i prezzi. La caratteristica essenziale dell’esternalità è che esistono dei beni che influenzano l’ambiente in cui i consumatori o le imprese agiscono e pertanto dovrebbero avere un valore. Però, sia per le loro caratteristiche che per un’insufficiente definizione dei diritti di proprietà, non esiste un mercato in cui questi beni possano essere scambiati. Questo fenomeno è un tipico caso di fallimento di mercato. In presenza di esternalità, il mercato non funziona come un meccanismo automatico di distribuzione efficiente delle risorse, cioè si interrompe la corrispondenza tra concorrenza ed efficienza statica. È necessario, pertanto, l’intervento dell’allocation bureau per correggere gli effetti indesiderati di una inefficiente distribuzione delle risorse. COASE dimostra che se gli agenti interessati potessero contrattare liberamente i diritti di proprietà come se si trattasse di un qualsiasi altro bene, si raggiungerebbe un’allocazione ottimale delle risorse indipendentemente dalla distribuzione iniziale dei cittadini stessi. Un’altra soluzione è la TASSA DI PIGOU, con la quale l’impresa è chiamata ad indennizzare la comunità del danno arrecato.

I BENI PUBBLICO sono dei beni non rivali non escludibili, in quanto il consumo da parte di un soggetto non preclude ad altri soggetti di usufruirne, inoltre è troppo costoso o impossibile escludere un soggetto dal consumo d itale bene. La condizione di SAMUELSON stabilisce il criterio di efficiente allocazione delle risorse tra consumi privati e consumi pubblici: (formula ) per i beni pubblici e (formula ) per i beni privati. Quindi nel caso dei beni privati il prezzo di mercato è unico e ciascun soggetto consuma un ammontare diverso del bene fino a eguagliare l’utilità marginale al prezzo. Nel caso dei beni pubblici, invece, poiché il consumo è il medesimo e quindi l’utilità marginale è diversa da consumatore a consumatore, allora ciascun cittadino è chiamato a pagare un prezzo diverso pari alla soddisfazione che ne ricava al marginale. Per determinare il prezzo da pagare, lo Stato dovrebbe quindi individuare il SMS di ciascun individuo. Sfortunatamente i cittadini non hanno alcun incentivo a rivelare la loro vera disponibilità a contribuire. A causa di ciò l’offerta di tali beni sarà dimensionata rispetto alle reali esigenze di efficienza allocativa. Quest’ultimo è un tipico caso di Free Rider. Ma se ogni cittadino nasconde le proprie preferenze, allora il risultato sociale è la produzione di un bene pubblico diversa da quella efficiente. L’intervento dell’allocation bureau è quindi necessario non solo per produrre il bene pubblico perché nessun privato sosterrebbe un costo per produrre un bene che non potrebbe essere venduto, ma anche per scoprire le vere preferenze di ciascun cittadino.

Se i mercati sono completi e in concorrenza perfetta, non vi sono ragioni di intervento per un al location bureau, ma nella realtà i mercati non sono completi. Infatti possono mancare alcuni mercati a pronti, a termine e contingenti. L’assenza dei mercati a pronti può essere ricondotta: all’esistenza di esternalità, oppure può essere l’effetto di beni non rivali e non escludibili che non possono avere un mercato. L’assenza di mercati a termine e contingenti può invece essere attribuita sia alla presenza di elevati costi di transazione, sia alla limitata conoscenza e capacità predittiva degli agenti. Gli interventi possibili per rimediare all’incompletezza dei mercati futuri e contingenti sono due. La prima alternativa prevede che il bureau interviene per completare i mercati, aprendo quelli che il sistema privato non può o non ha convenienza ad aprire. La seconda alternativa interviene se l’allocation bureau si trova nell’impossibilità tecnica di aprire tutti i mercati. Infatti l’ufficio può sempre intervenire introducendo un sistema di attività finanziarie il cui rendimento permette al settore privato di replicare tutte le condizioni ottimali che identificano i mercati completi. Se entrambe queste soluzioni risultano impraticabili, spetta sempre al bureau affrontare dei codici che permettono di risolvere le dispute legali tra gli agenti che possono sorgere da eventi imprevisti.

L’informazione è asimmetrica quando i soggetti che partecipano allo scambio non hanno lo stesso livello di informazione. Vi sono due tipi di informazione asimmetrica. Il primo, noto con il nome di Moral Hazard, prevede che le parti interessate allo scambio abbiano ex-ante informazioni uguali, ma informazione differenti ex-post. La parte che deve agire in esecuzione del contratto ha quindi delle informazioni nascoste (Hidden Information) o può compiere delle azioni nascoste (Hidden Action). Il secondo tipo di asimmetria è quello in cui una delle parti ha informazioni che l’altra non ha prima del contratto, in questo caso si parla di Selezione Avversa.

Beni di Merito (Musgrave) = atteggiamento paternalistico, cioè quando un individuo è nell’impossibilità di scegliere da se il suo migliore consumo, si ammette che un altro individuo si sostituisca a lui nel decidere le sue scelte. Beni comuni = sono delle proprietà condivisibili a tutta la collettività, la quale permette ad un elevato sfruttamento delle risorse. Compito della allocation Bureau e quella di introdurre un sistema di licenze: Diritto per entrarvi, un sistema a sorteggio.